AIエージェントに選択肢 「AWS re:Invent 2025」レポート 第9回

AWSのインフラ・ハードウェア担当からみたAI時代の最適化

推論ワークロードの時代 20年積み上げてきたAWSのビルディングブロックは通用するのか?

2025年12月25日 10時30分更新

ベクター検索はなぜ必要か? 統合した埋め込み手法が重要な理由

ステージに戻ったデサントス氏は、AI開発で重要なベクター検索について解説を進めて行く。

ベクター検索を説明すべく、デサントスが披露したのは、犬の写真。これを見たとき人間は、犬の表情や形態はもちろん、自分の犬や犬のような顔の人、犬のような食べ方など、犬そのもの以外の要素と関連性を想起する。コンピューターにとってのベクター検索も同じ処理になる。「ベクターをシンプルに言えば、各次元に意味あるデータポイントだ」とデサントス氏は語る。

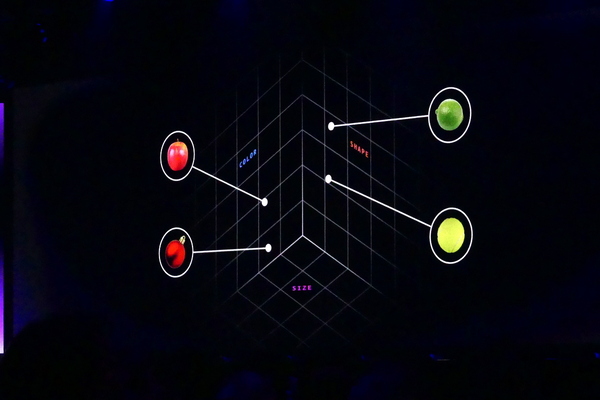

たとえば、リンゴ、赤いクリスマスオーナメント、レモン、テニスボールの4つのオブジェクトを「色」「サイズ」「形」という3次元のベクターで数値化する。これにより、コンピューターはベクターの距離として近いモノを近傍検索によって検出することができる。黄色いレモンとテニスボールは、黄色とサイズでベクター値として近い。

もちろん、実際に利用されるベクター数はずっと多い。「豊かなベクター表現では3000次元になることもある」(デサントス氏)。データはベクター埋め込み(エンベディングモデル)によって数値化され、多次元空間の点として表現される。AIはこのベクター表現により、形や色を認識し、隣接した点同士をクラスター化して、特徴を把握している。

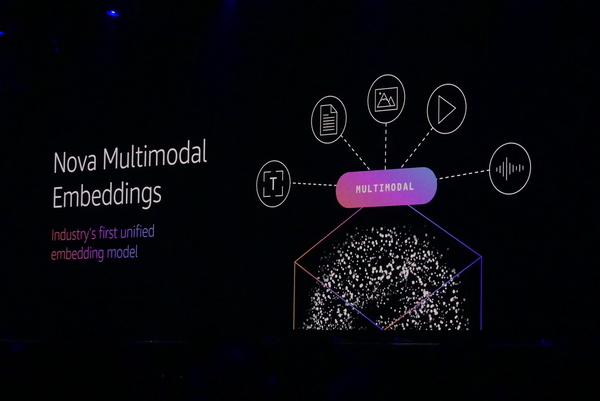

企業においては、テキスト、ドキュメント、イメージ、動画、音楽などさまざまな種類の非構造データがある。しかし、今まではコンテンツタイプごとの異なるエンジンを用いていたため、統合した検索手法が利用できるベクター埋め込みが難しかった。これを解決するのが、あらゆるコンテンツタイプを共通フォーマットでベクター埋め込みできる「Nova Multimodal Embeddings」になる。

ベクター検索をあらゆるデータソースに 最新のAmazon S3 VectorsもGAに

デサントス氏がアピールしたのは、埋め込み手法を共通化するだけではなく、AWSのさまざまなサービスで同じベクター検索が可能になるという点。「新しいデータベースを学ぶために時間と労力を投じる必要はない。アジリティとコスト削減を得られる。そのためにわれわれはポートフォリオの広さと深さ、両方に取り組んでいる」とデサントス氏は語る。

ベクター検索を実現するのは、Amazon AuroraやAmazon RDS、Amazon DocumentDBのような各種データベース、Amazon OpenSearchやAmazon Kendraのような検索エンジンなど。たとえばAmazon OpenSearch Serviceは、完全一致のテキスト検索のみならず、セマンティック検索、ハイブリッド検索、マルチモーダル検索も可能になっている。

そしてAmazon S3 VectorsもいよいよGAとなった。安価なAmazon S3でベクターデータの保存が可能になったことで、アップロードや保存、ベクター検索のコストを最大90%削減するという。しかも、既存のAmazon S3バケットの作成と同じ方法でスケール性の高いベクターインデックスを生成できる。

巨大なベクター空間から効率的に検索するべく、Amazon S3 Vectorsでは近似最近傍アルゴリズムを用いて、もっとも近くのベクターポイントを精度よく探し出し、遅延も最低限に抑えている。実際に20億ベクターで100ミリ秒という遅延を実現しているという。

デサントス氏は、「4ヶ月で25万以上のベクターインデックスを作成した。100億以上のベクターを取り込み、10億件以上の検索が実施されている」とアピール。ゲストとして登壇したTwelveLabs ジェー・リーCEOは、動画という巨大データからAmazon S3 Vectorsを用いてベクター埋め込みを実現し、インサイトに変えていくまでのフローと価値をアピールした。

今やほとんどの推論ワークロードをこなすTrainium

AIのワークロードは莫大で、それを動かすにはコストと電力を消費する。この課題を解消するのがTrainiumになる。Trainiumは名前と異なり、さまざまなワークロードに対応しており、学習のみならず、従来Inferentiaがカバーしていた推論のワークロードにも最適化されている。またTranium3は、もっとも要求の厳しいワークロードでも、従来から40%削減できるという。

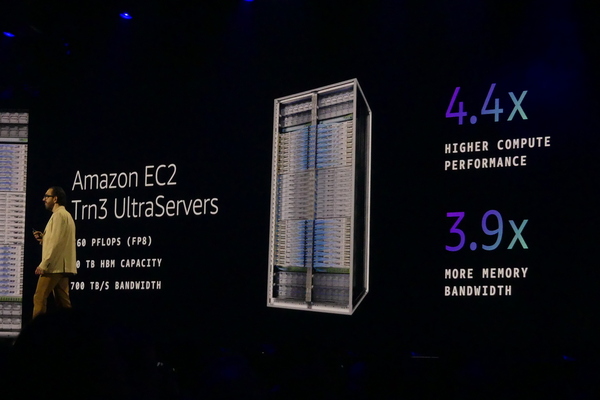

最新のTrainium3を最大144基搭載可能な専用サーバーが「Amazon EC2 Trainium3 UltraServers」になる。Trainium、Graviton、Nitroという3つのAWSカスタムチップを1つのサーバーボードに統合されいおり、専用のヘッドノードを不要。各ノードはノンストップで交換可能で、最大36台のノードはラックの中央にあるニューロンスイッチで相互接続されている。

Amazon EC2 Trainium3 UltraServersは、最大360PFPS(FP8)という浮動小数点演算性能を実現している。20TBのメモリでは、700TB/sの帯域幅を実現。これらは従来Trainium2搭載モデルに比べて、性能は4.4倍。メモリの帯域幅も3.9倍に上がっている。

AWSでは顧客のワークロードをより速く、効率的に革新的な方法で実現することにこだわっているという。「ベンチマークにこだわっていません。お客さまのワークロードにこだわっています」とデサントス氏は語る。また、AIで頻出する計算処理を効率的に行なうためのマイクロアーキテクチャの最適化も実施している。

Trainium3のハードウェアにアクセスできるNRIも公開

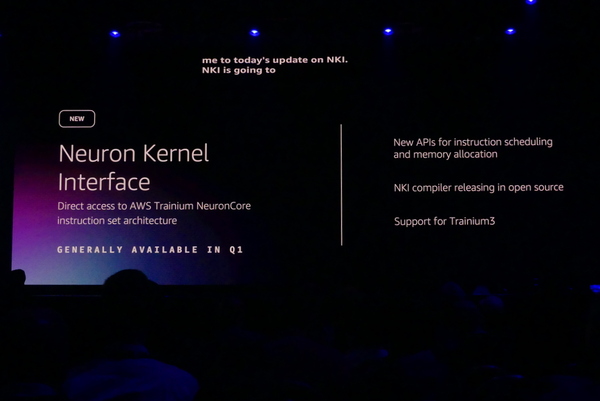

ユーザー企業自身が独自のAIワークロードをTrainium3に最適化することも可能だ。今回発表された「NKI(Neuron Kernel Interface)」は、使い慣れたPython環境からTrainiumのハードウェアに直接できるインターフェイスになる。API経由で命令のスケジューリングやメモリ管理が行なえるだけでなく、NKI専用言語で記述したコードを、実行形式にコンパイルすることも可能になる。コンパイラーはOSSで公開される。

また、Trainium3ハードウェア状態を把握するプロファイラーも用意されており、Neuron Explorerを使ってボトルネックの検出や最適化も実現。新たにPyTorchのネイティブサポートも発表され、演算処理をCUDAからNeuronに変更するだけでTrainiumを利用可能になるという。

ゲストとして登壇したのは、Decart CEOのディーン・ライターズドルフ氏。Decartの「リアルタイムライブビジュアルインテリジェンス」は画像や動画をリアルタイムにアニメ風や別のキャラクターに変換できる。すさまじい負荷がかかるが、Trainiumの採用に加え、NKIによる最適化を施すことでリアルタイムな変換を実現しているという。

最後、デサントス氏は、AIが必要とするインフラについて、「基本がますます重要になっている。AI以前の世界の遺物ではない。それどころか、あらゆるアプリケーションが構築される土台だ」とアピール。その上で、「AWSは20年間行なってきたの同じように制約を取り払い、ビルディングブロックを構築し、どんな未来が来ても、みなさんが進めるように支援していく」と語る。

この連載の記事

-

第13回

ビジネス・開発

ありがとうヴァーナー 「自らの仕事に誇りを持て」は働くすべての人に向けたエール -

第12回

ビジネス・開発

AIに「丸投げ」は厳禁 AWSのIDE「Kiro」はなぜ仕様駆動型開発に行き着いたのか? -

第11回

ビジネス・開発

ダ・ヴィンチに学べ AI時代に求められる「ルネサンス・デベロッパー」という生き方 -

第10回

ビジネス・開発

Amazon ボーガスCTOが最後の基調講演 「AIは開発者の仕事を奪うのか?」への直球な答え -

第8回

TECH

ラスベガスで珠玉のインドカレー こりゃあ店も混むわけだ -

第7回

クラウド

200万人が視聴し、6万人がラスベガスに集ったre:Invent 2025 4つの基調講演で見えたAWSの進む道 -

第6回

ビジネス・開発

1人で100機のロケットを打ち上げるため、Blue OriginにはAIエージェントが必要だった -

第5回

クラウド

教えて、ほめて、注意して AWSが考える「本番に強いAIエージェントの育て方」 -

第4回

クラウド

AWSガーマンCEOが10分で怒濤の新発表25連発 LTチャレンジにレガシーAWSファンも大歓声 -

第3回

ビジネス・開発

3強LLMの時代、Amazon BedrockはなぜマニアックなAIの品揃えにこだわるのか? - この連載の一覧へ