AIエージェントに選択肢 「AWS re:Invent 2025」レポート 第2回

GPUと専用チップで実現する最強のAIインフラ

カスタムシリコンがAIの未来を切り拓く AWSが自社開発チップの好調ぶりをアピール

2025年12月03日 09時00分更新

2025年12月1日、Amazon Web Services(AWSはフラグシップイベント「AWS re:Invent 2025」を開催。2日の基調講演に登壇したAWS CEOのマット・ガーマン氏は、AIエージェントへの注力をアピール。新発表としてNVIDIA GB300を搭載した新インスタンスや特定顧客向けのAIインフラである「AWS AI Factories」などを発表し、AWSオリジナルのAIチップであるTrainiumの最新動向も披露した。

最強のAIインフラをユーザー向けに提供する「AWS AI Factories」発表

2025年のトレンドとなったAIエージェントに向けて、AWSもサービスの強化を進めている。ガーマン氏は、2006年の創業時から「発明の自由」を追求してきたAWSがAIエージェントに取り組むのは必然と説明。「技術的な興味から、真の価値をもたらすものへと変化し、あらゆる企業で、もっと発明が起こる」とアピールし、AIエージェントで重要なAIインフラ、推論プラットフォーム、組織内のデータ、エージェント向けツールの4つについて説明した。

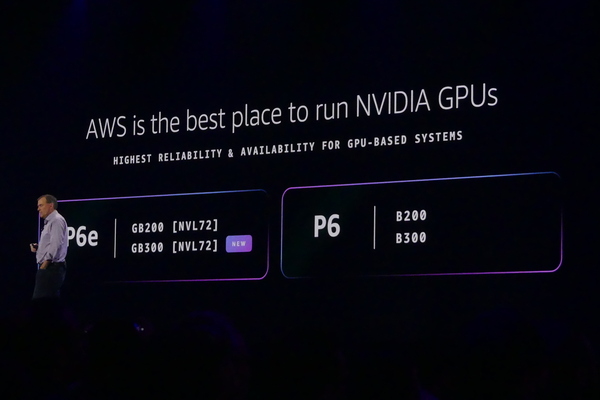

冒頭に披露したのは、性能と拡張性が欠かせないAIインフラだ。AWSはNVIDIAとのパートナーシップを通じて、最新のGPUの配備にこだわってきた。今回はNVIDIAの「GB300 NVL72」を搭載した「Amazon EC2 P6e-GB300インスタンス」と「P6e-GB300 UltraServers」を追加された。GB200と比較して、2倍のネットワーク帯域、1.5倍のメモリが提供され、もっとも要求の厳しいAIワークロードに対応する。プロダクションレベルでの1兆規模パラメーターのモデルの推論も可能になるという。

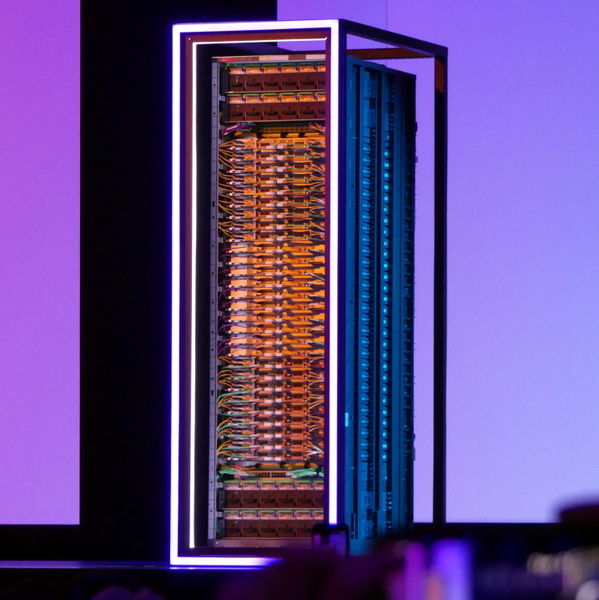

新たに発表された「AWS AI Factories」はスケール可能なAIインフラを特定顧客向けに提供する。NVIDIAのGPUやAWSのTrainiumチップを搭載した最新のAIコンピューティング環境、低遅延なネットワーク、高性能なストレージ、セキュリティサービスなどを包括的に提供し、Amazon BedrockやSage Maker AIも利用可能。エンタープライズや政府機関を対象としたコンプライアンスやソブリン(主権性)性を満たしつつ、自社データセンターで最新AIインフラの運用と統合管理が実現する。

推論のほとんどはTrainiumで実行 配置数100万を超える

また、ハイパフォーマンスな推論を可能にするAmazon EC2 Trainium 3 UltraServersの提供開始も発表された。最大144ものTrainiumチップを利用でき、362(FP8)ペタFLOPsを4倍の低遅延で実現。OpenAIのGPT-OSSのモデルを用いた前世代のTrainium 2 UltraServersと比べて、3.9倍のメモリ帯域幅、4.4倍の演算パフォーマンス、4倍以上のエネルギー効率で推論の高速化が達成されたという。

現状、Amazon Bedrockの推論のほとんどはTrainium上で実行されており、AnthropicのモデルはTrainiumのクラスターである「Project Rainier」で実現されているという。Trainiumの配置数も100万を超えることが発表された。

次世代のTrainiumであるAWS Trainium 4の開発意向も発表された。現行のTrainium 3の6倍(FP4)の高速化、4倍のメモリ帯域、2倍のキャパシティを目指すという。チップ間インターリンクであるNVIDIA NVLink Fusionをサポートし、NVIDIA MGXラックとシームレスに統合されている。GPUとTrainiumを統合したコスト効果の高いラックスケールのAIインフラが実現できるという。

AWS re:Invent 2025の現地レポートは引き続きお送りする。

この連載の記事

-

第13回

ビジネス・開発

ありがとうヴァーナー 「自らの仕事に誇りを持て」は働くすべての人に向けたエール -

第12回

ビジネス・開発

AIに「丸投げ」は厳禁 AWSのIDE「Kiro」はなぜ仕様駆動型開発に行き着いたのか? -

第11回

ビジネス・開発

ダ・ヴィンチに学べ AI時代に求められる「ルネサンス・デベロッパー」という生き方 -

第10回

ビジネス・開発

Amazon ボーガスCTOが最後の基調講演 「AIは開発者の仕事を奪うのか?」への直球な答え -

第9回

クラウド

推論ワークロードの時代 20年積み上げてきたAWSのビルディングブロックは通用するのか? -

第8回

TECH

ラスベガスで珠玉のインドカレー こりゃあ店も混むわけだ -

第7回

クラウド

200万人が視聴し、6万人がラスベガスに集ったre:Invent 2025 4つの基調講演で見えたAWSの進む道 -

第6回

ビジネス・開発

1人で100機のロケットを打ち上げるため、Blue OriginにはAIエージェントが必要だった -

第5回

クラウド

教えて、ほめて、注意して AWSが考える「本番に強いAIエージェントの育て方」 -

第4回

クラウド

AWSガーマンCEOが10分で怒濤の新発表25連発 LTチャレンジにレガシーAWSファンも大歓声 -

第3回

ビジネス・開発

3強LLMの時代、Amazon BedrockはなぜマニアックなAIの品揃えにこだわるのか? - この連載の一覧へ