クラウドでもgpt-ossを活用できる

ローカルでgpt-ossを動かすのが難しい場合は、クラウド経由で利用する方法もある。代表的なのが「Groq」と「Hugging Face Inference API」の2つだ。

Groqは、高速な推論エンジンを提供するクラウドサービスで、gpt-ossにもすでに対応済み。アカウントを作成すればすぐに使い始めることができる。初期利用は無料枠内で可能だが、商用や大規模な利用には有料プランへの移行が必要になる。

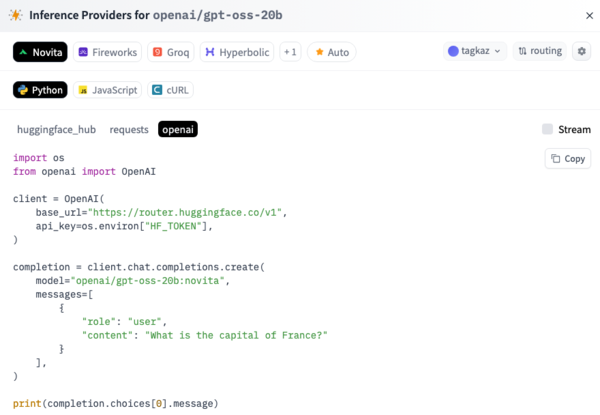

もうひとつの手段であるHugging Face Inference APIは、Hugging Faceが提供するホスティングサービスで、API経由でさまざまなモデルを実行できる。gpt-ossの20Bおよび120Bも公開されており、PythonコードやcURLを使って簡単にアクセス可能だ。こちらも一定の無料利用枠があるが、継続的な利用や高負荷の実行には有料プランへの登録が必要となる。

このように、PCのスペックにかかわらず、クラウド経由でもgpt-ossを試す手段が用意されている。ローカル実行にハードルを感じる場合でも、気軽にその性能を体験できるのは、オープンモデルならではの魅力と言える。

まとめ:OSSでもここまでできる時代に

ローカル環境でOpenAI製の高性能LLM「gpt-oss」を実行できたのは大きな驚きだ。日本語の出力も安定しており、応答速度・精度ともに十分に実用レベル。これがオープンソースとして配布されていること自体が、すでにひとつの事件だと言える。

筆者の環境(Mac M1/16GB)ではメモリ不足により起動できなかったのは残念だったが、WindowsマシンのRTX 4070(12GB VRAM)では問題なく動作した。最適化次第では、さらに幅広い環境でも使える可能性がある。

それにしても、GPT-4相当とも言われるモデルをここまで自由に触れるようにしてしまっていいのか?裏を返せば、OpenAIはGPT-5以降に相当な自信を持っているのかもしれない。

もっとも、これは「Apache 2.0 ライセンス」+「OpenAIのgpt-oss利用ポリシー」のもとで提供されている。完全な自由が保障されたOSSとは言い切れず、用途には一定の制約がある点には注意が必要だ。

1969年生まれ。ウェブサイト制作会社から2003年に独立。雑誌、書籍、ウェブサイト等を中心に、ソーシャルメディア、クラウドサービス、スマートフォンなどのコンシューマー向け記事や、企業向けアプリケーションの導入事例といったエンタープライズ系記事など、IT全般を対象に幅広く執筆。2019年にはタイのチェンマイに本格移住。

新刊:発売中「生成AI推し技大全 ChatGPT+主要AI 活用アイデア100選」、:https://amzn.to/3HlrZWa

この連載の記事

-

第44回

AI

「こんなもの欲しいな」が、わずか数時間で形になる。AIツール「Google Antigravity」が消した“実装”という高い壁 -

第43回

AI

ChatGPT最新「GPT-5.2」の進化点に、“コードレッド”発令の理由が見える -

第42回

AI

ChatGPT、Gemini、Claude、Grokの違いを徹底解説!仕事で役立つ最強の“AI使い分け術”【2025年12月最新版】 -

第41回

AI

中国の“オープンAI”攻撃でゆらぐ常識 1兆パラ級を超格安で開発した「Kimi K2」 の衝撃 -

第40回

AI

無料でここまでできる! AIブラウザー「ChatGPT Atlas」の使い方 -

第39回

AI

xAI「Grok」無料プラン徹底ガイド スマホ&PCの使い方まとめ -

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい -

第34回

AI

ローカルAI、スマホでサクッと動かせる グーグル「AI Edge Gallery」 - この連載の一覧へ