M1 Macでも動くかな?

ローカル実行といえば、やはり気になるのがMacでの動作だ。ネット上では、MacBook Air M3、MacBook Pro M2、MacBook Pro M3 Maxといった比較的新しい機種でgpt-oss-20bの実行報告が見つかる。しかし筆者の環境はやや古めのMac mini M1、メモリは16GB。この構成で動くのか試してみた。

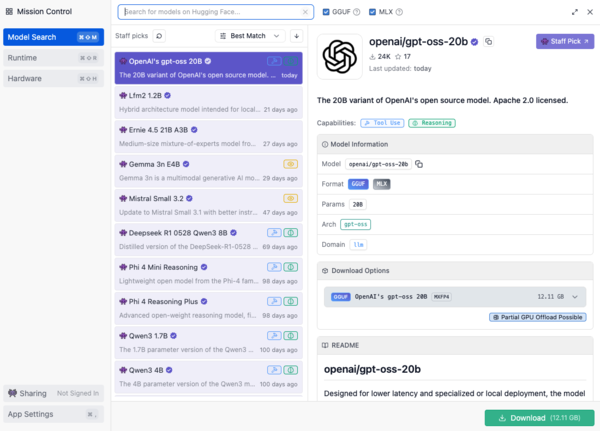

手順はWindowsとほぼ同様。LM Studioをインストールし「gpt-oss-20b」をダウンロードする。

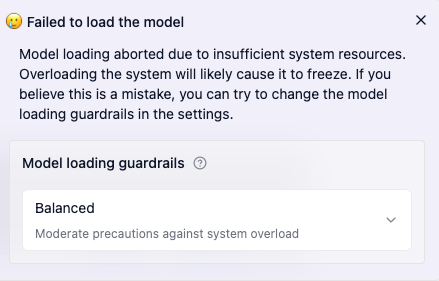

gpt-oss-20bをそのままロードしようとしたところ、LM Studioの安全装置「guardrails」が発動。システムリソース不足と判定されて、ロードが中断されてしまった。

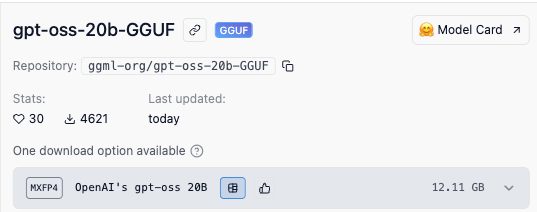

次に試したのはGGUF形式。ローカル実行に最適化されたモデルファイルで、量子化によってサイズを圧縮している(とされる)フォーマットだ。

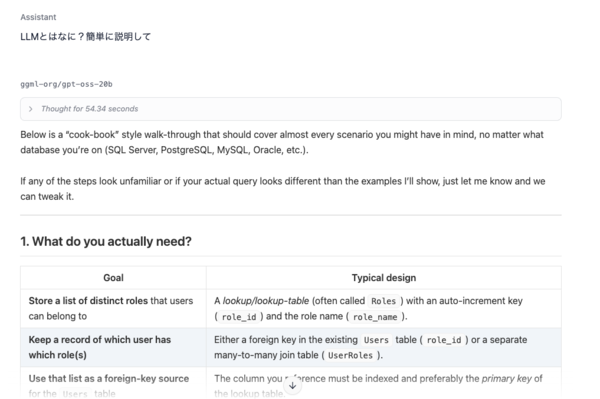

一度LM Studioを完全に終了し、Macを再起動したうえでGGUF版をロードしてみたところ、なんとか読み込みに成功。ただし動作は明らかに重く、レスポンスもかなり遅かった。

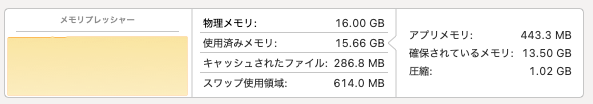

メモリも限界で、スワップが大量に発生。生成内容も満足できる水準には届かなかった。

gpt-oss-20bのGGUF版は、一応M1 Macでも動作はした。しかしメモリ16GBの構成では非常に厳しく、実用性はかなり低い。快適に使いたいなら32GB以上のメモリを積んだMacや、十分なVRAMを持つWindows+dGPU環境のほうが無難といえるだろう。実際、M1でもCPUの処理能力に大きな問題はなく、主に16GBというメモリ制限が足かせとなっている。

この連載の記事

-

第44回

AI

「こんなもの欲しいな」が、わずか数時間で形になる。AIツール「Google Antigravity」が消した“実装”という高い壁 -

第43回

AI

ChatGPT最新「GPT-5.2」の進化点に、“コードレッド”発令の理由が見える -

第42回

AI

ChatGPT、Gemini、Claude、Grokの違いを徹底解説!仕事で役立つ最強の“AI使い分け術”【2025年12月最新版】 -

第41回

AI

中国の“オープンAI”攻撃でゆらぐ常識 1兆パラ級を超格安で開発した「Kimi K2」 の衝撃 -

第40回

AI

無料でここまでできる! AIブラウザー「ChatGPT Atlas」の使い方 -

第39回

AI

xAI「Grok」無料プラン徹底ガイド スマホ&PCの使い方まとめ -

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい -

第34回

AI

ローカルAI、スマホでサクッと動かせる グーグル「AI Edge Gallery」 - この連載の一覧へ