情報カットオフ日時は2023年12月

もちろんLLMの悪癖であるハルシネーションもしっかり観測できた。

プロンプト:2024年のMLBワールドシリーズの結果を教えて

推論過程を読むと、「2024年のワールドシリーズはまだ行われていない(現在は2025年)。」と矛盾したことが書かれている。gpt-ossの情報カットオフ日時は2023年12月のため、それ以降のことを聞かれるとこのような挙動になりそうだ。

ちなみに2024年のロサンゼルス・ドジャースの相手はヒューストン・アストロズではなくニューヨーク・ヤンキースだ。--

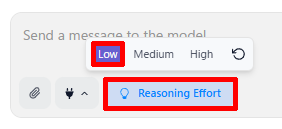

なお、プロンプト入力欄の下に表示されている「Reasoning Effort(推論レベル)」をクリックすると、推論の性能をLow / Medium / Highの3段階から選ぶことができる。Highにするほど複雑な計算や条件分岐を伴う質問に強くなるが応答速度は遅くなる。逆にLowは高速だが推論力は控えめで日常会話や簡単な質問向きだ。環境にあわせて選択しよう。

120Bチャレンジは……

gpt-oss 20Bは、LM Studioを使ってローカルで動かせることが確認できた。では、GPU 80GBクラスが必要とされる120Bモデルはどうだろうか。

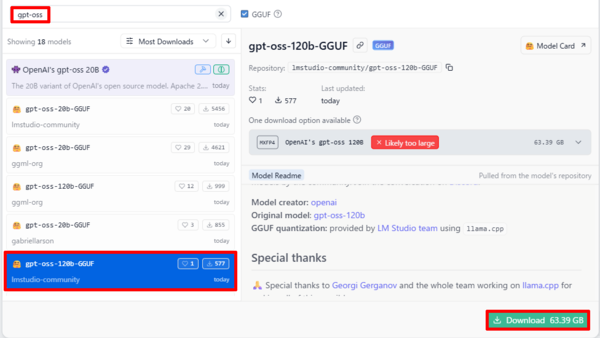

LM Studioの初期表示には20Bモデルしか出てこないが、「gpt-oss」で検索すると、Hugging FaceにアップされたGGUF形式の120Bモデルがいくつか見つかる。今回は、lmstudio communityが提供する「gpt-oss-120b-GGUF(63.39GB)」を試してみた。

GGUF(GPT-Generated Unified Format)は、ローカル実行向けツールで扱いやすいように変換されたモデル形式だ。量子化によってメモリ消費は抑えられるが、このモデルの場合、OpenAIが配布している元のチェックポイント(約60.8 GiB)よりもやや大きく、ファイルサイズが小さいとはいえない。

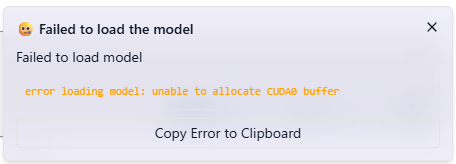

1時間以上かけてダウンロードは完了したが、モデルのロードは失敗。エラーメッセージを見ると「GPU(CUDA)メモリが足りないため、バッファの確保に失敗した」とある。

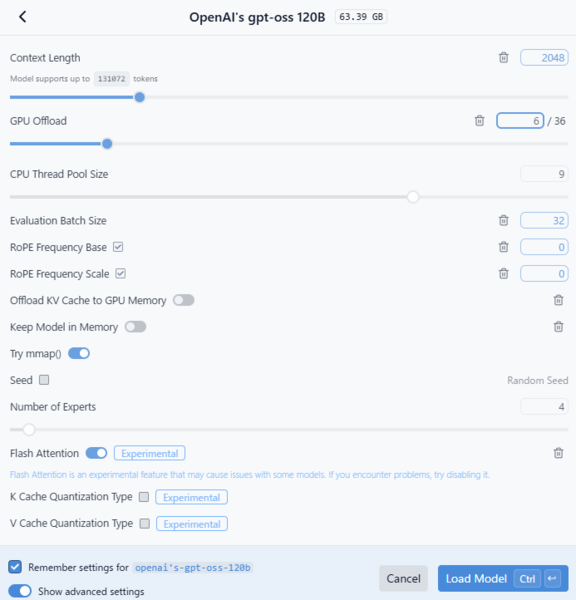

設定を変更しながら再試行してみたが、今回の環境では120Bモデルのロードには至らなかった。ただしこのモデルはOSSであり、今後より軽量な蒸留版や分割ロード対応の形式が登場すれば、ローカル実行も現実的になるはずだ。

この連載の記事

-

第44回

AI

「こんなもの欲しいな」が、わずか数時間で形になる。AIツール「Google Antigravity」が消した“実装”という高い壁 -

第43回

AI

ChatGPT最新「GPT-5.2」の進化点に、“コードレッド”発令の理由が見える -

第42回

AI

ChatGPT、Gemini、Claude、Grokの違いを徹底解説!仕事で役立つ最強の“AI使い分け術”【2025年12月最新版】 -

第41回

AI

中国の“オープンAI”攻撃でゆらぐ常識 1兆パラ級を超格安で開発した「Kimi K2」 の衝撃 -

第40回

AI

無料でここまでできる! AIブラウザー「ChatGPT Atlas」の使い方 -

第39回

AI

xAI「Grok」無料プラン徹底ガイド スマホ&PCの使い方まとめ -

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい -

第34回

AI

ローカルAI、スマホでサクッと動かせる グーグル「AI Edge Gallery」 - この連載の一覧へ