ローカルでgpt‑ossを動かす方法

gpt‑ossの魅力は、学習済みモデルを自分のPCで直接動かせることだ。ローカルで実行すればインターネット接続が不要になり、応答速度も安定する。さらに、会話ログや入力データを外部に送信せずに済むため、プライバシー面でも有利だ。

加えて、ローカル実行なら独自のシステムやアプリと組み合わせた高度な活用も可能になる。たとえば自作のツールと連携させたり、独自プロンプトで継続的に会話させたり、APIレスポンスを中間処理に使うといったカスタマイズも視野に入る。プログラミング知識があれば、ChatGPTでは難しかった実験的な使い方も柔軟に実現できる。

さらに最近では、LangChainやOpenAgentsのようなエージェントツールを使えば、専門的な知識が少なくてもLLMに複数のタスクを実行させるような小規模な自動化やアプリ開発も可能だ。たとえば、複数の文書を読み込んで要点をまとめたり、指定の条件でファイルを分類・整理したりといった処理を、自然言語ベースの指示だけで動かせる。

さらに、自分で開発するのが難しい場合でも、manusのようなノーコードAI開発支援サービスを活用すれば、「gpt‑ossを使ってこういうツールがほしい」と依頼するだけで、ちょっとした自動化アプリやカスタムチャットボットなどを構築してもらうことも可能だ。ローカルモデルの柔軟性は、作れる人だけのものではなくなりつつある。

では実際に、gpt‑ossをローカルで動かすにはどうすればいいのか。環境構築や操作の難易度に応じて、いくつかの方法が用意されている。

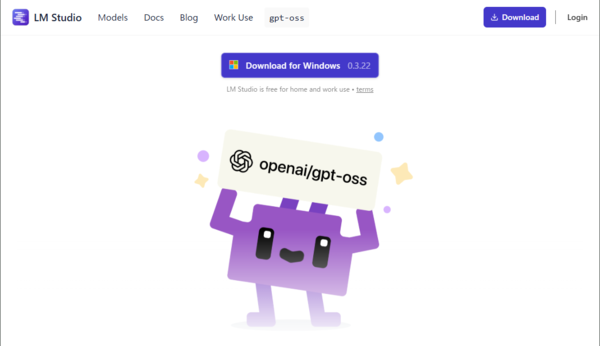

- LM Studio:GUI操作で簡単にモデルをダウンロード&実行できる。初心者におすすめ。

- Ollama:MacやLinux、WSL(Windows Subsystem for Linux)環境で動作する軽量な実行ツール。特にMacではインストールが簡単で、量子化済みモデルを使えば高速に動作する。

- CLI環境(Transformers / vLLM / llama.cpp):PythonやC++で直接モデルを読み込み、スクリプトやサーバーに組み込み可能。自動化や高度なカスタマイズ向き。

ただし、個人PCで現実的に動かせるのは20Bモデルのみ。120Bモデルは80GB級GPUやクラウド環境が前提だ。まずは次に紹介するLM Studioを使ったローカル実行が、最も簡単で確実な方法になる。

この連載の記事

-

第44回

AI

「こんなもの欲しいな」が、わずか数時間で形になる。AIツール「Google Antigravity」が消した“実装”という高い壁 -

第43回

AI

ChatGPT最新「GPT-5.2」の進化点に、“コードレッド”発令の理由が見える -

第42回

AI

ChatGPT、Gemini、Claude、Grokの違いを徹底解説!仕事で役立つ最強の“AI使い分け術”【2025年12月最新版】 -

第41回

AI

中国の“オープンAI”攻撃でゆらぐ常識 1兆パラ級を超格安で開発した「Kimi K2」 の衝撃 -

第40回

AI

無料でここまでできる! AIブラウザー「ChatGPT Atlas」の使い方 -

第39回

AI

xAI「Grok」無料プラン徹底ガイド スマホ&PCの使い方まとめ -

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい -

第34回

AI

ローカルAI、スマホでサクッと動かせる グーグル「AI Edge Gallery」 - この連載の一覧へ