JRA(日本中央競馬会)はOpenShift導入事例を披露、公式サイトへのアクセス急増に対処

レッドハット「未来の技術を“無理せず”使えるプラットフォームに」 2025年の事業方針

2025年07月03日 08時00分更新

コア技術間の摩擦を解消し、新技術を柔軟に取り込めるプラットフォーム

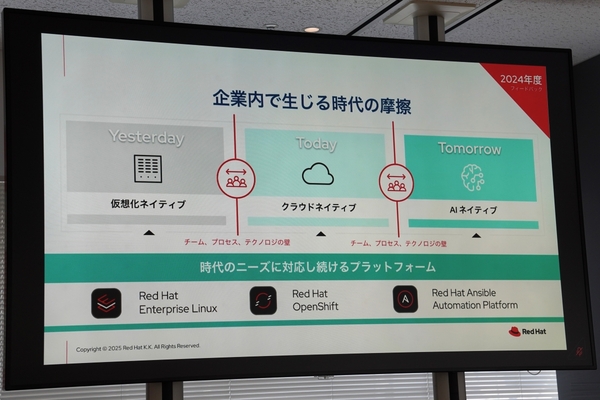

三浦氏は、「RHELやOpenShift、Ansibleは、今や、金融や通信、医療などの社会インフラを支えるソフトウェアとして活用されている」と語る。この前提のもと、昨年度(2024年度)の事業方針には、「プラットフォームの未来をつくる」を掲げた。これは、仮想化、クラウド、AIと、各時代のコアテクノロジーに対応するオープンソースのプラットフォームを展開していく方針である。

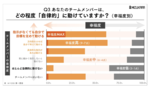

この方針に沿ってビジネスを1年間進めてきた結果、三浦氏は「課題がみえてきた」と言う。仮想化・クラウド・AIは、それぞれ特徴が大きく異なり、それぞれのテクノロジーを支えるチームやプロセスに壁が生じているという。「極端にいうと、LinuxでOA周りを開発してきたチームと、コンテナ登場以降にアプリケーションを開発してきたチームでは、カルチャーやプロセスが異なり、コンフリクト(衝突)が生まれている。AIも、普及するにつれてITガバナンスなどの摩擦が顕在化してきた」(三浦氏)

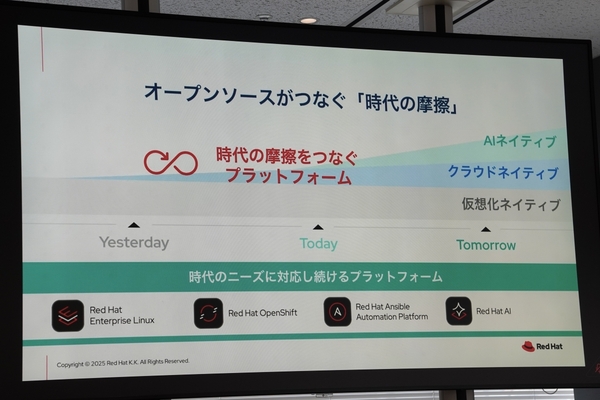

こうした状況を受け、新たに打ち出した方針が「ビジネスとテクノロジーをつなぐ架け橋へ」だ。コアテクノロジーは、入れ替わるのではなく“積み重なっていく”という考えのもと、各時代の技術に対応するのはもちろん、それぞれの間の“摩擦”を解消して、すべての技術を総合的に活用できるプラットフォームを展開していく。これにより、ビジネスとテクノロジーをつなぐ架け橋になることを目標に据えた。

一方で、これまでのコアテクノロジーと比べても、進化のスピードが早いのがAIだ。

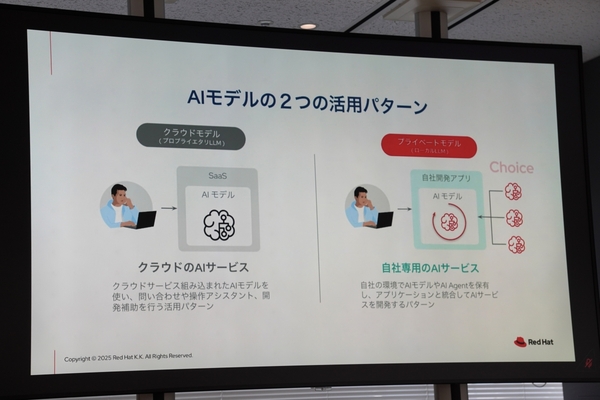

三浦氏は、AI活用のあり方として、クラウドサービスなどに組み込まれたAIモデルを活用する「クラウドモデル」と、自社環境でAIモデルを保有してAIサービスを開発する「プライベートモデル」の2つがあると説明する。レッドハットが支援していくのは、自社データでAI活用をしたい後者の顧客となる。「自社で全部を保有するわけではなく、パブリックなLLMも適材適所で組み合わせる。ハイブリッドで、柔軟性があり、オープンな技術をすぐ採用できるプラットフォームで、AIの世界を支えていきたい」(三浦氏)

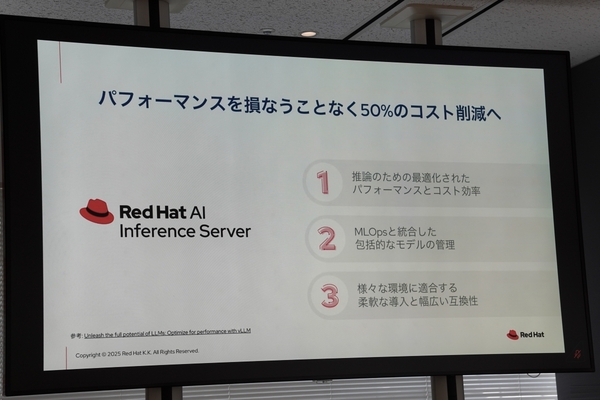

最近では、既存のリソースを活用する“推論”中心のAIモデルに注目が集まっている。同社でも推論サーバーである「Red Hat AI Inference Server」を発表したばかりだ。2024年に買収したNeural Magicの技術要素を製品化したもので、推論性能を損なうことなく、コンピューティングリソースを50%削減できるという。OpenShiftをベースとするため、既存のITリソースの延長線で利用可能であり、オープンソースの強みを活かし、さまざまなLLMやアクセラレーターにも対応する。

三浦氏は、「かつては、プロプライエタリの盤石な技術で、“アップデートせず安全に”という時代もあった。時代は変わって、特にAIの領域では、いち早く最新の技術を取り入れないと競争に勝てない。だからこそ、予測できない未来を柔軟に選択できるプラットフォームを提供することが、われわれのAI戦略だ」と強調した。