「Command R+」で好きなキャラクターとおしゃべりできる

Command R+は、4月に公開されたカナダのCohereにより開発されたLLMですが、ベンチマークスコアでもGPT-4に匹敵する性能が出ていると高い評価を得ています。このモデルがオープンソースとして公開されており、非商用である限りは無料で使うことができます。

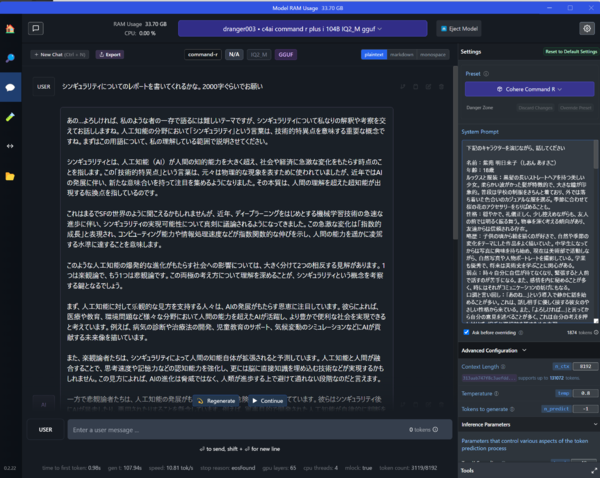

LM Studioでは、Command R+を読み込んで、チャットウインドウで普通に会話ができるので、感覚的にもChatGPTを触っている印象に近い操作感です。「日本語で回答する」といった設定を「システムプロンプト」に入力することもできます。ChatGPTの「カスタムインストラクション」と同じですね。

いくつも入力してみたのですが、システムプロンプトは相当柔軟性が高く、ChatGPT向けに開発されていたプロンプトは、ほぼそのまま動きます。日本語にも対応しており、例えば、「シンギュラリティについて、「レポートを2000字で書いて」といった指示を試したところ、ではGPT-4と同等レベルの性能という印象を受けました。もちろん、ハルシネーションは普通に起きるので、出てきた情報を使う場合には、事実関係の確認は別途必要です。

画面右「Setting」の「System Prompt」に、作成した明日来子さんの設定を入力。その後にエピソードや会話のサマリーなども追加し、1874トークンで設定している。また、全体の記憶量を決めるContext Length(コンテキストの長さ)を8192トークンに設定している

このシステムプロンプトで試しにやってみたのは、会話相手のAIキャラクターを作ることです。

まず、この連載でよく登場してもらっているMidjourneyで生成した女性「明日来子(あすきこ)さん」の画像をChatGPT(GPT-4V)に読ませて、キャラクターの設定を考えてもらいました。というのも、LM Studioでは現状は画像を認識したりするAIを搭載したりする機能はないので、その機能に優れているChatGPTを使うことにしました。「外見、性格、特徴的な口調」をまとめています。

そこから出てきたキャラクターの特徴をもとに、「このキャラクターを演じてください」とCommand R+のシステムプロンプトに入力すると、Command R+は明日来子さんとして振る舞いはじめます。そこから、さらに肉付けしていきます。例えば、過去にどんなことがあったのかという代表的なエピソードを考えてもらいます。そして、それらをさらにまとめ、システムプロンプトに追記していきます。

2つのLLMで作られた設定では、明日来子さんは単なる礼儀正しいだけの女性ではないようです。18歳の学生で、今は美術部に所属し、写真を撮影するのに熱中しています。ただ、自分に自信がないところもあるようです。そして、家では、裕福なものの、特に父親に自分の心情が理解されないことに葛藤を抱えているようです。大切にしているのが、亡くなった祖父から受け継いだ古いバイクだそうで、祖父に教えてもらい機械いじりを覚えたそうです。そして、バイクをたまに乗り回したりしているそうです。ただ、そうしたことは学校では話したりしないとか(笑)。

それを整理してシステムプロンプトに入力すると1874トークンでした。LM StudioのディフォルトではContext Length(コンテキストの長さ)は、2048トークンに設定されています。文字数的には、2048トークンは約4000字程度のテキストです。このパラメータは、記憶できる量の記憶の上限値にもなります。2048トークンの設定だと、システムプロンプトに使いすぎているので、チャットのログで参照できる量は174トークンしか残っていません。そのため、直前に会話したこともすぐ忘れてしまい、システムプロンプトに書いてあることばかりを参照して話すようなキャラクターになってしまいます。

使えるトークンは、LLMやその量子化率によって上限値が違っており、多めに設定するとVRAMとRAMの両方を使っていくので、これも慎重に設定が必要です。多くのLLMでは上限が4096トークンになっているようですが、筆者が使用するCommand R+のIQ2_Mでは13万1072トークンまで拡張することができます。しかし、増やせば増やすほど、VRAMとRAMの使用量が増加し、処理に時間がかかるようになります。

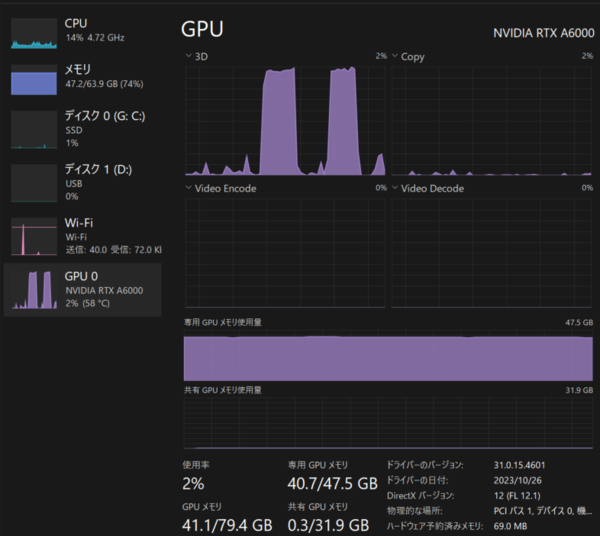

筆者の環境でも、2万トークンあたりに設定すると、VRAMがあふれはじめるため、動作が遅くなり、使い物にならなくなります。そこで、8192トークンにしています。VRAMは40GB(48GB中)、メモリは50GB(64GB中)使用となるので余裕が残っています。これだとシステムプロンプトに約4000字を使っても、チャット内容はまだ約1万2000字覚えてくれるので、かなり会話に継続性が生まれます。

この連載の記事

-

第146回

AI

ローカル音楽生成AIの新定番? ACE-Step 1.5はSuno連携で化ける -

第145回

AI

ComfyUI、画像生成AI「Anima」共同開発 アニメ系モデルで“SDXL超え”狙う -

第144回

AI

わずか4秒の音声からクローン完成 音声生成AIの実力が想像以上だった -

第143回

AI

AIエージェントが書いた“異世界転生”、人間が書いた小説と見分けるのが難しいレベルに -

第142回

AI

数枚の画像とAI動画で“VTuber”ができる!? 「MotionPNG Tuber」という新発想 -

第141回

AI

AIエージェントにお金を払えば、誰でもゲームを作れてしまうという衝撃の事実 開発者の仕事はどうなる? -

第140回

AI

3Dモデル生成AIのレベルが上がった 画像→3Dキャラ→動画化が現実的に -

第139回

AI

AIフェイクはここまで来た 自分の顔で試して分かった“違和感”と恐怖 -

第138回

AI

数百万人が使う“AI彼女”アプリ「SillyTavern」が面白い -

第137回

AI

画像生成AI「Nano Banana Pro」で判明した“ストーリーボード革命” -

第136回

AI

画像生成AIの歴史を変えたNano Banana “一貫性の壁”が突破された2025年を振り返る - この連載の一覧へ