AIが書いた可能性を5段階で判定

アメリカのAI研究開発企業OpenAIは1月31日(現地時間)、ChatGPTなどのAIが書いたテキストと人間が書いたテキストを判定するためのツール「AI Text Classifier」を無料公開した。

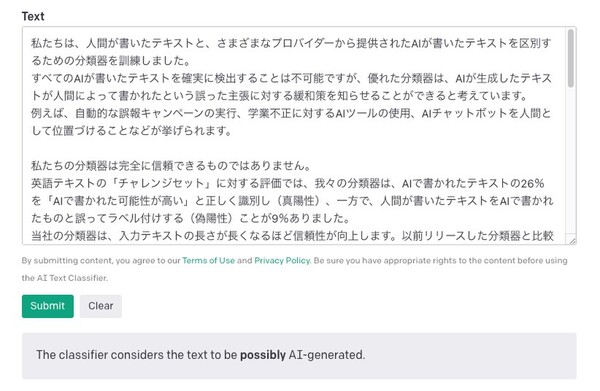

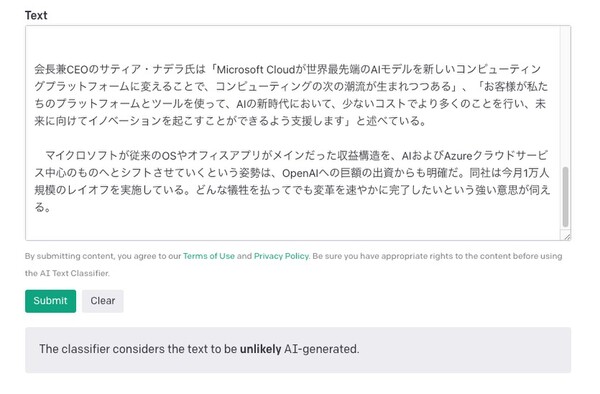

AI Text Classifieに1000文字以上のテキストを入力すると、ツールは判定を行い、結果はAIが生成した可能性が「とても低い(very unlikely)」「低い(unlikely)」「不明(unclear if it is)」「高い(possibly)」「とても高い(likely)」の5段階で表示される。

OpenAIは2019年にも「GPT-2 Output Detector」というツールを公開しているが、それと比較すると近年のAI生成テキストに対する信頼性が大幅に向上しているとしている。

ただしこのツールは完全に信頼できるものではない。OpenAIの英語テキストを使った実験によると、AIで書かれたテキストの26%を「AIで書かれた可能性が高い」と正しく識別(真陽性)した一方で、人間が書いたテキストをAIで書かれたものと誤って識別(偽陽性)したことが9%あったという。

この結果を受けOpenAIは、「1000文字以下のテキスト」「英語以外の言語で書かれたテキスト」「最初の1000個の素数のリストのように人間が書いてもAIが書いても変わらない事柄」などは判別の信頼性が落ちるとしている。

また、AIがこのツールの判定を回避するために再教育された場合や、AIが学習したデータセットと極端に異なる入力があった場合、正しく検出されるかどうか不明だという。

試しにAIが書いた日本語のテキスト(OpenAIのリリースをDeepLで翻訳したもの)をAI Text Classifierに通してみると、「AIが書いた可能性が高い(possibly AI-generated)」と判定された。

次に人間が書いた日本語のテキスト(ASCII.jpに掲載したニュース記事)で試すと「AIが生成した可能性は低い(unlikely AI-generated.)」と判定された。ただし最高評価は「可能性はとても低い(very unlikely AI-generated.)」なので少し迷っているようだ。

OpenAIはこのツールの有用性を調査するため、まだ不完全な状態であるにも関わらず、一般公開している。ここから得られたフィードバックなどを元にAI生成テキストの検出に関する研究を継続し、将来的にはより良い手法を提供するためだという。

また、ChatGPTが教育関係者の間で問題になっていることも認識しており、彼らと協力してChatGPTの機能と制限について議論を続けていくとしている。