GPUサーバーの発熱と消費電力が問題となっている中、水を使って効率的にサーバーを冷却する「水冷方式」に注目が集まっている。一方で、国内データセンターでは空調機を用いた空冷方式が主流なのが現状だ。

こうした状況を変えるべく、NTTPCコミュニケーションズ(NTTPC)とゲットワークス、フィックスターズの3社は、コンテナ型データセンターでの「水冷GPUサーバー」運用における電力効率を検証した。その結果、水冷方式の大規模データセンター並みの電力効率を記録し、商用での有効性を確認したと、2025年12月17日に発表している。

今回のPoCは、2025年10月から11月にゲットワークスが運用する新潟県越後湯沢のデータセンター内で実施された。ゲットワークスが商用環境と同等のGPU専用コンテナ型データセンターを、フィックスターズがGPUサーバーおよび冷却設備、モニタリングツールを用意。そして、NTTPCが、ハードウェアエンジニアリングの観点から検証している。

こうした環境下で、水冷GPUサーバーと空冷GPUサーバーの性能を比較。共に「NVIDIA H100 GPU」を4基搭載し、GPUはもちろん、CPUやメモリ構成も統一した。水冷方式には、サーバーの熱を冷却水で吸収し、その冷却水を水冷ユニット(CDU)内でラック間空調の冷気と熱交換する「Liquid to Air」を採用している。

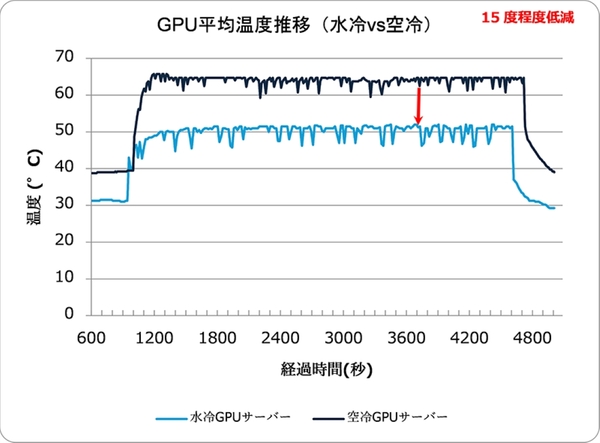

その結果、水冷GPUサーバーは空冷GPUサーバーと比べて、最大負荷時のGPU平均温度が15度(摂氏温度)程度抑制されたという。

加えて、 水冷GPUサーバーを運用するコンテナ型データセンターにて、ラック間空調の制御やコンテナ内のキャッピング(熱を効率よく排出する仕組みや構造設計)を実施した上で、各種データを計測。コンテナ内のサーバールームの電力効率を示すpPUE(サーバールーム内の総消費電力/サーバールーム内のICT機器の消費電力)は「1.114」を記録した。

同指標では、1.1前後が付帯設備の電力効率が優れているとされ、最新の水冷方式の大規模データセンター全体でも1.05~1.2程度の数値になるという。コンテナ型データセンターでの水冷方式の利用は、コンテナ内部は冷却水の循環用設備が中心となり、冷却に関わる電力の大部分がコンテナ外の設備にオフロードされるため、電力効率を高められるのが特徴だ。