AIエージェントは、企業にセキュリティリスクをもたらす

企業システムや業務プロセスの内部に組み込まれ始めた生成AI。「メール文面の作成」や「議事録の要約」といった支援的な用途にとどまらず、「コードの自動生成」「チケット管理」「営業支援」など、ビジネスの意思決定や実行を担うAIエージェントとして急速にその活用が広がっている。わずか数年後には、業務活動の相当部分がAIエージェントによって実行されるようになると予測されている。

この変化がもたらすメリットは明確だ。AIエージェントは人間の作業を補完し、24時間休むことなくタスクを処理できる。だが、その一方で、AIエージェントはセキュリティリスクを拡大させる。

「目標を達成するために必要と判断すれば、AIエージェントは、より多くの権限やアクセスを要求する」。CyberArk SoftwareのCPOを務めるペレツ・レゲブ氏はこう指摘する。従来の自動化ツールとの大きな違いは、人間が予期しない権限要求やアクセスまで行う可能性がある点だ。

レゲブ氏はまず、現在の企業環境に存在するAIエージェントを大きく3つのタイプに分類した。

1つ目は「非エンタープライズ型」。SiriやChatGPT、Gemeniなど、個人利用を前提にした汎用AIが社内ネットワークに持ち込まれるケースだ。「こうしたAIは、内部文書やコードにアクセスできる。そのため、知らぬ間に企業の機密データを外部モデルに学習させてしまうリスクがある」とレゲブ氏は語る。

2つ目は「承認済みエージェント」。Microsoft 365のCopilotのように、企業が公式に承認して導入しているAIである。IT/セキュリティ管理者が利用状況やアクセス権限をある程度コントロールできるため、安全性は比較的高い。

そして3つ目が、最もやっかいな「シャドーエージェント」である。業務効率化のために、開発者が独自に(勝手に)導入したAIツールで、企業は利用を承認していないばかりか、その存在すら把握していない。レゲブ氏は「多くの開発現場では、承認されていないシャドーエージェントがすでに動いている」と警鐘を鳴らす。便利さの裏側で、統制不能なAIが社内のデータやリポジトリにアクセスしている可能性がある。

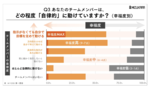

すでに、人間の代わりに動作するシステムを認証するための「マシンID」は増加傾向にある。CyberArkのグローバル調査によると、企業では人間1人に対して平均82個ものマシンIDが存在するという(日本では平均66個/人)。そして、この数字には、まだAIエージェント向けのマシンIDは含まれていない。

レゲブ氏は「ここにAIエージェントが加われば、マシンIDの数は実質的に無限個に近づく」と予想する。もはや「誰が(どのAIエージェントが)」「どの権限で」「何をしたのか」を人間が追うことは不可能に近い。

さらに問題なのは、AIエージェント同士が人間を介さず相互に通信し、他のシステムや外部APIとやり取りを行う点である。そこには新しい通信チャネルが生まれ、情報漏えいや不正操作の経路となる可能性がある。「エージェント間の“会話”そのものが、新しい攻撃面(アタックサーフェス)になる」とレゲブ氏は指摘する。AIエージェントは協調して働くことが想定されているが、そのやり取りの内容や経路を可視化できなければ、セキュリティチームは異常を検知する手がかりを失う。

このように、AIエージェントの活用は「生産性の向上」と「リスクの拡大」が表裏一体で進む領域である。利便性ばかりを重視して統制を後回しにすれば、企業は想定外の影響を受けることになる。人と機械の境界が曖昧になる時代に、AIエージェントをどのように「見える化」し、制御するか。ここに、今後のアイデンティティ管理の核心がある。