Stable Diffusion入門 from Thailand 第11回

画像生成AI「Stable Diffusion」使うなら「ComfyUI」のワークフローが便利です

2024年02月28日 12時00分更新

サンプルワークフローを試す

ここまでは初歩の初歩、まだ単純なText 2 Imageしか試せていない。しかし、さらにワークフローを工夫したり新たに作ったりするにはまだ明らかに知識が足りない。

少なくとも用意されているノードについては一通り使い方を知っておかなければならないだろうし、第三者が開発した拡張機能やカスタムノードなんてものもある。やっぱり「Fooocus」に戻るしかないか……。と弱音を吐きたくもなってくる。

だが心配ない! ネット上にはユーザーが投稿したワークフローが多数公開されている。知識がないならまずは人が作ったものを参考にすればいいのだ。

幸いなことにComfyUIはワークフローの共有がとても簡単。セーブしたワークフロー(.json)をComfyUIでロード、またはドラッグ&ドロップするだけだ。

それだけではない。ComfyUIで生成した画像にはすべてメタデータとしてワークフローが入っているため、画像をロードまたはドラッグ&ドロップするだけでその画像を生成したワークフローがそのままの状態で再現できるのだ。それを元にプロンプトを変えたりノードの接続を改造したりしていけばいいということだ。

ではさっそくComfyUIのサンプルワークフローが多数掲載されている公式のComfyUI_examplesを見てみよう。

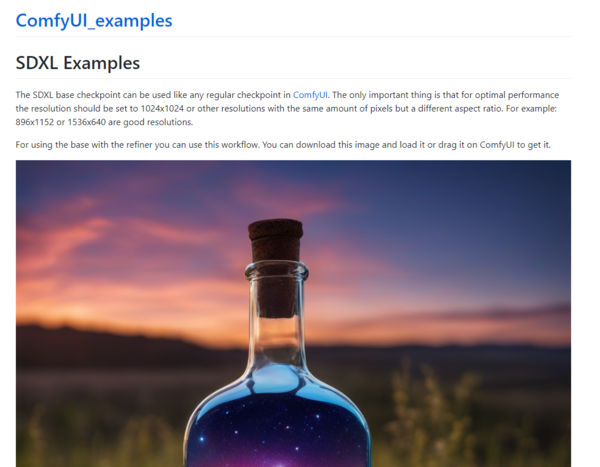

「SDXL」のサンプルページ。ここに表示されてある瓶の画像をデスクトップにセーブする。

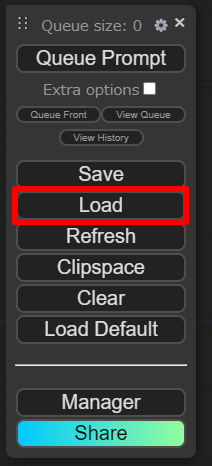

ComfyUIの操作パネルにある「Load」をクリック。

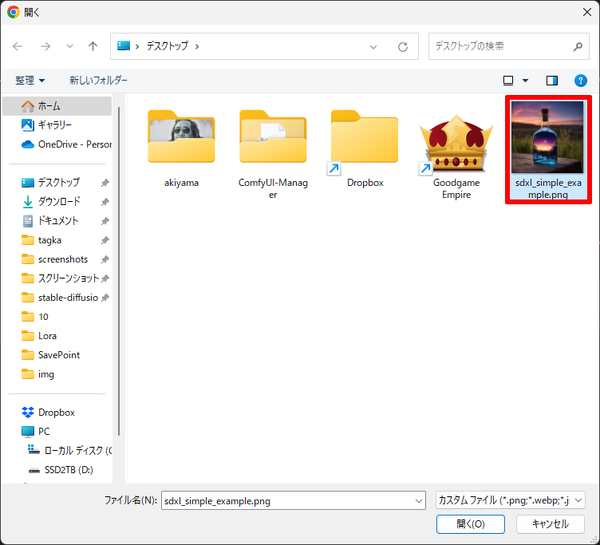

さっき保存した瓶の画像をロードしよう。

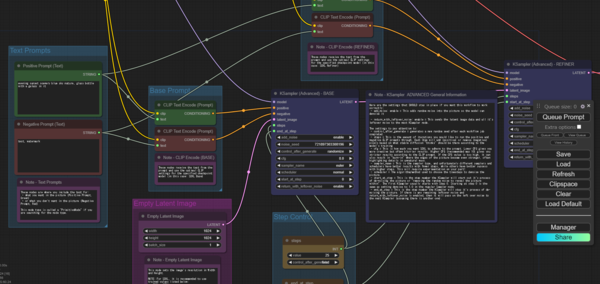

ドドン! 豪華なワークフローが表示された。もちろん画像を直接ComfyUIにドラッグ&ドロップしても同じことができる。

画面に入りきらないのでズームアウトして全体を確認。デフォルトワークフローよりもノードが増えていることがわかる。

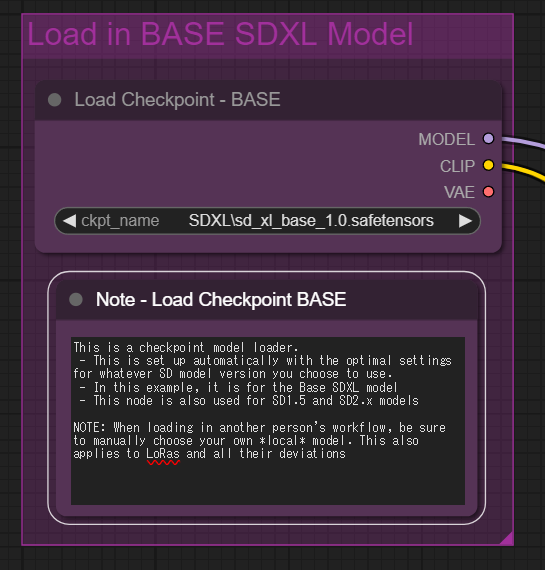

スタート地点となる左上から見てみよう。「Load in BASE SDXL Model」とタイトルにあるので、「ckpt_name」をクリックしてSDXLベースモデル(sd_xl_base_1.0.safetensors)を選ぶ。モデルがない場合はダウンロードしておこう。

サンプルワークフローには、作成のヒントが書かれていることが多いので必ず読んでおこう。英語が苦手な場合はChatGPTに放り込めばよい。

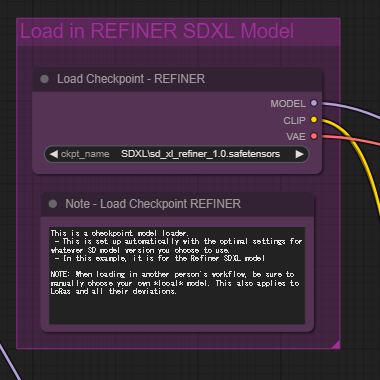

モデル選択の右側には「Load in REFINER SDXL Model」とあるので、「ckpt_name」をクリックしてSDXLのリファイナー(sd_xl_refiner_1.0.safetensors)を選択する。

なお、リファイナーとはSDXLで生成された画像の品質を向上させるために使用される専用の機能(モジュール)だ。

そのまま「Queue Prompt」で生成。

当たり前だが、サンプル画像がそのまんま生成された。

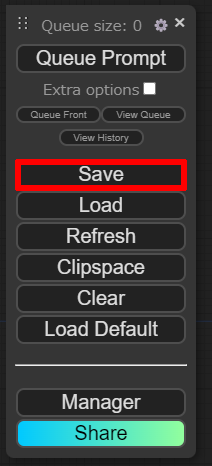

このワークフローをセーブしたい場合は操作パネルで「Save」をクリック。

名前をつけて保存しておこう。

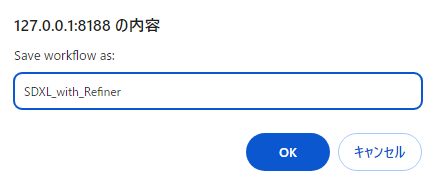

それではプロンプトを変更していこう。どうやらこのブロックがプロンプト入力欄のようなので、Positive Prompt、Negative Prompt欄に最初に使ったセーラー服のプロンプトをそのまま入力し、操作パネルの「Queue Prompt」で生成しよう。

ドン!

リファイナー効果か、細部まで書き込まれたナイスな画像が生成された。

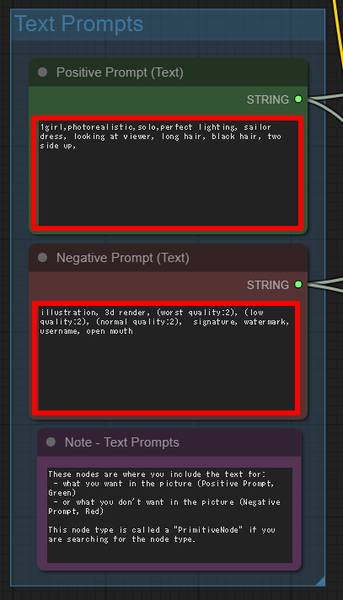

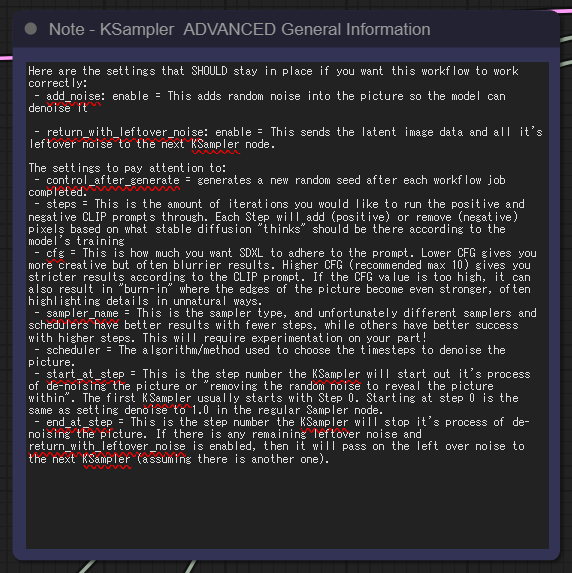

他のノードも簡単に見ていこう。まずはサンプラーやシード値などを指定する「KSampler」ノード。

こちらも詳細な解説が用意されている。本当に勉強になる。

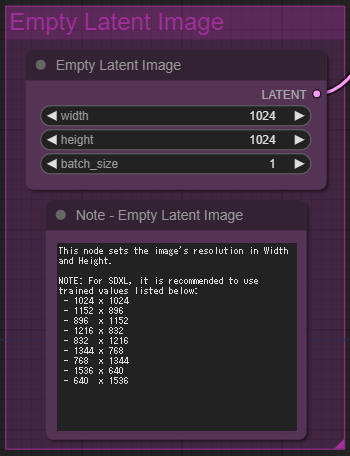

「Empty Latent Image」ノードでは画像サイズと一度のバッチで生成する枚数を指定できる。SDXLの生成画像サイズは1024x1024ピクセルが基本だが、解説には他にも1152 x 896ピクセルや1216 x 832ピクセルなど推奨の解像度が記されている。

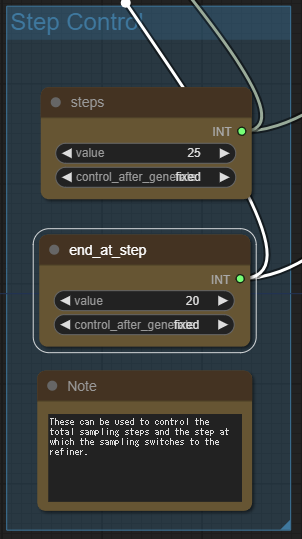

「Step Control」ブロックには「steps」と「end_at_step」の2つのノードが設置されている。この場合はSDXLベースモデルで20ステップ、リファイナーで5ステップ、計25ステップで生成される。

このようにサンプルワークフローをひとつひとつ解読していくのがComfyUI上達の早道だろう。

この連載の記事

-

第40回

AI

Suno級がローカルで? 音楽生成AI「ACE-Step 1.5」を本気で検証 -

第39回

AI

欲しい映像素材が簡単に作れる! グーグル動画生成AI「Veo 3.1」の使い方 -

第38回

AI

最新の画像生成AIは“編集”がすごい! Nano Banana、Adobe、Canva、ローカルAIの違いを比べた -

第37回

AI

画像生成AIで比較!ChatGPT、Gemini、Grokどれを選ぶ?得意分野と使い分け【作例大量・2025年最新版】 -

第36回

AI

【無料で軽くて高品質】画像生成AI「Z-Image Turbo」が話題。SDXLとの違いは? -

第35回

AI

ここがヤバい!「Nano Banana Pro」画像編集AIのステージを引き上げた6つの進化点 -

第34回

AI

無料で始める画像生成AI 人気モデルとツールまとめ【2025年11月最新版】 -

第33回

AI

初心者でも簡単!「Sora 2」で“プロ級動画”を作るコツ -

第32回

AI

【無料】動画生成AI「Wan2.2」の使い方 ComfyUI設定、簡単インストール方法まとめ -

第31回

AI

“残念じゃない美少女イラスト”ができた! お絵描きAIツール4選【アニメ絵にも対応】 -

第30回

AI

画像生成AI「Midjourney」動画生成のやり方は超簡単! - この連載の一覧へ