2024年初頭には、Vertex AI・Duet AIをGeminiで強化

GoogleのマルチモーダルなAIモデル「Gemini」、開発者・企業向けにプレビュー開始

2023年12月15日 07時00分更新

Google Cloudは、2023年12月14日、マルチモーダルに対応したAIモデル「Gemini Pro」のプレビュー版を、同社の開発環境を通じて提供開始した。同日開催した開発者向けイベント「Google Cloud Applied AI Summit」では、その他にも、生成AI関連のアップデートを発表している。

グーグル・クラウド・ジャパンの統括技術本部長(Dat&AI)である寳野雄太氏およびAI/ML 事業開発部長である下田倫大氏が、直近も含めた各アップデートの詳細を説明した。

ネイティブでマルチモーダルに対応した「Gemini」を開発者・企業向けに展開

Googleは、12月6日(米国時間)、最新の大規模言語モデル(LLM)である「Gemini」を発表。Geminiは、ネイティブでマルチモーダルに対応しており、動画や音声、テキスト、コード、画像など異なる種類のデータを1つの仕組みで処理できる。

Geminiは、ユースケースに応じて選択できる「Gemini Nano」「Gemini Pro」「Gemini Ultra」という、異なるサイズに最適化された3つのモデルがある。ここまで、対話型AIサービスである「Bard」の英語版でのみGemini Proが利用でき、Gemini Ultraはプライベートプレビューで展開していた。

今回、中規模サイズで汎用的なGemini Proが、新たに発表した個人向けAI開発ツールである「Google AI Studio」、より高度な企業向け開発プラットフォームである「Vertex AI」で利用できるようになった。従来のPaLMシリーズ同様、もちろん日本語にも対応する。

Google AI Studioは、無料かつウェブベースの個人向け開発ツールであり、API経由で容易にGemini Proを利用できる。また、Google AI StudioからVertex AIに、いつでもアップグレードすることも可能だ。

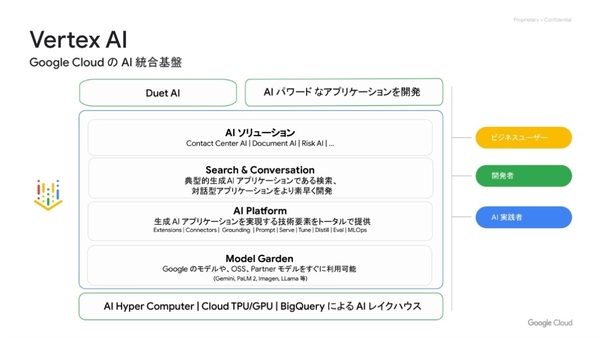

Vertex AIは、より広いユースケースや、データ保護などの企業向け機能に対応した、AI開発の統合プラットフォームである。「Search & Conversation」により生成AIアプリケーションに必要なセマンティック検索や会話機能を実装でき、「AI Platform」にてAIモデルのチューニングやカスタマイズなどが実行できる。そして「Model Garden」にて、Gemini Proを含めたGoogleやOSS、パートナーのAIモデルをワンストップで利用できる。

ちなみにVertex AIでは、2023年6月から9月の期間において、アクティブなプロジェクトが7倍に増加したという。寳野氏は「これはユーザー企業が実際にVertex AIを利用して、AIアプリケーションの実用化に向けてさまざまなプロジェクトを立ち上げていることを意味している」と分析する。

また、Vertex AIを支えるインフラストラクチャーとして、2.8倍のLLMトレーニング性能を備え、4倍のスケーラビリティを持ち、チップあたりの処理性能(FLOPS)が2倍のAIチップ「TPU v5p」を12月6日に、1ドルあたりトレーニング性能を2倍に、推論パフォーマンスを2.7倍に向上させたAIチップ「TPU v5e」を8月に、それぞれ発表している(共に前モデルとの性能比較)。

効率化を進めたTPU v5eの影響もあり、Vertex AIで利用できるAIモデルの値下げが進んでいる。Gemini Proもこの恩恵を受けており、当初のPaLMのと比べて入力文字数あたりで4分の1、出力文字あたり2分の1の価格で今後提供される。

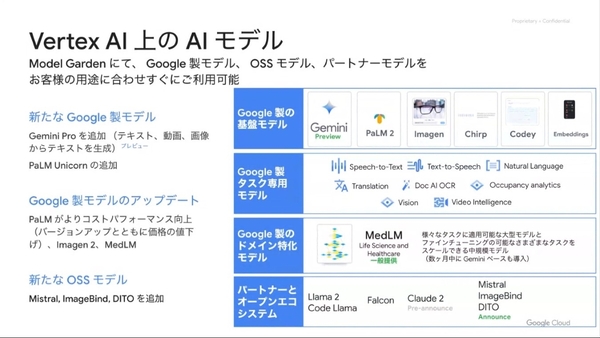

加えて、Vertex AIのModel Gardenから利用可能なAIモデルについて、Gemini Proに加えて、PaLMの最も大きなサイズとなるUnicornモデルを新たに追加。既存のGoogle製のAIモデルに関しても、PaLMのコストパフォーマンスを向上させ、Imagenも機能向上、医療に特化したMedLMを加えた。

また、これらのAIモデルを企業でも安心して利用できるよう、Vertex AIやDuet AIにおける、モデル出力やトレーニングデータの著作権リスクの補償範囲拡大を発表。PaLMやImagenも対象とし、Geminiに関しても一般提供時に対応する。