ディープラーニング(深層学習)専用アクセラレーター「Cerebras CS-1」を提供する米Cerebras Systemsが2020年8月7日、日本法人であるセレブラス・システムズ合同会社を設立し、日本での事業展開を開始すると発表した。日本法人の代表執行役社長には、外資系ITベンダーの日本事業で数々のリーダー職を務めてきた江尾浩昌氏が就任している。

同日に開催された記者発表会では、米本社 CEOのアンドリュー・フェルドマン氏、江尾氏に加え、CS-1の国内販売代理店であり国内第1号の導入顧客でもある東京エレクトロンデバイス 執行役員の上善良直氏も出席し、セレブラスの特徴や米国での導入実績、国内展開の戦略などを説明した。

米Cerebras Systems CEO兼共同創業者のアンドリュー・フェルドマン(Andrew Feldman)氏、ゲスト出席した東京エレクトロン デバイス 執行役員 CN BU 副BU GMの上善良直氏

世界最大のディープラーニング専用チップを搭載したモンスターマシン

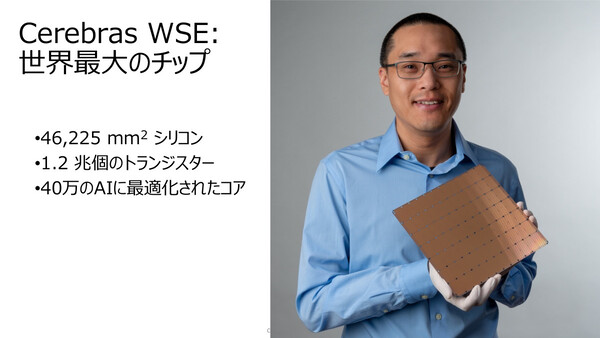

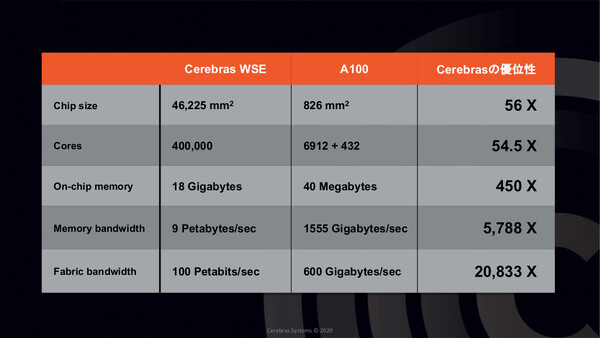

セレブラスは2016年に設立された、ディープラーニングの高速化に特化したコンピュータシステムを開発/製造/提供する企業だ。同社では、ディープラーニング専用に独自開発した世界最大の半導体チップ「WSE(Wafer Scale Engine)」を開発した。一般的なGPU(NVIDIA A100)比で、コア数が54倍、オンチップメモリは450倍、メモリ帯域幅は約5800倍、ファブリック帯域幅は2万倍以上というモンスターチップである。

CerebrasのWSEは、21.5cm角の巨大シリコンに1.2兆個のトランジスタ、40万コアを搭載したディープラーニング処理専用チップ。オンチップメモリは18GB、メモリ帯域幅は9PB/秒、ファブリック帯域幅は100PB/秒とモンスター級

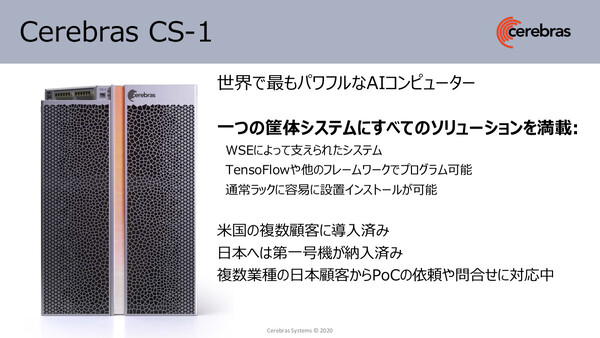

「ただし、高速なチップを開発するだけでは不十分だった。“レースカーのエンジン”は“フォルクスワーゲン”の車体には搭載できない――というわけで、高速なエンジンに見合うマシンとしてCS-1を開発した」(フェルドマン氏)

フェルドマン氏は、10ラック分のTPUクラスタの写真を示しながら「(15Uサイズの)CS-1は、1台でこのシステム以上のコンピュート能力を提供できる」と説明する。シングルノード化により、ラックスペースや消費電力、空調電力を削減できるだけでなく、クラスタ/分散処理の複雑なプログラミングが不要になる利点もある。なお、Cerebrasのソフトウェアプラットフォームは、「TensorFlow」「PyTorch」といった一般的な機械学習フレームワークと統合されており、特別なノウハウは不要だ。

現在、ディープラーニングの能力はあらゆる業界で必要とされており、その「スピード」がビジネスの勝敗を左右する。そのため、CS-1も「ハイパースケーラー(クラウド事業者)、自動車、重工業、通信キャリアやISPなど、さまざまな業界に顧客がいる」とフェルドマン氏は説明した。

米国ではすでにアルゴンヌ国立研究所、大手バイオテック企業、ピッツバーグ・スーパーコンピューティング・センターでの導入事例が公開されている。日本国内でも、ソーシャルメディア/エンタテインメント業界の大手顧客が、CS-1を利用して自然言語処理や検査エンジンの精度向上を図っている事例があるという。

日本法人では「3年後に100億規模のビジネスを目指す」

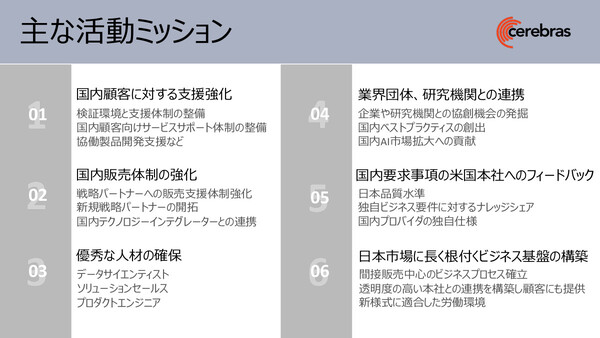

セレブラス日本法人は米国本社の100%子会社として設立され、国内では100%パートナー経由での間接販売を行う。江尾氏は日本法人の主な活動ミッションとして、国内顧客への支援強化をはじめ、戦略パートナー開拓を含む販売体制強化、優秀人材の確保、さらに国内顧客からの要求事項の米本社へのフィードバックなどを挙げた。

「日本市場に長く根付くビジネス基盤の構築も重要だと考えている。日本市場では長いセールスサイクルが必要であり、その点はアンドリュー(フェルドマン氏)にも理解してもらっている」(江尾氏)

また2020~2022年度の中期戦略展望として、2020年度(今年度)はスタートアップフェーズ、2021年度(2021年1~12月期)は先進顧客への認知度向上と連携フェーズ、2022年度は拡販強化フェーズと説明した。この拡販フェーズで一気にビジネスを拡大し、「3年後に100億円規模のビジネスを目指している」と語った。

またゲスト登壇した東京エレクトロンデバイスの上善氏は、「セレブラスと歩調を合わせて国内顧客を発掘」しており、複数の国内顧客において現在PoCを実施中だと紹介した。前述したソーシャルメディア顧客における自然言語処理、製造業顧客の画像認識による検品自動化といった事例だという。

「先日、CS-1を導入した米国ローレンス・リバモア国立研究所の研究者インタビューを聞いていると、最新の自然言語処理系アプリケーションではパラメーターが15億個にもなるという。これをオンチップのメモリに格納でき、リアルタイムに推論エンジンを回せるシステムはCS-1しかなかったそうだ。さらに(OpenAIが開発した)GPT-3は100倍のパラメーター数があるので、そうなるとセレブラスの第2世代、第3世代の製品も必ず必要になってくる」(上善氏)

なお東京エレクトロンデバイスでは、今年秋に東京・新宿の同社サポートセンター内にデモ/検証センター「TED AI Lab」を開設し、Cerebras CS-1の製品でもおよび有償PoCサービスを開始する予定だ。