AI insideがAI活用のさらなる“二極化”を予測

AIエージェントが実運用に到達しない“2つの理由” 2026年は「業務完遂AI」の年になるか

2026年01月20日 08時00分更新

2025年、AI技術は進展したものの、企業の実運用は依然として本格化しなかった。AI insideの渡久地択氏は、その背景にあった「時間」と「責任」の問題が解消されることで、2026年は「業務完遂AI」の年になると予測する。

AI-OCR「DX Suite」などを手掛けるAI insideは、1月15日、2026年のAIトレンド予測に関する説明会を開催。同社の代表取締役社長 CEOである渡久地氏は、AIのトレンドは「何ができるか」から「運用できるか」にシフトしていくと強調した。

AIエージェントが実運用に到達しない“2つの理由”

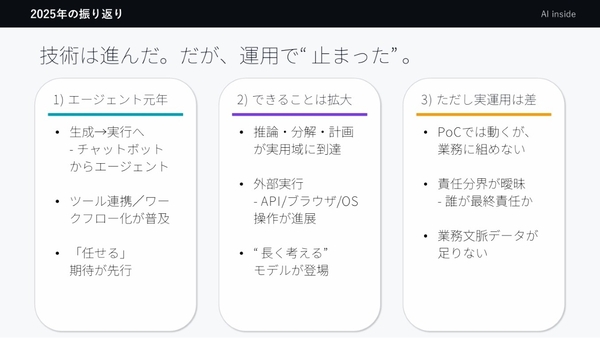

まず渡久地氏は、「AIエージェント元年」と呼ばれた2025年を振り返った。チャットボットからエージェントに進化し、ツール連携やワークフロー化が普及して、AIに業務を「任せられる」という期待が先行した。ただ、実運用は本格化せず、「AIエージェントの入口に立った年だった」と振り返る。

実際にAIモデルのできることは、急速に拡大している。APIやブラウザ、OSの操作が進展して、OpenAIのo1を代表するような「長く考える」モデルも登場した。しかし、この進化したAIモデルを業務に落とし込むとなると途端にハードルが上り、多くのAIプロジェクトがPoCどまりとなり、実運用にまで到達しなかった。

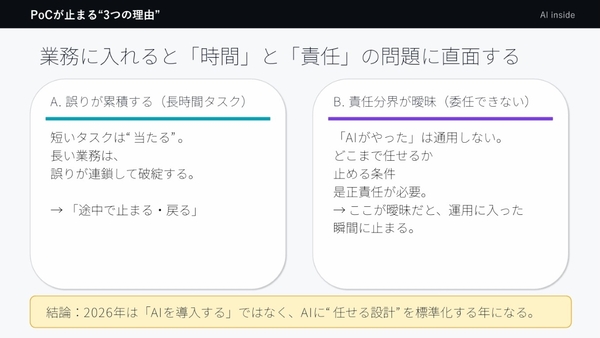

なぜ、AIを業務に組み込めないのか。渡久地氏は、その背景に「時間」と「責任」という2つの問題を挙げる。

最初のハードルとなるのが「長いタスク」の問題である。単発タスクでは一定の成果が得られるが、長いワークフローになると“誤りが累積して”破綻してしまう。

次に直面するのが「責任分界の曖昧さ」という問題だ。タスクが長くなるほど責任主体を特定しづらくなり、説明責任が果たせなくなる。

AIの競争軸はモデル性能から“安心して任せられる運用”に

渡久地氏は、2026年はこれらの「時間」「責任」の問題が解決され、「業務完遂AI」への入口の年になるという。

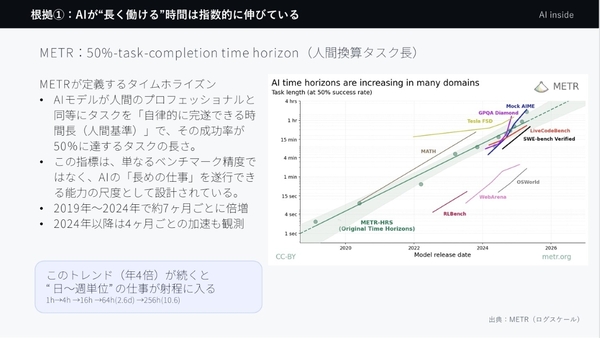

その根拠のひとつが、AIの「働ける時間」が指数関数的に伸びていることだ。AIモデルが50%の確率で、人のプロフェッショナルと同等に完遂できるタスクの長さを表す「METR(人間換算タスク)」をみると、2019年から2024年で約7か月ごとに倍増し、2024年以降は4か月ごとで倍増している状況だ。例えば、数学の領域などでは、人が1時間以上かかるタスク(試験)を完了できるモデルが登場している。「このトレンドが続くと、後1、2年で“日~週単位”のタスクをAIがこなせるようになる」(渡久地氏)

また、AnthropicのClaudeでは、Opus 3.5で7時間連続のコーディングが、Opus 4で24時間連続のゲームプレイ(ポケモン)が可能になり、さらにSonnet 4.5では、30時間以上の自律的なコーディングを実現するなど、自律的に働く単位がタスクからプロセスへと拡大しつつある。

なぜ、AIが長く働けるようになったかというと、「思考を段階化して、計画・実行・検証という繰り返しができるようになった」(渡久地氏)からだ。長時間タスクは、このサイクルがないと成立しない。

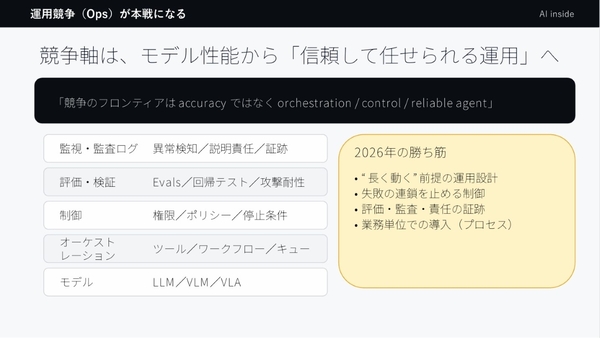

さらに、このサイクルが基本的な動作になると、AIの性能が問われなくなる。渡久地氏は、これからのAIの競争軸は、モデル性能から「安心して任せられる運用」にシフトしていくと予測する。つまりAIの正確さ(accuracy)ではなく、管理・最適化(orchestration)や制御(control)、信頼性(reliable agent)といった運用領域(Ops)が主戦場になっていく。

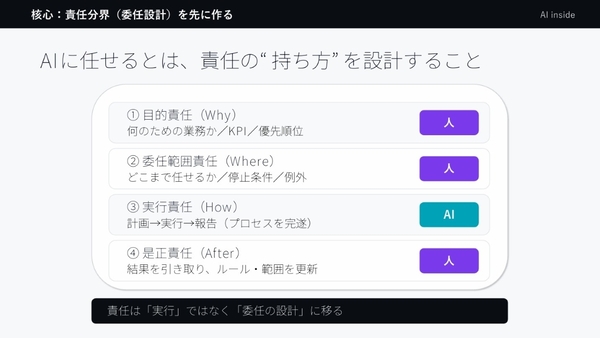

そして、長時間の作業をAIに任せるようになると、前述の「責任」問題が避けて通れなくなる。これに対して、AI insideが今後推進していくのが、責任の“持ち方”を設計することだ。具体的には人が予め、AI活用で何を目指して、KPIや優先順位は何かという「目的」、AIにどこまで任せて、停止条件や例外は何かという「委任範囲」、そして、誤りが発生した際にどうするかという「是正」を定めていくという。

こうすることで、誤りが発生した責任主体を特定しやすくなり、AIが目的や委任範囲内で動けるようになる。「2026年はこうした責任の設計が進む年になる」と渡久地氏。