「watsonx.governance」提供開始、リスク管理や透明性確保、コンプライアンスを可能に

IBM、「watsonx」にAIガバナンス確保のモジュールを追加

2023年12月08日 07時00分更新

日本IBMは、2023年12月1日から「watsonx.governance」の提供を開始した。それに合わせて、12月4日にwatsonxの最新状況などを説明する記者説明会を開催した。

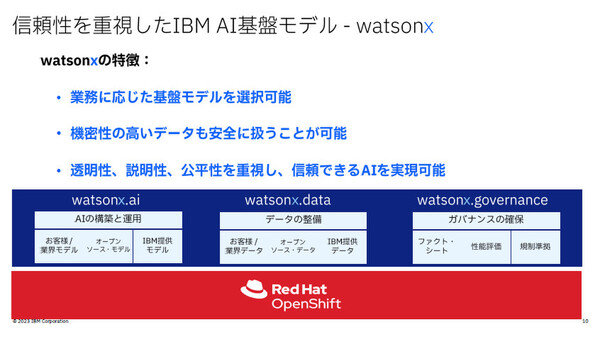

IBMでは、ビジネスに特化した生成AIおよびデータプラットフォームである「watsonx(ワトソンエックス)」を2023年5月に発表。それを構成する3つのコンポーネントのうち、IBM独自の基盤モデルを活用した生成AI機能を提供する「watsonx.ai」と、データとAIを管理するデータストア「watsonx.data」の提供を2023年7月から開始していた。

今回、説明可能なAIワークフローを構築し、AIガバナンスを確保する「watsonx.governance」を提供開始することで、watsonxのコンポーネントが出揃うことになる。

なおIBMでは、2023年9月からwatsonx.aiで使える独自の大規模言語モデル(LLM)「Granite(グラナイト)」も提供開始しており、その説明も行われた。

日本IBM 理事 テクノロジー事業本部 Data and AI テクニカルセールス watsonx Client Engineeringの竹田千恵氏、日本IBM 執行役員 兼 技術理事 AIセンター長の山田 敦氏

AI利用時のリスク管理、透明性確保、コンプライアンスのためのツールキット

日本IBM 理事 テクノロジー事業本部 Data and AI テクニカルセールス watsonx Client Engineeringの竹田千恵氏は、まずwatsonxの特徴として「業務に応じた基盤モデルを選択可能であること、機密性の高いデータも安全に扱えること、透明性や説明性、公平性を重視し、信頼できるAIを実現していること」を挙げた。

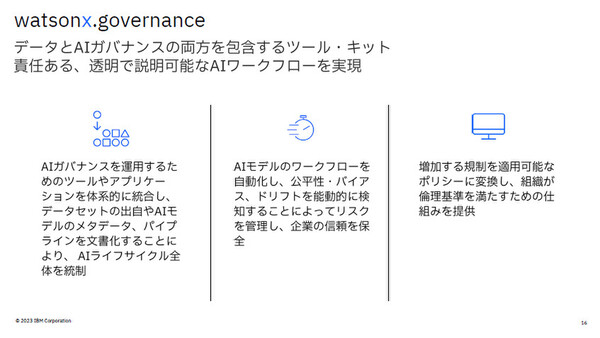

そのうえで、今回追加されたwatsonx.governanceは「AIを利用する企業のリスクを管理し、透明性を確保し、将来見込まれる規制を遵守するために必要なツールキットを提供するもの」だと説明した。

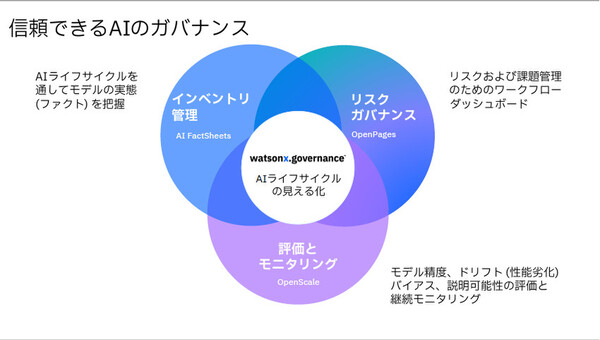

「『モデルインベントリ管理』『モデルリスクガバナンス』『評価とモニタリング』の3点から、責任ある透明で説明可能なAIワークフローを実現し、AIライフサイクルの見える化につなげることができる。信頼できるAIによって、自社の競争力をAIで増幅するAI価値創造企業(AI Value Creator)を支援するツールになる」(竹田氏)

「モデルインベントリ管理」では、複数の基盤モデルを管理し、常に最新の状態に更新する。AIファクトシートを通じて、そのAIモデルがいつ作られ、学習に使用されたデータがどこにあるのかを確認できるほか、検証データの精度、デプロイの情報、公平性の成果などについても管理できる。機械学習では「Watson Machine Leaning」のほか、「Amazon SageMaker」「Azure Machine Leaning」のAIモデルも監視対象にでき、複数のモデルインベントリを一覧表示で管理し、使用しなくなったAIモデルの破棄まで追跡、管理することが可能だ。

また生成AIについては、ユースケースごとにAIモデルを整理して管理できる。リスクが高いAIモデルについては、ステークホルダーに対して注意喚起も行うという。さらに、生成AIのライフサイクルに応じた状態も把握できる。

「モデルリスクガバナンス」では、GRCソリューション「IBM OpenPages」の機能を拡張。ワークフロー、ダッシュボード、インシデント管理により、AIモデルの社内規制のギャップによるリスクを管理したり、開発したAIモデルの社内承認を確認したり、AIモデルの検証、再トレーニング状況、パフォーマンスの問題なども監視できる。

「評価とモニタリング」では、「IBM Watson OpenScale」により、AIの予測を追跡し、出力した結果に対する説明可能性を確保するほか、バイアスの検知と緩和、品質しきい値やビジネス重要指標に違反した場合の通知などを提供。生成AIについては、ユースケースに対するLLM評価メトリクスによって、手元にあるデータがテキスト要約したものなのか、分類された結果なのか、コンテンツ生成によるものなのかといったことを抽出して、スコアリングすることで、品質と安全性を確保。データのサイズやレコード数、レイテンシーやスループットも監視できるという。

ビジネスユーザーが信頼できるLLMを目指す独自LLM「Granite」

独自の大規模言語モデルであるGraniteについても説明した。

Graniteは、watsonx.ai上で動作するIBM独自のLLMで、デコーダーアーキテクチャーをもとに開発。130億パラメーターと軽量ながら、要約や質問応答、コンテンツ生成、分類などのビジネス領域タスクで優れた性能を発揮するという。

Graniteでは、ビジネスユーザーのニーズをターゲットにしたモデル学習を行っている。具体的には、インターネットから取得した一般的な言語データのほか、科学技術、プログラミング、法務、財務といった言語データも学習しているという。

信頼性確保のために、信頼性と透明性を原則とした学習プロセスを確立していることも強調した。学習データ収集に関するガバナンス手順を開発し、ガバナンスやコンプライアンスに関するレビュープロセスを経てから収集することを厳密に実施。憎悪的、冒涜的なコンテンツを事前に検出する「HAPディテクター」技術を採用し、こうしたデータが入り込まないようにして学習を行う。さらに、重複したデータや質の低い文書を排除することで、出力の質を高めているという。

竹田氏は、こうしたプロセスは固定的なものとは考えておらず、生成AIの技術変化に合わせて継続的に進化、改善させることで「ビジネスユーザーが信頼できるLLM」としての評価を維持したいと述べた。

なお、透明性と責任のあるAIとして、Graniteでは学習アルゴリズムや評価、ベンチマーク結果といった技術仕様の詳細を公開している。竹田氏は「G7広島AIプロセスや各国のAI規制法案において、AIモデルの学習データの技術仕様開示を求める動きがあるなかで、IBMはAI提供ベンダーとしての責任を先んじて果たしている」と自信を見せた。

IBM自身の「AI倫理」の取り組みも紹介

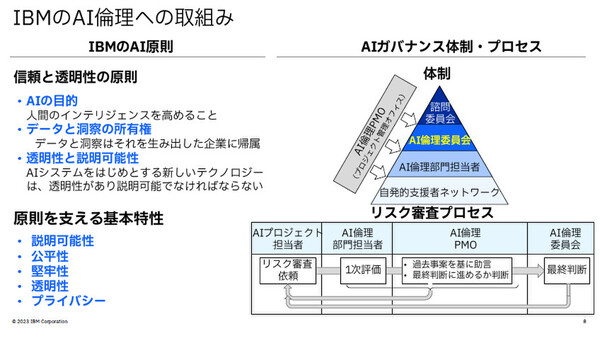

日本IBM 執行役員兼技術理事 AIセンター長の山田 敦氏は、IBMの「AI倫理」の取り組みについて紹介した。

現在、生成AIの開発と利用が進む一方で、さまざまな“AIリスク”が高まっている。AIモデルの学習においては、著作権やプライバシーの侵害、AIモデルを狙うサイバー攻撃のリスクが、またAIモデルの利用においては、不正確な情報、著作権のない成果物、説明のできない出力といったリスクがある。山田氏は、こうしたリスクをふまえて「企業はAIガバナンスをしっかりと実践しなくてはならない」と述べた。

IBMでは2018年に「AI原則」とそれを支える「5つの基本特性」を示した。同時に、AIガバナンスの体制およびプロセスを定め、AI倫理委員会を中心とした4段階の体制で、AIに関するリスク審査プロセスを動かしている。「こうした取り組みによって、企業などのAI利用者は、watsonxを利用するだけでさまざまなリスクに対応することができる」(山田氏)。