再学習のシミュレーションや大規模モデルの追加学習にも

基盤モデルの再学習を“ゼロ”に NTTが学習効果を引き継ぐ「ポータブルチューニング」技術

2025年07月09日 15時50分更新

生成AIの業務活用に使われる特化型AIは、知識を最新の状態に保つために、元となる基盤モデルの定期的な更新が必要となる。その際に、ドメイン知識の再学習が求められ、運用コストの上昇を招いている。

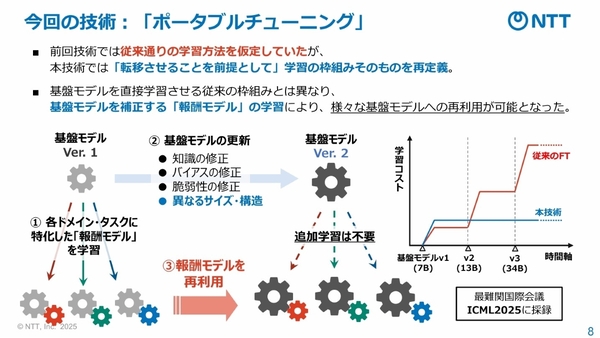

この問題を解決すべく、NTTは2025年7月9日、生成AIのカスタマイズコストを低減する新たな学習の仕組みとして、「ポータブルチューニング」技術を確立したと発表した。同社が2024年に提唱した「学習転移」を進化させた技術となり、基盤モデルの出力を補正する「報酬モデル」を利用することで、別の基盤モデルに“学習効果を引き継ぐ”ことができる。

NTT コンピュータ&データサイエンス研究所の竹内亨氏は、この新技術は「基盤モデルにおける学習の捉え方を変える可能性を秘めている」と強調する。

再学習コストを削減するために学習方法を再定義

業務で基盤モデルを活用する際には、特化学習(ファインチューニング)により、特定タスクやドメイン知識を習得させる必要がある。一方、その基となる基盤モデルも、知識やバイアス、脆弱性を修正するための定期更新が求められる。

ただ、基盤モデルを更新すると、せっかく学習させたタスクやドメイン知識を再学習させなければならない。NTT コンピュータ&データサイエンス研究所の千々和大輝氏は、「いわば“OSのアップデートにアプリケーションをどう追随させるか”といった問題が生じる」と説明する。

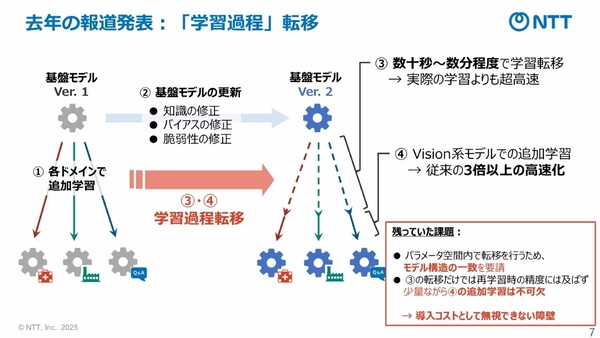

既存のアプローチとして、特定学習を効率化する「転移学習」、モデルの性能を改善する「継続学習」、複数モデルを統合する「モデルマージ」などの技術もあるが、どれも再学習のコスト削減にはつながらない。そこで、NTTが2024年5月に提唱したのが「学習転移」の技術である。

学習転移は、異なる基盤モデル間で「学習過程」を転移させることで、再学習のコストを低減するアプローチだ。パラメータ空間内で学習過程を変換し、新しい基盤モデルに転移することで、元モデルの学習を模倣。その上で、少量の追加学習を行うことで、特化学習をやり直すよりもコストを大幅に削減できる。

しかし、この学習過程の転移には、課題が2つ残されていた。ひとつは、パラメータの変換をするために「モデル構造の一致」が求められること。もうひとつは、精度向上のために、少量ながらも「追加学習が不可欠」であることだ。

そこで今回、NTTが開発したのが「ポータブルチューニング」という新技術だ。前述の学習転移では、従来通りの学習方法を転移させていたが、ここでは学習方法自体を再定義。基盤モデルを直接学習させるのではなく、学習対象のタスク・ドメインに対する出力を補正する「報酬モデル」を学習させる仕組みによって、サイズや構造が異なる基盤モデルへの学習の再利用を可能にした。「最初の学習ではオーバーヘッドコストが発生するが、基盤モデルの更新で追加学習が必要なくなる」と千々和氏。