AIのプロに学ぶ、RTX PRO AIマシンの使いこなし術 第2回

NVIDIA高橋 想氏、津田恵理子氏にインタビュー

いま、NVIDIA RTX AIワークステーションを導入する企業が増えている理由

2025年03月19日 11時00分更新

──実際にこうしたGPUを積んだワークステーションというのは、どのような形で世の中に出てきていて、どんな分野で使われているんでしょうか。メーカーの提供形態や主な導入業種についても、詳しく教えていただけますか。

高橋「海外や国内の主要なワークステーションメーカーなどから提供されているわけですが、購入方法としては、メーカーから直接ではなく、専門知識を持ったリセラー(販売代理店)経由で導入するケースが多いですね。現時点(※記事制作時点)では、サーバー向けのワークステーションと比較して入手しやすく、注文してから納品までも比較的スピーディーです」

──具体的にはどのくらいの価格帯なんでしょう?

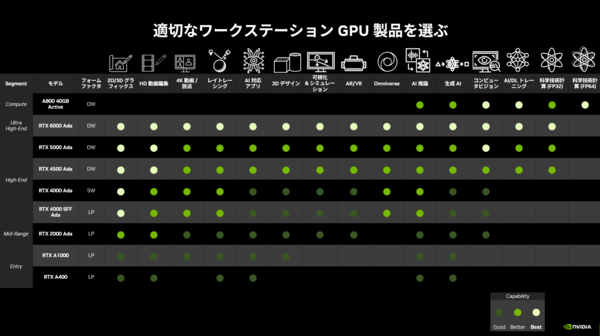

高橋「一番安価なもので20万円を切るくらいからスタートして、最上位モデルだと複数のRTX 6000などを載せて500万円を超えることもあります。用途がはっきりしていれば、低価格帯でも十分なケースがありますし、最高スペックを求めると高額になります。

最上位のRTX 6000を選ぶ企業もありますが、価格が手頃なRTX 2000やRTX 4000シリーズも売れ筋です。企業は予算と必要な性能を考えて導入を決めるため、必ずしも最高性能のモデルばかりが選ばれるわけではありません。また、リース期間が終わる際も『これまでRTX 2000を使っていたから、次も同じクラスにしよう』という形で、同じグレードの製品を継続して使うケースも少なくありません」

──なるほど。企業によっては数百台単位で導入する場合もありますから、全体のコストを考慮して下位モデルを選ぶこともありますね。現在の主流な用途としては、どのような活用事例が挙げられますか?

高橋「製造業や機械系、自動車メーカーなどでは、構造設計やビジュアライズなどで使われています。放送局や映像制作系でも4Kや8K映像の編集、リアルタイムレンダリング。金融系でディーリングルームにマルチディスプレイなど、処理能力だけでなく信頼性の求められる分野ですね。ここに、AI推論の活用を目的とした導入がされてきているわけです。活用分野については、また後ほど整理しましょう」

NVIDIA RTX AIワークステーション

導入のメリット!

1.GPU4枚差しも可能! AI推論開発をローカルで実現する圧倒的なハイパフォーマンス

2.クラウド環境依存からの脱却! 秘匿性の高いデータも社内で扱える

3.開発サイクルの高速化! 担当者が手元で高速に開発を繰り返せる

4.欲しい時にいつでも導入可能! 納期のかかるGPUサーバーと違い短納期、追加購入も簡単

開発環境の面倒ごとを一掃し得る「NVIDIA NIM」の魅力

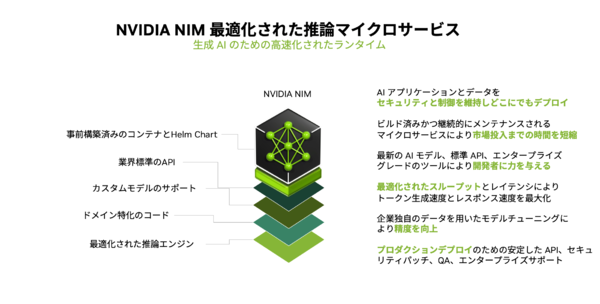

NVIDIA RTXのメリットが理解できたところで、開発環境の話にも触れていきたい。NVIDIAでは、生成AIモデルのデプロイと運用を簡素化するための推論マイクロサービス「NVIDIA NIM」を提供している。

開発者が複雑なAIソフトウェアスタック構築の専門知識を“持たなくても”、AIモデルを素早く導入できるようになるというNVIDIA NIMの、基本的なコンセプトや導入のメリットについて掘り下げていく。

──AIを事業に導入したいものの、実際には簡単ではないと見ている企業も多い印象を持っています。

津田「AIをビジネスに活かす流れは強まっているものの、『AIをビジネスに活かす』とひと口に言っても、開発環境の構築やライブラリの依存関係など、デプロイや運用管理での手間がすごく多いんです。Pythonのバージョンや各種ライブラリが競合して、環境構築だけでまず時間と手間がかかってしまいがちです」

──それ、ありがちな話ですね。

津田「そこでNVIDIAが提供しているのが『NVIDIA NIM』というマイクロサービスです。複雑な環境構築がコンテナ化されていて、コマンドひとつで動くんですよ。以前は使いはじめるまでに1週間かかることもありましたが、それが本当に5分でできるようになります。通常は、それぞれのソフトウェアや環境の互換性、依存関係を検証しなければならないところ、NIMを使うと、各アセットが検証のとられた状態でコンテナ化されている、といったイメージですね」

──NVIDIA AI Enterpriseユーザーであれば、誰でも自由に使えるのでしょうか?

津田「POC(概念実証)の範囲なら無償で試すこともできますし、企業ユースで本格的に使う場合はNVIDIA AI Enterpriseのライセンスでサポートを受けられるようになっています。AIモデルを企業で本番運用するうえでは、『いつ提供が終了するか分からないオープンソースをそのまま使うのは怖い』という声もありますが、NVIDIA AI Enterpriseなら、セキュリティパッチやバージョン固定でのサポートが付いてきますので、長く使い続けるような環境でも安心です」

──長期運用は企業ユースでは重要ですよね。

津田「そうです。本来エンジニアが時間を割くべきなのは、『どのようにAIを活用して価値を生むか』というアイデアや実装の部分ですよね。でも実際には『ライブラリが競合する』『バージョンが合わない』といった環境面のエラーで頭を抱え、その解決に時間を費やしてしまう。そこを解消しよう、という発想です」

──いいですね。

津田「AIエンジニアは企業にとって大変貴重な人材であり“高級取り”でもあります。そうした人材が環境構築に多くの時間を費やすのはナンセンスです。NVIDIAのソフトウェアを活用することで、そういった作業の負担を大幅に軽減しようというものです。

NIMは、『推論環境やモデル管理を簡単にするコンテナ群』で、主要なオープンソースLLM(LlamaやMistralなど)にも順次対応を進めています。ファインチューニング済みのモデルを載せて推論することも可能です」

──「AIがビジネスにとって当たり前の時代」に、ほしい仕組みだと思いました。既存のSIer(システムインテグレーター)やソフトウェアベンダーも、この流れにどう乗っていくかがポイントになりそうです。

津田「いままでAIとはあまり縁のなかった大手SIerでも、いまはAIプラットフォームやエージェントサービスを作ろうとしています。もちろん、スタートアップ企業が先鋭的なソリューションを提供していくのもあります。いずれの場合にも、GPUとソフトウェアのサポートが不可欠という点は共通していますね」

──日本企業にとっても、今が大きな転換期かもしれません。

津田「製造業でも、金融でも、放送・映像でも、AIを使わない手はない時代になりつつありますからね。ここをしっかり支援していくのがNVIDIAの役割だと思っています」

この連載の記事

-

第5回

sponsored

NVIDIA RTX PRO AIワークステーション、Blackwell世代で迎える新たな進化の現在地 -

第4回

sponsored

「買ってすぐ業務に使える」ローカル完結型のRAGが生まれた背景 -

第3回

sponsored

AIワークステーション “Lenovo ThinkStation”は「効率的で、しかも安い」価値創造の源泉 -

第1回

sponsored

生成AIの次なるステージ:ローカル環境がビジネスの新しい扉を開く理由 - この連載の一覧へ