アップルのAI、「Apple Intelligence」がiPhoneやMacを変える! 「WWDC24」特集 第19回

アップルWWDCで明かされたのは「パーソナルインテリジェンス」への挑戦だった(西田宗千佳)

2024年06月13日 07時00分更新

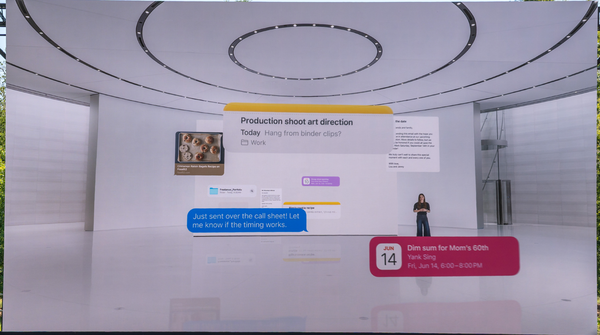

アプリをまたいで「履歴」「文脈」「コンテンツ理解」

では、Apple Intelligenceの目指すものはどのように実現され、どこが大きな要素となるのだろうか?それは「アプリをまたいだ履歴と文脈の理解」であり、「アプリ内のデータに関する深い理解」である。

Apple Intelligence導入後の新しいSiriでは、次のようなことができる。

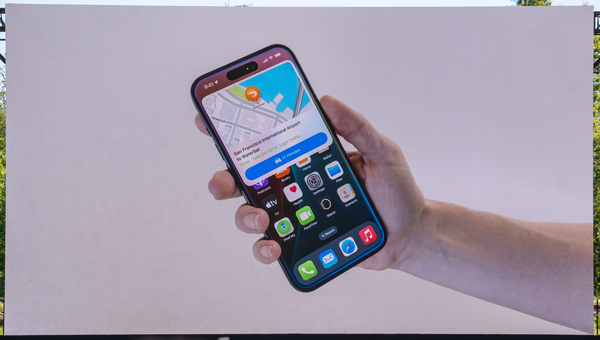

「前話してた試合、どの球場でやってるんだっけ?」

「そこまでって、どのくらいかかる?」

「場所を覚えておいて」

人間との会話だったらあたりまえの内容だ。だが機械への指示だとすると、

・どのスポーツの話をしていたのか

・話している球場とはどこを指すのか

・場所を覚えるとは、どのアプリへの記録を指すのか

といった情報が本来は必要だし、それぞれどのアプリで実行するべきかも、指定しなければならない。

だがApple Intelligenceの場合、端末内でのコミュニケーション履歴やアプリの機能から適切な情報を選び、会話が成立している間は「読まねばならない文脈」を抑えて働く。

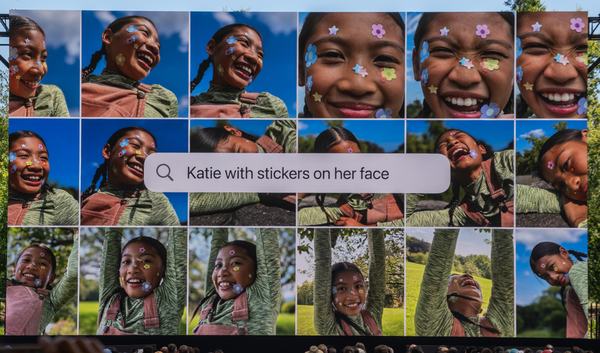

また、「写真」アプリもおもしろい。アプリ内に蓄積された写真・動画について、なにが写っているのかを全て検索用のインデックスとして生成し、検索対象とするのだ。

だから例えば、「東京に行った時食べたもの」「釣りをしている子ども」のようなふんわりフレーズで検索可能にする。

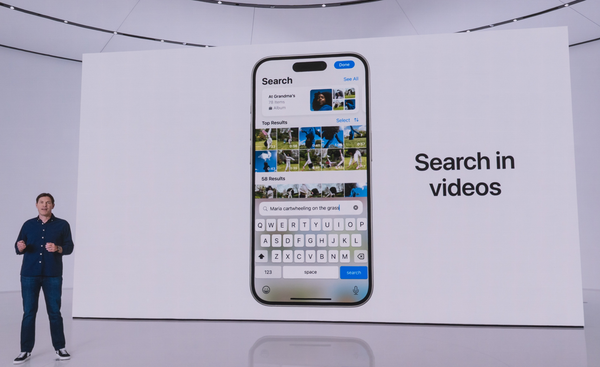

また動画の場合、サムネイルだけでなく「動画内に含まれるもの」まで検索対象として解析されるため、大量の動画から決定的シーンが含まれるものを見つけられるわけだ。

さらには、写真・動画をまとめる「メモリー」機能の場合、「登山旅行の写真を。〆は2人のセルフィーで」と指定することで、ちゃんとセルフィーで終わるショート動画にまとめ直してくれたりもする。

こうした要素がどのくらいデバイスの使い勝手を変えていくのかは、正直なところ未知数だ。非常におもしろい要素ではあるが、そんなにうまくは働かない可能性もある。

だが少なくとも、「アラームを7時……んー、6時にセットして」という感じで言い淀んだ場合でも、ちゃんと人間と同じように「6時にセット」してくれるようだ。「6時と7時の2つセットされる」のでも、「7時にセットされる」のでもない。

この時点で、今までとは違う世界に入りつつあると感じないだろうか。

この連載の記事

-

第22回

Apple

Apple WatchもAI! watchOS 11の新機能から「次」が見えた -

第21回

Apple

Apple Vision Pro、6月28日に日本上陸! Apple Storeで体験するなら無料だ! -

第20回

Apple

アップルは「AIスマホ」でどこまで競えるのか? 今後グーグルとの勝敗は(石川 温) -

第18回

Apple

アップルID、「アップルアカウント」に変更。サインイン体験あらわす表現に -

第17回

Apple

みんな「Hey Siri!」は恥ずかしかったw AirPodsの新機能は「首を振るだけ」 -

第16回

AI

アップルのAIがすごいところを技術的に見る。速度と正確性の両立がポイント -

第15回

Apple

【現地レポ】アップル次期OS、注目したい3つの機能! キーワードは「整う」 -

第14回

iPhone

アップル「iOS 18」見られたくないアプリだけロックできる新機能 -

第12回

iPhone

アップル「iOS 18」支払い機能が便利! 分割払いの指定や、iPhoneで割り勘も -

第11回

iPhone

iPhone版「消しゴムマジック」精度高そう! iOS 18新機能「クリーンアップ」 - この連載の一覧へ