実績と未来を見せた「AWS Summit 2016」 第2回

AWS Summit 2016 Developer Conferenceの注目セッション

国内販売は?音声認識&人工知能のAlexaで生まれる未来

2016年06月03日 07時00分更新

6月2日、AWS Summitの2日目のDeveloper Conference会場では、音声認識プラットフォームである「Amazon Echo&Alexa」のセッションが行なわれた。日本で未発売のAmazon Echoだが、開発者の関心は高く、音声と連携したサービスの新時代を予感させた。

Amazonは音声こそが将来と信じている

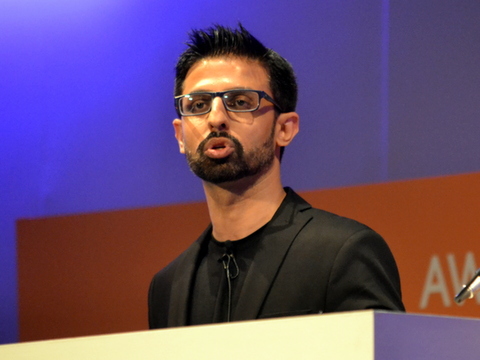

今回、Amazon Echo&Alexaのセッションを担当するAVS(Alexa Voice Services)のシニアエバンジェリストであるアミット・ジョトワニ氏は、会場に対して「Hello Alexa!」を呼びかける。カウントダウンと共に会場がAlexaを呼び出すと、Alexaは英語で「こんにちは。会場のみなさんは楽しそうですね」と挨拶する。

AmazonのAVS(Alexa Voice Services) シニアエバンジェリスト アミット・ジョトワニ氏

ジョトワニ氏は、まず「タッチインターフェイスの時代は過去の時代のものになる」という記事を引用し、音声インターフェイスの重要性について語る。「10年前に、私はこれからはキーボードとマウスが主流のインターフェイスではないと言ったら、みんな笑うでしょう。でも、10年経ち、現在はタッチインターフェイスとモバイルデバイスが、われわれの生活を革命的に変化させた」と語る。今後、スマートハウスやIoTの時代になり、タッチと異なるエキスペリエンスを実現する音声のような新しいインターフェイスが台頭してきても不思議はない。「Amazonは音声こそが将来と信じている。自然なインターフェイスだからだ」(ジョトワニ氏)。

タッチインターフェイスは音声インターフェイスにリプレイスされるのか?

人工知能を備えた音声認識プラットフォームであるAmazon Alexaは、業界で大きなブームとなっているコグニティブ(認識)コンピューティングの先兵的な存在と言える。クラウドとの連携により、単に音声認識するだけではなく、日々学習を続けることでより賢くなるのが特徴だ。

現在はAmazon Echoというハンズフリースピーカーに搭載されており、音楽を流したり、天気を調べたりといった、さまざまな操作を音声コマンドから行なえる。「聞いているときはLEDが点滅する。聞いてほしくない時は、ミュートボタンを押せばよい」(ジョトワニ氏)。こうしたAlexa対応デバイスも「Echo」のほか、Echoのミニバージョンである「Echo Dot」、プッシュトゥートークで動作する「Tap」など続々と増えており、先週はFireTVにも対応した。

国内発売が待たれるAlexaファミリー

Alexaの機能をデバイスに取り込むエコシステムとは?

続いて、ジョトワニ氏はAlexaのテクノロジーについて説明する。Alexaはクラウドサービスとして実装されており、Alexaは2つの開発者向けのエコシステムを持っているという。Alexaの機能をサードパーティが取り込むための「AVS(Alexa Voice Service)」と、Alexaの機能を独自に強化できる「Alexa Skills Kit」だ。

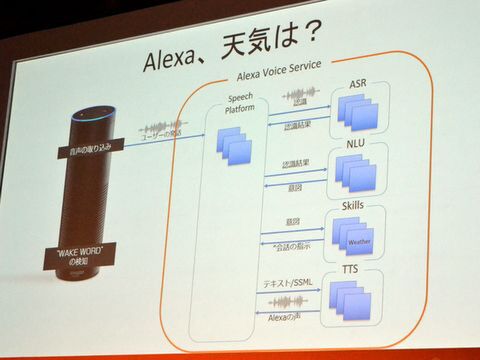

AVSの中には音声認識を実現する「ASR」や自然言語を認識する「NLU」、テキストツースピーチの「TTS」、そしてさまざまな機能を提供する「Skills」などのコンポーネントで構成されている。

ジョトワニ氏は、Alexaでの処理の流れも明らかにした。「Alexa!」というウェイクワードを発すると、Alexaは音声の取り込みを開始し、各コンポーネントのオーケストレーターである「Speech Platform」に送信する。次にSpeech Platformは、ASRに音声データを渡し、会話を取り出し、言葉を抜き出す。次に渡されるNLUでは自然言語認識を担当し、ユーザーがどのような処理を期待しているのか、会話の意図を汲み取る。その後、意図にあわせて必要な「Skill」が呼び出されて、適切な処理が行なわれるとともに、テキストツースピーチの処理を経た後、Alexaの声としてユーザーに戻るという流れだ。

Alexa Voice Serviceでの音声処理の流れ

こうしたAVSを活用したサードパーティデバイスとしては、壁掛け可能な「Triby」のほか、スマートウォッチの「CoWatch」、ラズパイ版のプロジェクトもある。また、オーディオメッセージを送れる「Roger」、開発用の「Lexi」などのアプリも提供されている。

Alexaのライブコーディングを実施

続いて、ジョトワニ氏は開発者向けのAPIであるAlexa Skills Kitについて説明した。こちらはユーザー用のカスタムSkillを作ることができ、たとえば「Uberでタクシーを呼ぶ」「Fitbitで何歩歩いたか」などの機能を追加することが可能だ。ジョトワニ氏は、「当初は13しか機能を持っていなかったが、Alexa Skills Kitによって開発が行われた結果、今では1000以上の機能を持っている」とアピールする。

Alexa Skills KitはLambda、API Gatewayなどのマイクロサービスを組み合わせることで、開発することが可能だ。開発者は、ユーザーの音声とその意図をマッチングしたコンフィギュレーションデータと、リクエストに応じて動作するバックエンドを作れば、Alexaの処理が実現する。

Alexa Skills Kitがリクエストを処理して、レスポンスを返すまで

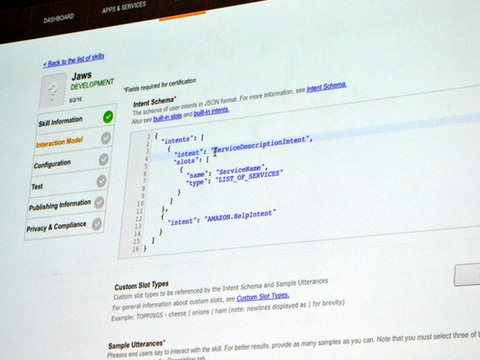

その後、ジョトワニ氏は「Lambdaとはなにか?」という質問に答えるSkillを作成するライブコーディングを披露した。まずは開発者サイトのAlexa Skills Kitにアクセスし、ユーザーの意図を定義したスキーマを登録。あとはリクエストに対応するLambda関数を作り、APIを設定すればよい。ジョドワニ氏は短時間でSkillのデプロイを完了し、ボイスシミュレーターで動作を確認するところまで進めた。

最後、ジョドワニ氏はIoT市場の拡大に向け、音声認識の世界はますます拡がるとアピールする。Echoの国内投入に関しては「国際化は重要だ」と言葉をにごしたものの、「未来はまだあるわけではない。みなさんといっしょに作るモノ。開発者と一緒に音声の未来を作っていきたい」と開発者に訴え、セッションを終えた。

この連載の記事

-

第7回

デジタル

AWS幹部に聞いたエネルギーあふれるコミュニティの作り方 -

第6回

デジタル

「農業分野のIoTでも使いやすい価格を!」AWSへ要望 -

第5回

デジタル

SIer依存脱却!AWSを自社運用する「あるフツーの会社」の勇気 -

第4回

デジタル

エンジニアを魅了するサーバーレスと進化を続けるLambda -

第3回

デジタル

「2週間でできた」日本電産のIoT基盤など、AWS事例多数紹介 -

第1回

クラウド

ようこそ洞察の時代へ!GEのCTOが語るデジタル時代の挑戦 -

デジタル

実績と未来を見せた「AWS Summit 2016」 - この連載の一覧へ