Kubernetes on ベアメタル、Watson×iOSアプリ開発者向けなどの新発表、「IBM THINK 2018」レポート

「ビジネスのためのAIとクラウド」WatsonとIBM Cloudの新発表まとめ

2018年04月03日 07時00分更新

継続的ディープラーニングサービス、iOSアプリへのWatson組み込みキット

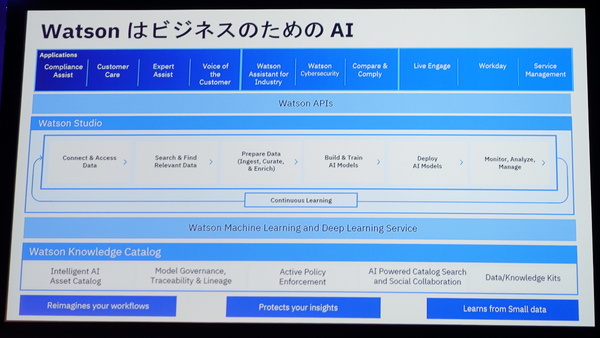

また「Watson Studio」では、今回新たに「Deep Learning as a Service」が提供開始された。Watson Studioは、データプラットフォームとAIプラットフォームを統合することで、容易かつ継続的な機械学習/ディープラーニングのトレーニングを可能にするIBM Cloud上のツールセットだ。データアセットカタログ「Watson Knowledge Catalog」やWatsonAPIとも連携する。

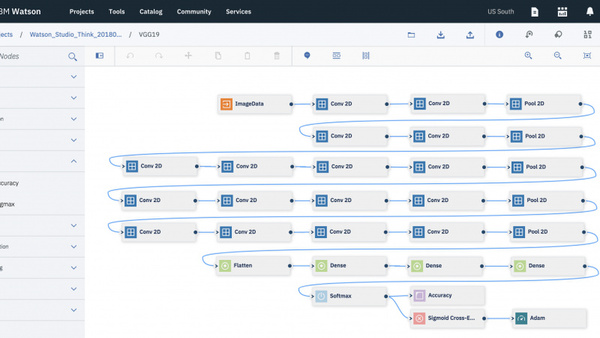

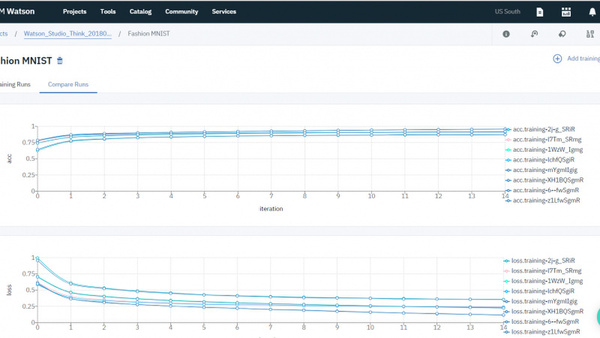

Deep Learning as a Serviceは、オープンソースのディープラーニングフレームワーク(TensorFlow、Caffe、PyTorchなど)をあらかじめ組み込んでおり、コーディングなしで操作できるGUIの「ニューラルネットワークモデラー」を備えるなど、ディープラーニングモデルの構築をより容易にする。ケニー氏は、これによってディープラーニングモデルのトレーニングにかかる時間が「数カ月から数週間へと短縮される」と説明した。

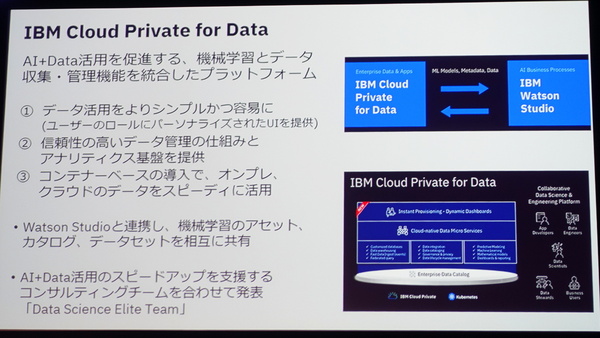

コンテナ/Kubernetesベースのプライベートクラウド(CaaS/PaaS)基盤である「IBM Cloud Private」では、この基盤にデータサイエンティスト向けのアプリケーションコンテナ群(Db2、Db2 Warehouse、Data ScienceExperience、InformationAnalyzer、InformationGovernance Catalogueなど)を追加した「Cloud Private for Data」が発表された。

Cloud Private for Dataは、Watson Studioと連携することにより、オンプレミス/IBM Cloud間で機械学習モデルやデータセットなどをシームレスにやり取りできる。そのため、たとえばオンプレミスからデータを出さずにトレーニングしたモデルを、クラウド上のアプリケーションで活用することも容易にできるという。また、データサイエンティストとアプリケーション開発者の間の“距離”を縮めることも期待できる。

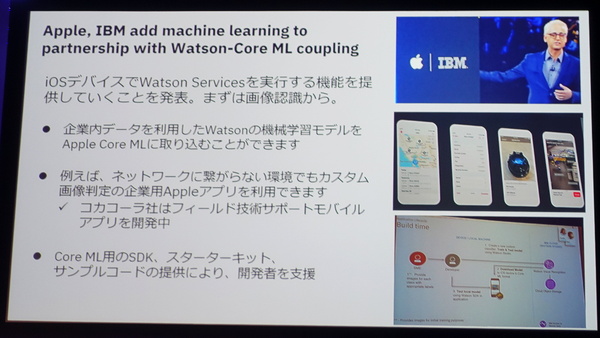

IBMでは業務モバイルアプリ領域においてアップルと提携してきたが、今回はiOSアプリ開発者向けに「IBM Watson Services for Core ML」が発表された。これは、iOSが備える機械学習フレームワーク「Core ML」にWatsonが対応し、iOSアプリ内からWatsonサービスを活用しやすくするもの。まずは画像認識(Visual Recognition)サービスから対応を開始する。発表によると、米コカコーラ・カンパニーが先行導入して、フィールドサービスにおける活用(画像認識による問題識別、コグニティブ診断、拡張現実/AR修理サポート)に取り組んでいるという。また、開発者を支援するコンソール/Swiftツール群「IBM Cloud Developer Console for Apple」もリリースしている。

NVIDIA GPUとの高速インターコネクトを備える“企業AI向けサーバー”

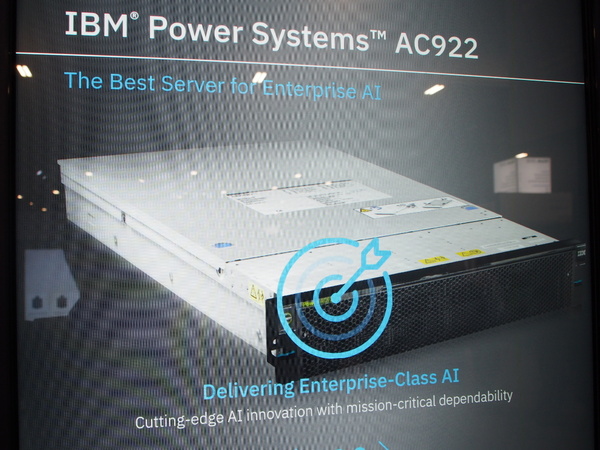

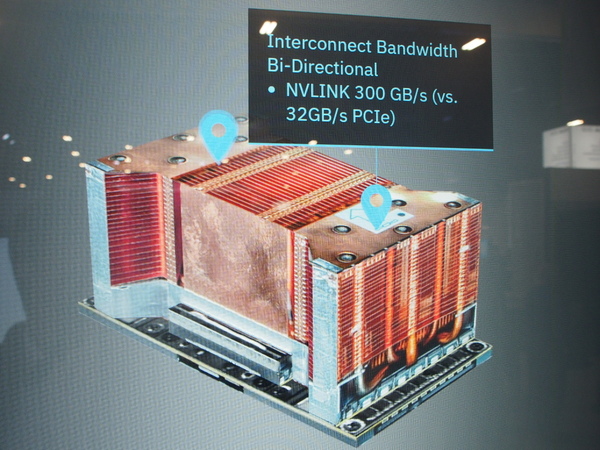

ディープラーニング/機械学習領域においてはハードウェアの新製品発表も行われた。新製品である「Power Systems AC922」サーバーにおいて、CPU-NVIDIA GPU間のダイレクト/高速インターコネクトである「NVLINK」を備えたPOWER9プロセッサを採用している。NVLINKは、PCIe(32GB/秒)を利用するx86サーバー比で9倍以上となる、300GB/秒の帯域幅を持つインターコネクトである。

IBM Cognitive Solutions SVP/IBM Researchのジョン・ケリー(Dr. John E. Kelly III)氏は、「これまで機械学習処理に1時間かかっていたものが、およそ1分間に短縮でき、しかもマシンサイズが10分の1になる」と紹介したうえで、こうした処理スピードの加速は、あらゆる分野においてAIの採用に「巨大なインパクトをもたらすだろう」と述べた。

AI/コグニティブ向けインフラ製品ディレクターのヒラリー・ハンター(Hillery Hunter)氏とIBMコグニティブシステムVPのステファニー・チアース(Stefanie Chiras)氏は、IBM Researchがチューリッヒのラボで実施した比較試験の結果を紹介した。このテストはテラバイトクラス、42億件に及ぶWeb広告クリックログデータにロジスティック回帰分析を適用し、クリック率(CTR)の予測を行うための機械学習トレーニング処理だ。

ハードウェア(上述したPOWER9サーバー)面の最適化と同時に、アルゴリズムの改良などソフトウェア面での最適化を図った結果、Google Cloud上のTensorflowクラスタ(89マシン)で70分かかっていたこの処理が、およそ90秒で済むようになったという。およそ46倍の高速化だ。さらにハンター氏は、このアルゴリズムは広告CTRの予測だけでなく、回答が2値(YES/NO)となる幅広い領域での予測に使えると説明した。

「テラスケールのデータでこのスピードなので、データセットがもっと小さければほとんど一瞬で終わるだろう」(ハンター氏)

「今回の結果は限界ぎりぎりの数値ではなく、パフォーマンスはまだ伸ばせると考えている。また、他のアルゴリズムについても対応を進め、機械学習処理を加速させていきたい」(チアース氏)