Stability.aiは1月22日、同社が開発する新しい言語モデル「Stable LM 2」シリーズから、多言語データで学習された16億パラメーターのベースモデル「Stable LM 2 1.6B」を発表。Stability AIメンバーシップに参加することで利用できる。

開発者のために最後のチェックポイントも提供

英語、スペイン語、ドイツ語、イタリア語、フランス語、ポルトガル語、オランダ語(日本語は含まれていない)の多言語データで学習された、最新の16億パラメータ小型言語モデル。

コンパクトなモデルサイズとスピードはハードウェアの障壁を下げ、個人を含む多くの開発者が生成AIのエコシステムに参加できるようになることが期待されている。

プリトレーニング(事前学習)バージョン、インストラクションチューニング(特定の指示に基づいてチューニングした)バージョンに加え、プリトレーニングフェーズ終了直前の状態(最後のチェックポイント)も提供している。

このチェックポイントにはモデルの最適化に関連する技術的な詳細(最適化関数の状態)が含まれているため、自身のデータに合わせてモデルを微調整しやすくなるという。

データの詳細に関しては、近日公開予定のテクニカルレポートでさらに詳しく紹介される予定。

モデルは無料もしくは有料のStability AIメンバーシップに参加することで利用可能(有料版は商用利用も可能)。

ベンチマークも良好

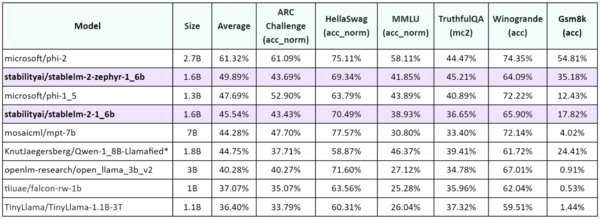

ベンチマークの結果は良好だ。多言語テキストに対する明示的なトレーニングのおかげで、ARCチャレンジ、HellaSwag、TruthfulQAなどにおけるパフォーマンスは、Stable LM 2 1.6Bが他のモデルを上回っている。

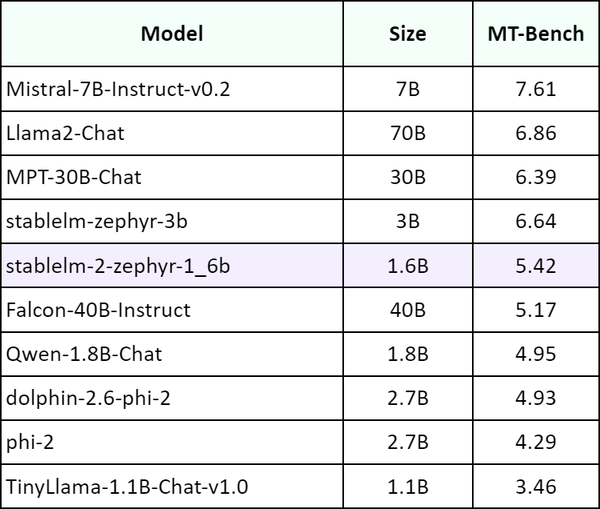

また、MT BenchでもStable LM 2 1.6Bは他の大きなモデルに匹敵、または上回ることもあったという。

昨年4月に発表された「StableLM」の第1弾は、3Bおよび7Bパラメーターと従来のものよりも少ないパラメーター数で良好な結果を得ていた。また、昨年10月にはさらにコンパクトな「Stable LM 3B」も発表されている。

今回のモデルは16億(1.6B)パラメーターとさらに小型化されたことによって、より多くの研究者が実際にローカル環境で試すことが可能になるだろう。