AWS上で「業界最大規模」のスケールテストを実施、その結果は

1000ノードの分散環境で“使える”アナリティクスは実現するか、テラデータがやってみた

2022年04月04日 08時00分更新

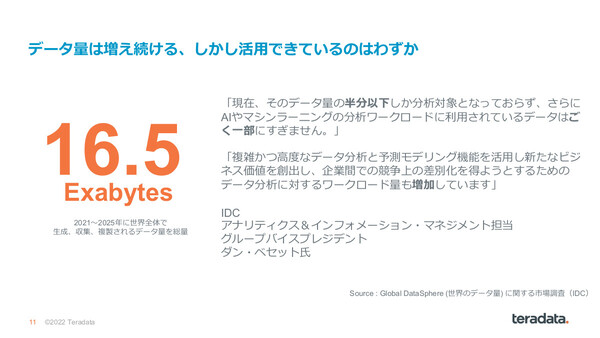

調査会社のIDCが発行したレポート「Global DataSphere - 世界のデータ量に関するする市場調査」によれば、2021年から2025年の5年間に世界全体で生成/収集/複製されるデータの総量は16.5エクサバイトに達するといわれている。しかし、その膨大なデータがすべて活用されるわけではない。同レポートによれば「現在、分析対象となっているデータは半分以下で、さらにAIやマシンラーニングといった分析ワークロードに利用されているデータはさらにごく一部」だという。

IDCの調査によれば、2021~2025年で生成されるデータの総量は16.5エクサバイト。ただし分析対象となるデータ量は半分以下で、さらにAIやマシンラーニングなど分析ワークロードに乗るのはごくわずか。一方で、ビジネスの差別化を図るために、複雑で高度なデータ分析に対するワークロード量も増加する見込み

「データドリブンな意思決定はビジネスの成功に不可欠」といわれるようになってから10年以上が経過し、実際にデータ分析を駆使することで大きな成長を遂げた企業は数多く存在する。だが、多くのデータはいまだ分析対象にすらなっておらず、データドリブンなビジネスの実現が簡単ではないことをあらためて実感する。

データがあっても分析できない――その最大の理由は、データ分析を継続的に実行する環境を構築し、維持することが難しいところにある。膨大なデータや増え続けるユーザ、アプリケーションに耐えられるスケーラビリティの担保、リアルタイム分析、レポート、データサイエンスなど多様化する分析ニーズへの対応、大量のデータを一元的に管理するシステムの構築、最小限のダウンタイムなど、データドリブンなビジネスを実現するデータプラットフォームには非常に多くの要素が求められる。

現在、多くの企業がこうしたデータ分析における課題を解決するために、AWSやMicrosoft Azureといったパブリッククラウドのサービスを活用し、分析ワークロードを実行している。パブリッククラウドの最大の魅力はそのスケーラビリティにあるが、はたして現実にはどこまでスケールできるのか。さらに、スケールしたデータ分析環境はパフォーマンスやコスト、自動化、セキュリティなどから見て、エンタープライズの厳しい要求を満たすレベルなのだろうか――。

そんな現実的な問いかけに対し、データ分析プラットフォームの老舗であるTeradataがユニークな実証を行ったので、この内容を紹介したい。

単一の巨大なアナリティクスシステムを構築し実証テスト

Teradataは2022年2月、AWSクラウド上で数週間に渡って行ったスケールテストの結果を公開した。テストの概要は以下のとおりだ。

・AWS上のサーバ(EC2)で構成、1つのテナントでスモールスタートし、1012ノードまでスケールさせた分散システム

・1023人のアクティブユーザが数千の同時クエリを実行

・100テラバイトのオブジェクトストア

・数週間という長期期間に渡って繰り返し実施

・オペレーショナルインテリジェンス(トランザクションのリアルタイム分析)とDSS(意思決定支援システム)という2つのワークロードを混在させて実行

・期間中、ハードウェアに偶発的な障害発生

このスケールテストの最大のポイントは「アナリティクス(だけ)に注力できる大規模環境を、単一システムで提供する」というところにある。本テストについて解説を行った日本テラデータ クラウド・テクノロジ・リードの笹間則克氏は、単一システムでデータ分析を実現する最大のメリットとして「分析コストを非常に低く抑えることができる」という点を挙げている。

「単一システムあれば、データ移動の回数や作業の重複を大幅に減らすことが可能になる。またワークロードが複雑に、かつマルチクラスタに渡って展開されるようになると運用が煩雑化し、アナリティクスに注力することが難しくなり、運用コストが増えてしまいがちだ。単一システムであれば、自動化やオブザーバビリティなどを介したシステム運用の簡素化やリソースの有効活用が容易になり、コスト低減につながりやすい。(運用にとらわれることなく)データアナリティクスに注力するという面で、単一システムは非常に適している」(笹間氏)

パフォーマンス/拡張性/柔軟性/コスト……得られた実績は?

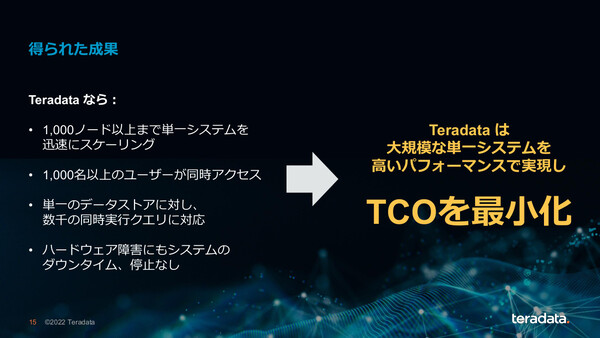

数週間に渡ったテストの結果、Teradataは以下のような実績が得られたことを発表している。

・マルチクラスタ … Teradataのワークロード管理機能およびリソース最適化機能を活用することで、大規模なクラスタ環境を柔軟に展開しTCOを最小限に抑制。また分析環境を利用するビジネスユーザには、24時間365日無停止運用の本番ワークロードに影響を与えない専用コンピュートを提供

・エラスティックスケーリング … 1つのテナントから小規模にスタートし、ポリシーにもとづいて自動的に1000ノード以上までスケール、ダウンタイムなし

・低コストのオブジェクトストレージ … Teradataの「Native Object Store」技術(Teradata Vantage on AWS / Azureの機能で、S3などデータが存在するオブジェクトストレージ内で透過的にクエリを実行する)により、大規模なエンタープライズレベルでも高いコストパフォーマンスを提供

・数千件の同時クエリ … 1023のアクティブユーザセッションで数千件の同時クエリを実現

・レジリエンシー … ハードウェアノードに偶発的な障害が発生しても停止なし

今回の単一システム上でのスケーリングテストで得られた成果。1000ノードまで迅速にスケールしつつ、リニア(線形的)な拡張性をもったパフォーマンスも実現。大規模な単一システムでもTCOを最小化できることを証明した

なお、本テストはAWS上で実施された単一システムでのスケールテストとしては最大級であることをAWS側も認めており、「2社の技術を併用した場合の(分析ワークロードにおける)性能の高さを裏付ける」(AWS EC2担当バイスプレジデント フィル・チーサム氏)結果となったことを非常に高く評価している。

* * *

Teradataは2018年にポートフォリオを一新し、データアナリティクスプラットフォーム「Teradata Vantage」をフラグシップ製品として展開、デプロイメントもAWSやMicrosoft Azureといったパブリッククラウド上でのマネージドサービスが中心で、オンプレミスの専用機がメインだった時代とはビジネスモデルが大きく変化している。

今回のスケールテストでは、AWSクラウドという世界でもっとも利用されているクラウド上で、エンタープライズユーザの厳しい分析ニーズに対し、スケーラビリティやコストパフォーマンス、レジリエンスをどこまで高い次元で実現できるかを実証した。その一方で、かつての「Teradata Database」が金融や通信の顧客から獲得していた評価――膨大で多様なデータに対して超高速でクエリを実行できるデータベースという評価――を、モダンでクラウドネイティブな環境でも達成できることを示したようにも見える。

アナリティクスに注力できる環境を最適な状態で提供する――オンプレミスからクラウドへ、「Teradata Database」から「Teradata Vantage」へとプラットフォームがシフトしても、Teradataが届けようとする価値は大きく変わっていないようだ。