TSUKUMOの『G-GEAR』といえば、デスクトップ/ノートPC問わず、多様なスペックのBTO PCやゲーム推奨モデルをラインアップするゲーミングブランドだ。ともすれば個人で購入するユーザーが大半という印象の方も多いだろうが、実際はゲームや映像制作、VRコンテンツの開発など、ハイスペックなPCが必要となる現場が多岐に渡るため、法人向けの販売でも定評がある。たとえばイベントなどでは、思わぬところでG-GEARが利用されているシーンを見かけることもできるだろう。

G-GEARを大型イベントで導入した企業の1つが、『初音ミク』をはじめとしたバーチャル・シンガー・ソフトウェアの企画・販売等で知られるクリプトン・フューチャー・メディア株式会社だ。先日9月1日~3日にかけて実施された、未来へ無限につながっていく『初音ミク』の創作文化を体感できるイベント『初音ミク「マジカルミライ 2017」』の企画展ステージでは、同社のリアルタイム3DCGコントロールシステム『R3』を利用したステージライブ『初音ミクR3ライブジェネレーティド』が実施された。『R3』といえば、2016年に逝去した作曲家・冨田勲氏と初音ミクのコラボレーション公演や、「NHK交響楽団」の創立90周年記念公演などでも使用された、3Dキャラクターの動き、表情、歌声などをリアルタイムに操作できるシステムだ(参考:R3システムWebサイト)。

今回の『初音ミクR3ライブジェネレーティド』は“体験型新ライブ”と銘打たれており、上記の『R3』システムを活用して、バーチャルでありながら“1回限りのライブ”を実現するのが特徴。しかし当然ながら、こうした先進的な取り組みを実現するためには、ハイスペックなPCを使ってキャラクターの映像をリアルタイムでレンダリング・投影する必要がある。そこで舞台機材として使われているのが、TSUKUMOのG-GEARというわけだ。

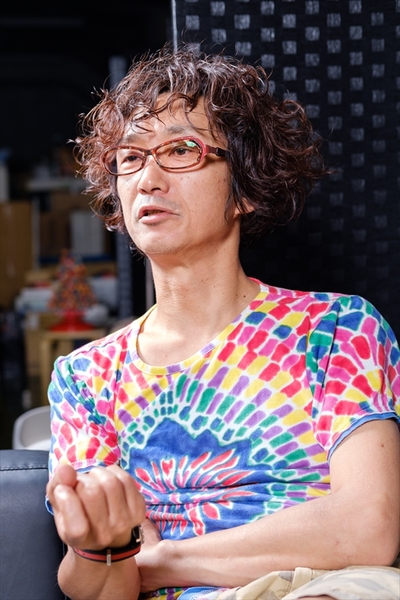

イベント用のPCはその性能もさることながら、決してトラブルを起こさない高い信頼性が求められることは言うまでもないだろう。バーチャル・シンガーである初音ミクを使った最先端の取り組みにTSUKUMOのゲーミングPCを導入した理由を、クリプトン・フューチャー・メディア株式会社のクリエイター、玖緒淑充(くおとしみつ)氏に聞いた。

「最終的には勝手にライブが進行する仕組みを作りたい」

――本日はよろしくお願いいたします。まずは、今回の『初音ミクR3ライブジェネレーティド』について、簡単に教えていただけますでしょうか(編注:インタビューはライブ実施以前に収録)。

玖緒淑充(くおとしみつ)氏(以下、玖緒) 3Dキャラクターのコンサートって、やっぱり人間がやっているわけではないので、基本的には一本の出来上がったシナリオでしか動けないんですね。そこをTSUKUMOさんのPCをお借りして、Unityでリアルタイムにレンダリングや操作をすることで、合間にインタラクション(編注:アクションに対し、相手側のシステムや機器がリアクションを返す仕組み)の要素を入れられる、というのが『R3』を使ったライブの魅力です。

そもそも僕らの目的って、最終的には僕らがいなくても勝手にライブが進行していくような仕組みを作っていけたらいいな、というところにあるんですね。そういう試みが成立しそうな技術力の範囲と、アイデアの組み合わせを突き詰めていきたいというか、今回はその最終目的に向けてのテストみたいなものだと思っています。これまでの『R3』を使った試みではユニット単位に分けてやってきた作業を合体させて、ある程度は自律っぽいことをしてみようという。

――今回のステージには『体験型新ライブ』というキャッチコピーが付いていますね。たとえば実際にミクが観客に呼びかけたり、観客に何か具体的なアクションを起こしてもらうような、そういうライブになるのでしょうか。

玖緒 実際に何かしてもらう、ということではないです。どちらかというと会場の環境から生成される(ミクが反応するための)トリガーなりパラメータを引っ張ってくるために、オーディエンスの方々に参加をお願いしているという感じですね。要するに参加型というのは僕らの都合の方が大きくて、オーディエンスの方々はこのライブが参加型であることに気が付かなくてもまったく問題ないし、むしろ気が付かない方が正解なのかもしれない。

結局、インタラクション自体はそんなに目新しいものでもないんですよね。ただ、インタラクションっぽいことって、音声認識とか画像認識でやってる人は多いと思うんですけど、もっと人が気付かなそうなところでデータを取りたいんです。たとえば温度や湿度、二酸化炭素とか。いわゆるオーディエンスの感情値みたいなものを(データとして)取ろうと思ったときに、会場の人達が大きな声を出していれば盛り上がっているのかと言うと、本当のところってわからなかったりするじゃないですか。でも、だからと言って一人ひとりに脳波計を付けるわけにもいかない。もっと接触しない形で人間の内面の感情値みたいなものを引っ張ってくる必要があるんですよね。最終的には、それをPCに(データとして)入れて、そこからジェネレートされたものを(『R3』で)吐き出していくんですが。

――最終的にはすべて自動化したい、とのことですが、現状だとライブの進行はどの程度まで決まっているのでしょうか。

玖緒 たとえば、曲順なんかは事前に決まっています。それこそ曲順を変えたり、ゲームっぽく分岐を重ねたりするのはいかにもインタラクションっぽいのですが、多分すでにやっている人がいると思うんです。そういうところはむしろ手をつけたくない(笑)。僕らの興味があまりそういうところにない、という感じですかね。

――非常にユニークな試みだと思いますが、実際に作業をされている方からすると、リアルタイムでの操作は大きな緊張感も伴うと思います。たとえば今回のライブに関しては、どのような公演になれば成功、というようなイメージはありますか?

玖緒 難しいですけど、生成しているのがバレなければ成功ですね。事前に作ったビデオをただ再生しているだけなんだな、とオーディエンスの方に思ってもらえたら、僕らとしてはある種の品質としてはそっちが正解で。リアルタイムにやっていても、そこ(技術)が目につくようだと、まだまだかなと思います。言ってみれば、結局はエンタメなので。