米Google は2014年10月27日、ウェブマスター向けガイドラインの「技術に関するガイドライン」を更新し、ウェブクローラが正しくサイトを認識するために CSS や JavaScript などのウェブレンダリングに関連するファイルも巡回できるよう配慮することを求めた。

ウェブレンダリングに関連する記述を更新

今回 Google が更新したのは、ウェブマスター向けガイドラインのうちの「技術に関するガイドライン」に記述された、ウェブページのレンダリングに関する箇所。具体的には、次の箇所が更新されている。

従来の技術に関するガイドライン

Lynx などのテキスト ブラウザを使用して、サイトを確認します(ほとんどの検索エンジンのスパイダーには Lynx で見えるようにサイトが映ります)。JavaScript、Cookie、セッション ID、フレーム、DHTML、Flash などの特殊な機能が使用されているためにサイトの一部がテキスト ブラウザで表示されない場合、検索エンジンのスパイダーがサイトをうまくクロールできない可能性があります。

新しい技術に関するガイドライン

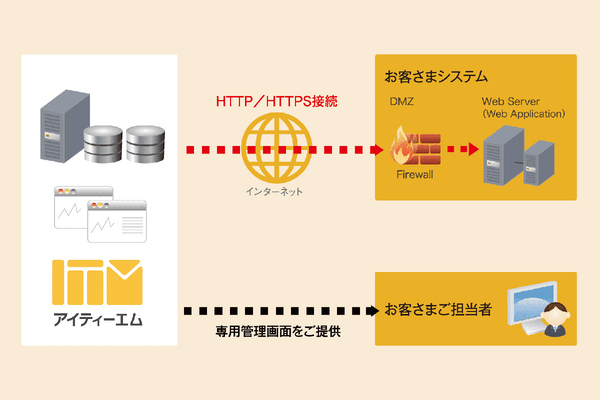

Google がサイトのコンテンツを完全に把握できるように、サイトのアセット(CSS や JavaScript ファイル)がすべてクロールされるようにしてください。Google インデックス登録システムは、ページの HTML やそのアセット(画像、CSS、Javascript ファイル)を使用してウェブページをレンダリングします。Googlebot がクロールできないページアセットを確認し、robots.txt ファイルのディレクティブをデバッグするには、ウェブマスター ツールの Fetch as Google ツールと robots.txt テスターツールを使用します。[技術に関するガイドライン]

変更後のガイドラインは、『Googlebot(クローラ)が、HTML はもちろん、CSS、JavaScript、画像などレンダリングに必要なファイルにアクセスできるようにしてください』ということを伝えている。

今回のガイドライン変更は、Googleインデクシングシステムの進化して、ウェブレンダリングに基づいたものになったことが背景にある。

インデクシングシステムが「モダンブラウザ」並に進化したことが理由

歴史的に Google を含む検索エンジンは、Lynx のようなテキストのみのブラウザのように振る舞ってきた。従って CSS や JavaScript などのウェブ技術を処理することは出来ず、テキスト分析によってウェブページを理解しようと試みてきた。従来のガイドラインは、こうした事情に基づいて設けられたものだ。

しかし今日のウェブサイトは様々な形で JavaScript や CSS を多数取り入れており、従来のままのテキストのみが処理できるブラウザのままでは、適切にウェブページを索引化することが困難となっていた。そこで今年5月に Google は、Web標準に対応したモダンブラウザのように JavaScript を実行してウェブレンダリングを行えるようにシステムを大きく変更した。もはや Google のインデクシングシステムをテキストのみ対応ブラウザとして捉えるのは正しくなく、進化したモダンブラウザのように振る舞う新しいシステムにあわせて、ガイドラインの内容も変更する必要が出てきたということだ。

CSSやJavaScriptのクロール禁止は自然検索順位に悪影響も

Let me be super clear about what this means: By blocking crawling of CSS and JS, you're actively harming the indexing of your pages. It's the easiest SEO you can do today. And don't forget your mobile site either![Pierre Far, Google UK]

Google は正しくウェブレンダリングが行えるように、CSS や JavaScript など一般的なブラウザで正常にウェブページを閲覧する(レンダリング)する時に必要とする全ての CSS ファイルや JavaScript にクローラがアクセスできるようにすることを求めている。これが今回変更されたガイドラインの趣旨だ。本件について、同社 Webmaster Trends Analyst の Pierre Far氏は、CSS や JavaScript を robots.txt などでクロール禁止することは、検索インデックスを悪化させることにほかならないと指摘している。

Updating our technical Webmaster Guidelines

http://googlewebmastercentral.blogspot.jp/2014/10/updating-our-technical-webmaster.html

Understanding web pages better [Google Webmaster Central Blog]

http://googlewebmastercentral.blogspot.jp/2014/05/understanding-web-pages-better.html

#

長らくクローラは Lynx のようなテキストブラウザを前提にしていましたから、クローリングさせる必要性がなかった CSS や JavaScript ファイルは最初から robots.txt などでクロールを禁止しておいてアクセスさせないことが半ば常識的に扱われてしまっていました。しかし上記の通りその前提が崩れクローリング事情が変化していますから、この新しい時代にあわせたルールを理解して対応しなければなりません。

Google が重点的に取り組んでいる検索のユーザーエクスペリエンスの課題を解決するためには、ユーザーが閲覧使用としているウェブページが、どのようなデバイス(スクリーンサイズ)に適した/適していないのかを機械的に判断しなければなりません。だからインデクシングシステムを改良してモダンブラウザのように処理できるようにして、ウェブページを実際にレンダリングして認識する必要が生じました。このレンダリングを行うためには CSS や JavaScript も実行しないと行けませんから、ガイドライン変更してウェブマスターの皆さん守って下さいねとお願いしているのです。