グーグルおよび傘下のGoogle DeepMindは2月15日(現地時間)、同社が2023年12月に発表した大規模言語モデル(LLM)「Gemini 1.0」の次世代モデルとなる「Gemini 1.5」を発表。グーグルの統合AIプラットフォーム「Vertex AI」および「Google AI Studio」において、試験運用機能の限定プレビューをデベロッパーと企業を対象に開始した。

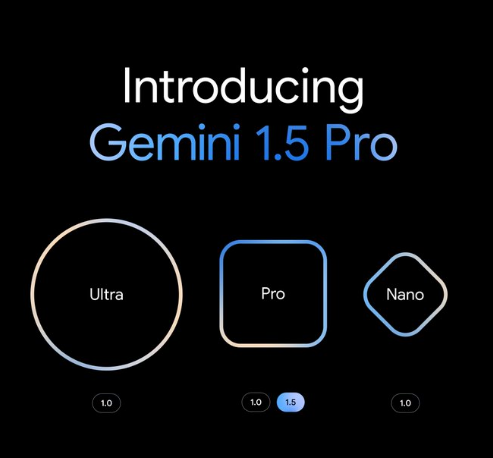

最初のリリースは「Gemini 1.5 Pro」

Gemini 1.5は「基盤モデルの開発とインフラにおけるグーグルの研究とエンジニアリングの革新に基づき、飛躍的に向上したパフォーマンスを提供」する最新LLMという位置付け。

最初にリリースされるのは中規模のマルチモーダルモデル「Gemini 1.5 Pro」。幅広いタスクに対応できるように最適化されており、これまでの最大モデル「Gemini 1.0 Ultra」と同レベルの性能だという。

Gemini 1.5は標準で12万8000トークンのコンテキストウィンドウを備えるが、2月16日から始まるプレビューでは一時的に最大100万トークンのコンテキストウィンドウで試すことができる。ただし、そのぶんスピードは遅くなるようだ。

その後のロードマップとしては、標準の12万8000トークンのモデルを一般リリースし、モデルの改善に伴って最大100万トークンまでスケールアップする価格帯を導入する予定だという。

高効率なアーキテクチャ

Gemini 1.5は「Mixture-of-Experts(MoE)」と呼ばれる新しい技術を用いて効率的にトレーニングされている。

従来の「Transformer」技術がひとつの大きなニューラルネットワークとして機能するのに対し、MoEモデルはより小さな「専門家」ニューラルネットワークに分割される。

入力されるデータのタイプに応じて、MoEモデルはその中で最も関連性の高い「専門家」のみを選択的に活性化することを学ぶため大幅に効率化されるという。

1時間のビデオ、11時間のオーディオ、70万語以上のテキストを理解

Gemini 1.5は標準で12万8000トークン(Gemini 1.0は3万2000トークン)のコンテキストウィンドウを持つ。

「トークン」とは、簡単に言えば、LLMがテキストや画像、動画、音声などを理解し処理するための基本的な単位だ。

コンテキストウィンドウが大きければ大きいほど「与えられたプロンプトでより多くの情報を取り込み処理することができ、その出力をより一貫性があり、関連性が高く、役に立つものに」できるという。

さらにすごいことに、現在Gemini 1.5の本番環境では最大100万トークンまで実行できるようになっているという。

これは、1時間のビデオ、11時間のオーディオ、3万行以上のプログラムコード、70万語以上のテキストに相当する。なお、テストでは最大1000万トークンまで成功しているという。

なお、OpenAIの最新モデルとなる「GPT-4 Turbo」のトークン数はGemini 1.5と同様の12万8000となっている。ひとつ前の「GPT-4」になると3万2000トークンまでしか扱えない。