動作確認。動くかな?

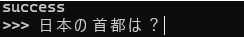

さっそく動くかどうか試してみよう。下記プロンプトを入力して実行。

プロンプト:日本の首都は?

しばらく考えた後、無事に「日本の首都は東京です」と表示された。やった!とりあえず動いたぞ!!

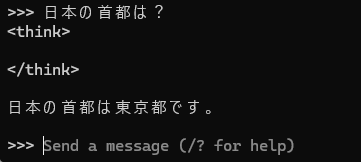

続けて下記プロンプトを実行。

プロンプト:自己紹介して

あれ?おかしいぞ?長考した上で下記のようなメタメタな回答が表示された。「こんにちは!私はDeepseek智数が作る AI Assitantです。各◯情報検索、解説、メンターになれetc confortableな一言でフレンド Like atmosphereを提供します。質問お-drivenで回答しますので、何か知りたいことがありましたらお気軽にお知りBecomes !」

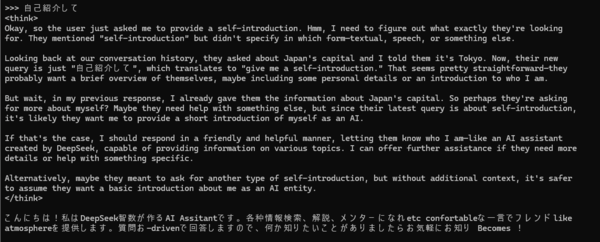

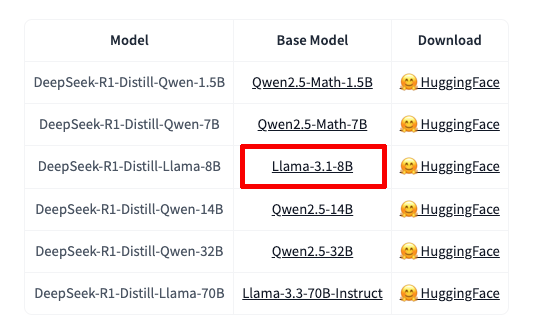

よく調べてみると、今回使用した「DeepSeek-R1-Distill-Qwen-7B」モデルは、アリババクラウドが開発した「Qwen2.5-Math-7B」というLLMをベースに蒸留したものということがわかる。

ここで「蒸留」という技術について少し掘り下げてみよう。蒸留とは、優秀だがサイズの大きいモデル(ここではDeepSeek R1)の知識を、より小さなモデル(ここではQwen2.5-Math-7B)に教え込む技術だ。

具体的には、大きなモデルに様々な問題を解かせ、その解答プロセスと結果を記録する。次に小さなモデルに同じ問題を解かせ、大きなモデルの解答と比較。小さなモデルが同じような答えを出せるよう調整を繰り返す。

この作業を大量の問題で続けることで、小さなモデルは大きなモデルの「解き方」を学んでいく。これが「蒸留」の基本的な仕組みだ。

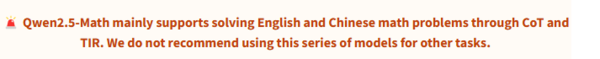

ここでベースとなった「Qwen2.5-Math-7B」のモデルカード(モデルの特徴や使用上の注意点をまとめたテキスト)を見てみると「Qwen2.5-Math mainly supports solving English and Chinese math problems through CoT and TIR. We do not recommend using this series of models for other tasks.(Qwen2.5-Mathは主に、CoTとTIRによる英語と中国語の数学問題の解答をサポートしています。このシリーズのモデルを他のタスクに使用することは推奨しません)」という重要な注意書きがあるのがわかる。

つまり、このモデルは数学に特化したモデルであり、しかも英語と中国語のみに対応している。このことから、日本語が苦手な理由も理解できる。

会話を楽しむためには別のモデルを選択する必要がありそうなので、「Ctrl+C」で一旦プロセスを終了する。

次は「DeepSeek-R1-Distill-Qwen-7B」に代わって「DeepSeek-R1-Distill-Llama-8B」を試してみることにしよう。

モデル名からわかるように、こちらはメタが開発した「Llama-3.1-8B」をベースに作られている。このモデルはテキスト生成や文書生成と言ったタスクに特化されているが、パラメーター数が7Bから8Bに増えているため、動作するかどうかはやや不安は残る。

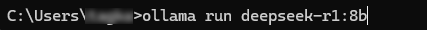

プロンプト:ollama run deepseek-r1:8b

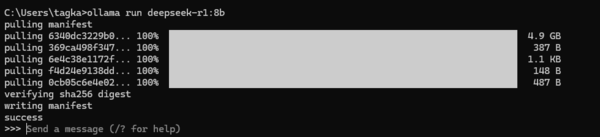

ダウンロードが開始される。容量は4.9GBと先ほどよりも少し大きいことがわかる。

ダウンロードが終わったらさっそく下記プロンプトを入力。

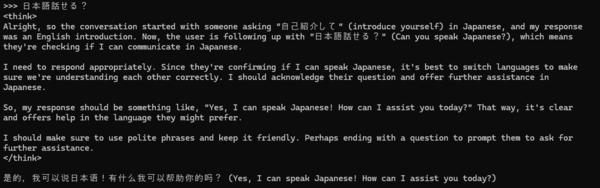

プロンプト:日本語話せる?

結果は「是的,我可以说日本语!有什么我可以帮助你的吗?(Yes, I can speak Japanese! How can I assist you today?)」と、中国語/英語併記で表示された。やはり日本語は少し苦手なようだ。

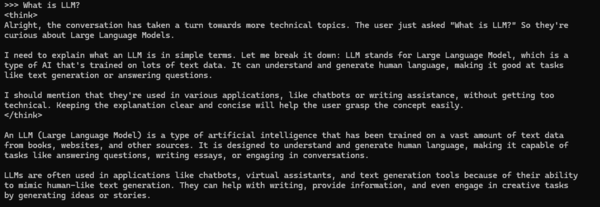

とはいえ、英語で質問するとかなりまともな回答が表示されたので、英語(中国語)さえできれば、十分ローカルで動かせると言っていいだろう。

なお、タスクマネージャーを見てみると、推論開始時にGPUの「3D」計算量が一時的にほぼ100%に跳ね上がるものの、グラフィックメモリーの利用率は「7.1/12.0GB」に留まっている。温度も37度でファンも回らなかった。

とはいえ、より大きなモデル(DeepSeek-R1-Distill-Qwen-14B)で試したところまったく動作しなかった。筆者の環境では「8B」モデルが上限のようだ。

追記:指摘を受け記事執筆後追加検証したところ、たまに不安定になることはあるものの基本的に動作したことを報告します(2025年2月15日13:52)

この連載の記事

-

第38回

AI

【無料】「NotebookLM」神機能“音声概要”をスマホで使おう! 難しい論文も長〜いYouTubeも、ポッドキャスト化して分かりやすく -

第37回

AI

OpenAIのローカルAIを無料で試す RTX 4070マシンは普通に動いたが、M1 Macは厳しかった… -

第36回

AI

無料で「Gemini 2.5 Pro」が使える!グーグル「Gemini CLI」の使い方を簡単解説 -

第35回

AI

【無料】グーグル神AIツール5選 「Google AI Studio」はこれがやばい -

第34回

AI

ローカルAI、スマホでサクッと動かせる グーグル「AI Edge Gallery」 -

第33回

AI

文章術としてのCursor入門 仕事で使うための実践編 -

第32回

AI

文章術としてのCursor入門 -

第30回

AI

グーグルAI「Gemini」 無料版と有料版の使い方を徹底解説 -

第29回

AI

動画生成AI、無料プランでも使い倒せば月200本作れます サービス同士の違いも比較しました→Runway、Pika、Hailuo、Kling、Luma、Kaiber、PixVerse -

第28回

AI

あなたの作業を超効率化する、すごいAIサービス10選【2024年最新版】 - この連載の一覧へ