アメリカの動画関連スタートアップRunway(ランウェイ)は2月6日(現地時間)、画像やプロンプトの構図やスタイルを動画に適用することで、新しい動画を作成することができる動画生成AI「Gen-1」を発表した。

同社は2022年4月に発表された画像合成モデル「Latent Diffusion」の開発元でもある。8月には同モデルをベースにした画像生成AI「Stable Diffusion」をStability AIなどと共同開発している。

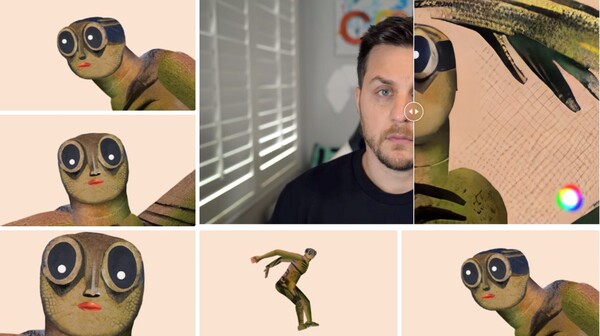

公開されたデモサイトには、「Gen-1」の5つのモードと作例が掲載されている。

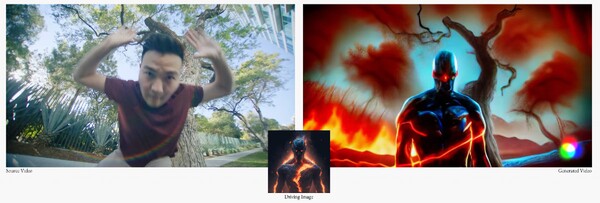

Mode 01:Stylization(スタイライゼーション)

任意の画像やプロンプトのスタイルを動画に適用して新たな動画を生成する。デモではアメコミのキャラクターのような画像を、腕を回してポーズを取る男性の動画に適用して、キャラクターが男性と同様のポーズを取る動画が生成されている。

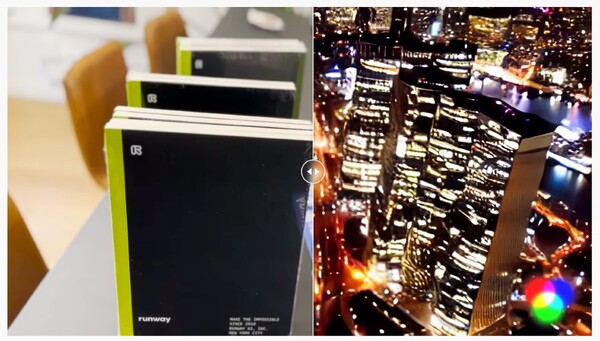

Mode 02:Storyboard(ストーリーボード)

モックアップと呼ばれるお手本となる動画を元に新たな動画を1から生成する。デモではテーブルに積み上げられた本をモックアップとした夜のビル街の動画が生成されている。

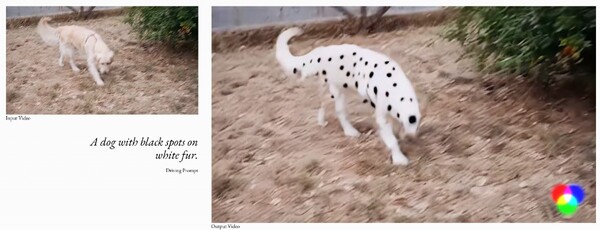

Mode 03:Mask(マスク)

映像の中の任意の部分を範囲指定し、テキストプロンプトで修正できる。デモでは歩き回る犬の動画が「A dog with black spots on white fur.(白い毛皮に黒ぶち模様の犬)」というプロンプトで修正されている。

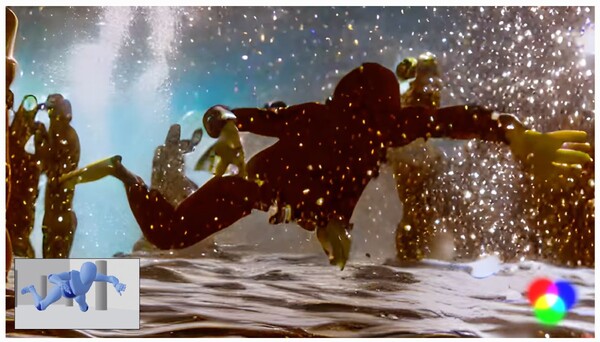

Mode 04:Render(レンダリング)

画像やプロンプトを使って、単純なポリゴンでできたモデルにテクスチャを貼り、リアルな動画を生成する。デモではポリゴンモデルを元に映画のような映像が生成されている。

Mode 05:Customization(カスタマイズ)

Gen-1の能力を最大限に発揮させるために、モデルをカスタマイズしてより忠実な結果を得ることができる。デモでは5枚の別角度で描かれたイラストを元に動画が生成されている。

まさしくStable Diffusionの動画版といった趣だが、単純に考えても動画は静止画よりも膨大なデータ量を持っているため、果たしてどの程度実用的に使えるかどうかは実際に触ってみるまでわからない。また、画像生成と同様に学習データの著作権や、倫理問題など課題は多い。

公開時期は未定だが、いち早く使用してみたい人にはアーリーアクセス用のウェイティングリストフォームが用意されている。