そもそもローパスフィルターとはなんなのか?

実際にはローパスフィルターによって何が起きているかというと、簡単に言ってしまえば画像をぼかす効果をもっている。なぜぼかす必要があるのか?

理由としては構造的な問題としか言いようがない。CCDやCMOSセンサーが連続して規則的に画素が並んでいるのと、色の判別に「ベイヤー配列」と呼ばれる方式を採用しているためだ。

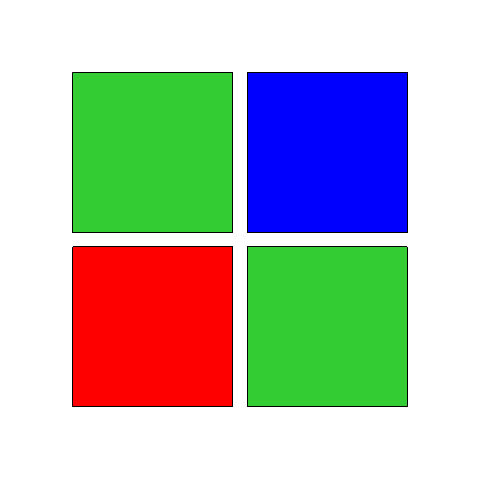

そもそもCCDやCMOSセンサーはそのままではカラー情報を得ることができない。光の強弱がわかるだけでモノクロの情報しか得ることができないのだが、カラーにするための一般的な方法として、画素ごとにR(赤)G(緑)B(青)のカラーフィルターを装着して、1つの画素で1つの色情報を得るようにしている。

これを上の図のように2×2画素で配置し、隣り合う自分とは異なる色の強弱を元に、自分の色を補完演算して決める。これにより、あたかも総天然色のようなカラー画像を得ることができようになっている。

ところが、連続した規則的な細かな模様が被写体にあって、運悪く画素単位の規則性に干渉すると、被写体には存在しない色である「偽色」や「モアレ」が発生してしまうことがある。

この偽色とモアレの原因が発生する前段階、つまりセンサーに光があたる直前で、画像を少しばかりぼかしてしまい、色の境目をなじませてしまうことで偽色とモアレの発生を防ぐのがローパスフィルターの役割だ。

つまり、レンズを通して入ってきた光はセンサーに当たる前にローパスフィルターを通過することで一度画像がボケる。センサー上にはボケた画像が結像され、R・G・Bそれぞれの単色のデータを持つ画素が周囲の色情報を元に自分の色を決めてカラー画像にして、画像を解析、シャープネスをかけて解像感を戻してデータとなる。

もちろん、ローパスフィルターでぼかし過ぎると、どんなに高性能な画像処理エンジンでもオリジナルの状態には復元できないから、ほんのわずかなレベルでしか処理はしてないと思われる。

また、メーカーごとにローパスフィルターの強弱や仕組みに差はあるので、上記の説明がすべてというわけでないが、ローパスフィルターの役目としてはおおむね間違ってはいないと思う。

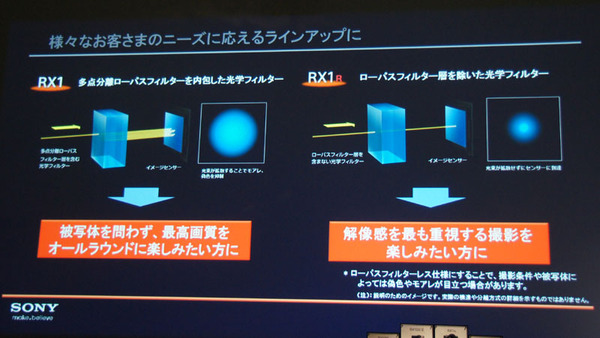

つまり、ローパスフィルターを外すことでオリジナルの状態のままの画像がセンサーに結像されるので、素の解像感で写真が撮れるということになる。

その代わりにローパスフィルターが担っていた偽色とモアレの軽減という効果がなくなるので、できあがる画像には偽色とモアレの心配が出てくるのだが、ローパスフィルターを通して解像感が低下した画像を再生成して、まともな画像にするくらい最近の画像処理は機能が上がってきているので、「偽色とモアレも画像処理で解決してしまおう」というのが最近のローパスフィルターレスブームなのだろう。