先日の記事「米Google、カメラで検索できる Googleレンズアプリを公開」で紹介した Googleレンズアプリについて、いろいろと試してみました。

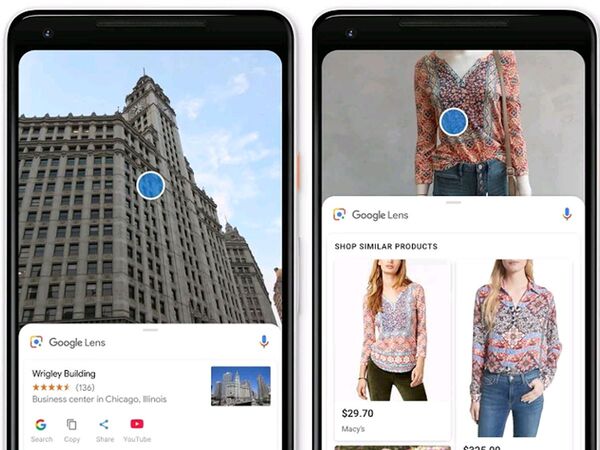

簡単におさらいすると、Googleレンズアプリは被写体を識別して文字列を認識したり、関連・類似する情報を表示することができます。詳細情報を得たい被写体にカメラを向けて画面をタップするだけと操作も簡単です。

次のスクリーンショットはカゴメ野菜一日これ一本を認識したときの例です。Similar Products として関連するカゴメ野菜飲料を表示していることがわかります。いずれかの写真をタップすると、Google検索結果画面に移動します(本例の場合は、Googleショッピングの広告が表示されるので、間接的ですが購入することもできます)。

パッケージの一部が浮かび上がっているように見えますが、Googleレンズは認識した文字列のエリアをハイライト表示するためです。日本語もきちんと認識しています。

こちらはプリングスを試した時のスクリーンショットです。同じように、違う味のプリングスを表示することがわかります。

他にも、花王のリセッシュやミンティアを認識したときは上記画面のように類似商品を表示することができました。

このように類似商品を表示した例は、実は一部に過ぎません。カメラで写している被写体の認識率はともかく、多くは「これは…コンピューター」(カメラをラップトップ PC に向けてタップしたとき)、「これは次の(選択肢を表示)うちのどれ?」(カメラを菓子パンや、マウスに向けてタップしたとき)といった具合に、被写体が何かをテキストで表示したり、被写体に記述されている文字列を認識するまでは可能なのですが、類似アイテムを表示するまでの確率は残念ながら高くありませんでした。タバコの箱はなぜかカレンダーと認識されることも。同じ被写体でも認識させるときのカメラの角度や大きさによって結果は異なりました。

欧米の著名ブランド製品なら認識率が高そうな気もしたのですが、レッドブルの認識に失敗する一方で花王リセッシュやカゴメの飲料を正しく認識するなど、精度を左右する要素がよくわかりません。

街を歩く人や雑誌の写真で気に入ったアイテムがあったら、カメラでかざして検索、商品購入~という未来まであとどれくらいでしょうか。