米Googleは2018年6月4日、AI(人工知能)を活用した、スマホカメラによるビジュアル検索を可能にするアプリ Google Lens をスタンドアロンアプリとしてリリースした。試したところ米国登録の Googleアカウントと Pixel 2 XL の組み合わせでダウンロード可能だったが、日本国内には配信されていない。

Google Lens カメラをかざして検索可能に

Googleレンズは、カメラで移した空間情報をスキャンして情報検索を可能にするアプリ。今年5月に開催された Google I/O では、次のような機能を紹介している。

- コピー&ペースト:カメラで写した文字情報を認識してテキスト情報として扱えるようになる。たとえばレストランのメニューを選択してコピー&ペーストして、友人に送信するといったことが可能。

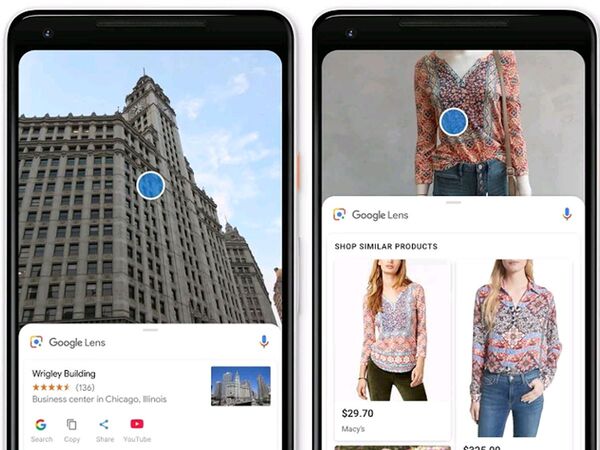

- スタイルマッチ:空間情報をスキャンして、検知したオブジェクトに色がついたドットを表示。タップすることで詳細情報を得られる。紹介されたデモでは、マネキンの服やアクセサリーを認識し、スクリーンに類似アイテムを表示するほか、タップすると詳細情報を表示した。Googleは言及しなかったがデモ画面ではSHOPアイコンも確認でき、将来的にはそのままアイテムを購入できるようにする可能性もある。

- GoogleマップでのARサポート:交差点で、Googleマップが示している進行方向が現実世界のどの方向を指しているのかわかりにくい場合がある。紹介されたデモでは、ARを利用して進行方向への矢印を表示したり、子ギツネが先導する映が流れた。

- ランドマークや店舗の情報表示:カメラを建物にかざすだけで、詳細情報を表示する。Google によると VPS = Visual Positioning System と呼ばれる技術を活用、空間情報から得られる特徴点や建物等の表面情報から現在地と方角を特定するという。

Twitter のツイートを見る限り、Pixel 2 (XL)や Sony Xperia, Samsung Galaxy など一部のスマホでインストール可能との報告があったが、一部の機能が動作しないこともあるとの声もあった。私が持つデバイスでは Pixel 2 XLでインストールできた。

試したところ、アイテムの形状や色によってまったく違うものとして認識されることもある。複数の物体が重なっていると誤認識してしまう(これは仕方ない)。スタイルマッチは買い物も可能。植物にカメラかざして情報得られるのは、精度上がると便利かも。

2020年までに検索の50%は画像と音声になる?

かつて Google や Baidu にも在籍した研究者・アンドリュー・エン(Andrew Ng:吳恩達)氏は、2020年までに少なくとも検索の50% は音声と画像による検索が占めると発言している。

Google Lens (Google Play Store)

https://play.google.com/store/apps/details?id=com.google.ar.lens&hl=en_US