国内の”知の最前線”から、変革の先の起こり得る未来を伝えるアスキーエキスパート。ニコンの坪井聡一郎氏による技術とイノベーションについてのコラムをお届けします。

前回自動走行にかかわる内容を当コラムで取り上げた翌日の7月1日、テスラの自動運転で初の死亡事故というニュースが報じられた。米国道路交通安全局(NHTSA)による公表とのことであったが、事故自体は5月7日に発生したものという。推察される事故原因として、テスラ Model Sの自動運転用センサーが強い日差しのため、車線変更したトレーラーの白い車体を見分けられなかったということのようである。

今回はこのニュースから機械学習における画像処理技術について考察し、色を扱うビジネスの可能性について思考を進めてみたい。

いかに特性を失わずしてデータを軽く扱うか

自動運転はさまざまなセンサー類を駆使して走行環境の把握を行っている。もっとも重要なセンサーは、位置関係を把握するものである。赤外線レーザー(LIDAR:ライダー)やミリ波レーダーによる測距、GPSなどを駆使し、単一のセンサーデバイスから取得したデータで判断するのではなく、複数デバイスによるデータ取得を解析することでその精度を高めている。単一のセンサーデバイスでは測定誤差が生じることがあり、マルチセンシングによってそのリスクを少しでも軽減しようと工夫されている。

たとえばGPS情報では道路上を走っていることは現状でもわかるのだが、4車線あるうちのどの車線を走っているのかというような状況を正確に反映することは難しい(今後準天頂衛星などの実用化は、数㎝程度の誤差精度に改善されると期待されている)。わずか数センチのずれが接触事故につながる状況ではGPSだけに頼ることはできず、車体の前後左右に障害物との位置関係や距離を把握するためのセンサー類を張り巡らしているのである。そのような複数のセンサーを使って精度を高めていく「センサーフュージョン」という考え方が現在徐々に広がっている。

報道で気になったのは、「強い日差しのため、白い車体を見分けられなかった」という部分で、これはどのセンサーの誤作動ととらえるべきなのかという点である。「見分ける」という表現からはカメラセンサーを想起するが、後述するがカメラは物体との位置関係を把握するにはまだ十分なデバイスと言うことは難しい。今回の事故でLIDARやミリ波レーダー等の測位センサーは反応できたのかどうかというほうが私としては気になった。

一般に、数多くのセンサーが取り付けられるほど豊富なデータを取得ができる。多くのデータを取得するということは正確な環境測定ができるというメリットがある反面、データ容量が大きくなるというデメリットも生じてしまう。リッチなデータが取得できても処理に時間がかかっては、運転の制御を行う有用な情報にはならない。0.1秒判断が遅れるだけで事故につながる走行環境下では処理の遅れが致命的な欠点になるからである。つまり自動運転の開発では、「正確性確保のためのデータサイズ」と「その処理時間」のトレード・オフを克服していく課題があると考えられる。

安全性がすべてに最優先される自動車産業では、「いかに特性を失わずしてデータを軽く扱うか」が、技術開発の重要な指針の一つになっているといってもよい。

車載カメラとデータサイズ

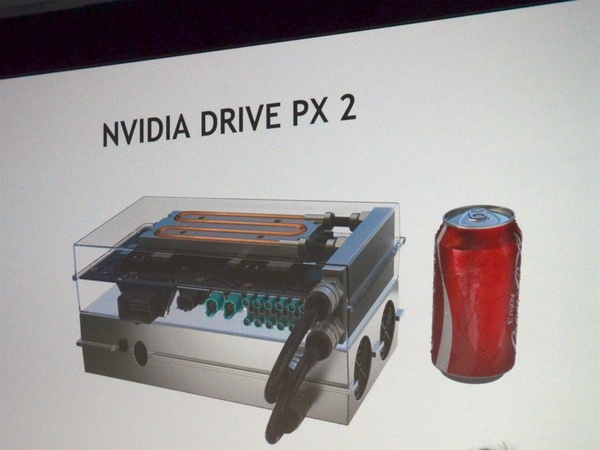

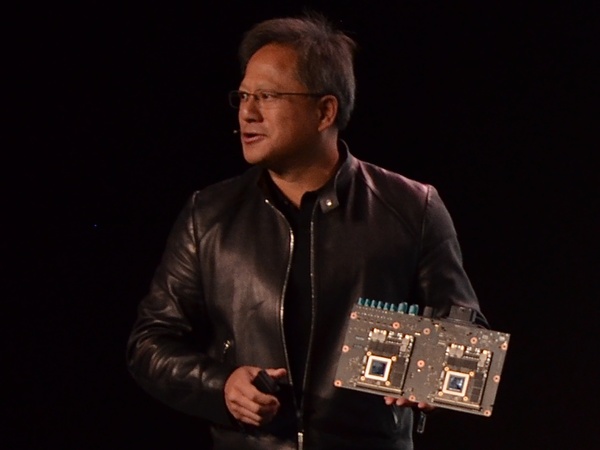

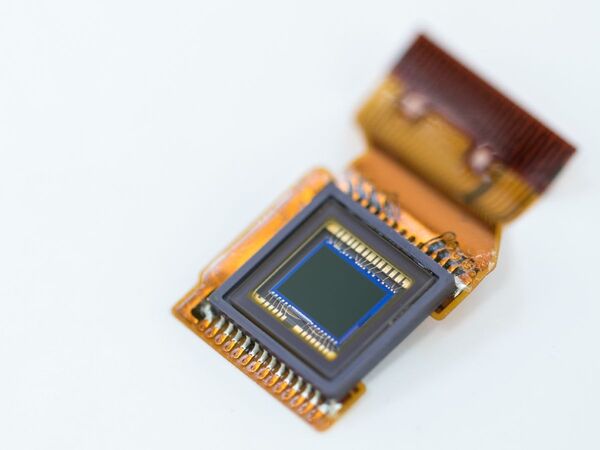

ここで画像データについて考えてみたい。昨今の自動走行車の開発では10個以上のカメラが搭載可能になるという。NVIDIA社の「Drive PX」では最大12個のカメラ入力を持ち、車両データを取り扱う際の標準規格CAN(Controller Area Network)にも対応している。現状では画素のそれほど大きくない100万画素から200万画素の間のものを中心に利用され、周囲の環境把握や物体との距離測定のために用いられているといわれている。これは、おおよそwebカメラほどの画素数とイメージで、たとえばニコンのデジタル一眼レフのフラッグシップであるD5は有効画素数2082万画素であり、両者を比較すると10~20倍の差があることになる。

仮に100万画素のカメラで単純に換算しておよそ20個分にあたるのが、D5一台分の画素数というわけである。言い換えれば、一つ一つの車載カメラが取得するデータはそれほど大きなものでないが、自動走行車ではそれらを車体のさまざまな位置に取り付けて周辺環境のセンシングを行っているのである。

「データを軽く扱う」という点での一つ目の工夫は、ハード部分で取得できる画像サイズそのものを小さくしている点にある。GPUの負荷をできるだけ減らし、処理を早くするためには小さなデータサイズのほうが扱いやすく、また、一つ一つが小さければ「カメラの数を増やしたい」というニーズへも対応できる。数が増えることで単眼カメラのデメリットを補完する効果も得られるからである。

デバイスによって決まるカメラの撮影範囲

カメラは平面で画像を取得する特性上、位置関係、とりわけ奥行きに関する情報を正確に計測することが難しい。単眼カメラの持つこうした欠点を補完するため、ステレオカメラのように複数のカメラを利用し被写体の距離を把握しようとするものもある。マイクロソフトのKinectは、ステレオカメラとしての特性を活かし物体との距離を把握しているものの一例である。

しかしステレオカメラといっても被写体との距離・角度、レンズ特性等によって測定範囲が異なるの制約が生じる。こうした仕様はセンシングを行う上の制約条件になる。人間のように首や目が自由に可動して、ちょっと動かすだけで追うことができる被写体も、カメラが固定された環境下ではそれも困難となり対象物をセンシング領域内にとらえきれないことが出てくる。つまりデバイスの組み合わせで規定される撮影範囲等の条件下で、センシングが行われるように設計されている。ステレオカメラの例でいうと、Kinectのような数メートルの範囲の被写体認識を行うものもあれば、Leap Motionのように数センチの範囲を領域とするような違いとなるのである。(KinectはRGBカメラ、深度センサー等を搭載しており、Leap Motionは赤外線カメラを搭載しているという違いはあるが、ここでは撮影範囲の違いの例として引用している)

被写体を追尾する機能も基本的にはデバイスの組み合わせによって制約される範囲で、画像センサー上に被写体認識ができる環境が前提となっているのだ。

仮になるべく広い領域の画像をセンサーの中に収めようとすると、広角のレンズ(例えば魚眼レンズのようなもの)を使うこともできるが、反面取得される画像は歪みのあるものとなることから画像を処理する段階で適正な補正を行う必要が生じる。こうしたトレード・オフの関係の中(コストなどの要件も当然考慮されて)から各社が最適と考える仕様になっていると考えられる。

機械学習で行われている画像処理

機械学習では画像の「特徴量」をいかに取得するのかという点で研究がなされてきた。「人間の顔」を被写体として認識しようとした場合、どれだけ少ない情報でそれが人だと認識できるのか。たとえば、「目」と「鼻」と「口」の画像情報で「顔」と判断するより、「目と口」の情報だけで「顔」と判断できれば情報処理量が減り、より瞬時の判断が可能になる。

技術者の工夫はこれに留まらない。構成要素である「目」や「口」について、さらにそれぞれを特徴づけているものをそぎ落とす。「目」であれば楕円の形状であったり、瞳の円であったり、その中で「まぶたのフチのライン」を「曲線」として扱い、さらにそれを部分的に抽出して、できる限り「目」という情報を認識する最小の方法を探るようなアプローチを探ったり、あるいは「目と口」との位置関係から、目的である顔認識へ、限られた情報から有機的な対応付けを導く工夫を施す。

しかし、「目」にしても「口」にしても個体差がある。目であれば、眼鏡をかけている人、髪が目までかかっている人などもいる。あるいは撮影した画像が「目」の開いた状態なのか、閉じた状態なのか、また画像自体の明るさの差も問題となる場合がある。そのためこうしたデータを扱う前には処理を加えなければならない場合が生じる。かつての機械学習の研究では、いくばくかの手が加えられ、ノイズとなりそうなデータを前処理した上で、ニューラルネットワークを活用した機械学習が行われていた。

ディープラーニングではニューラルネットワークを多層構造とし、大量のデータから特徴抽出および識別を自動で行うことができる。この技術が向上していけば、先のような面倒な前処理が不要で、データをそのまま扱えることができるのではないかという期待もあり、これも巷間にぎわす一因となっていると思われる。

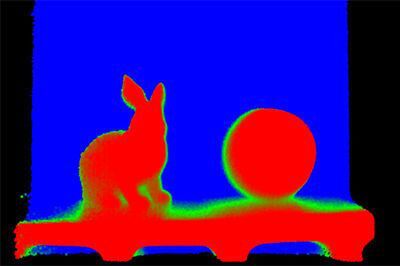

機械学習は微妙な色合いの違いを情報として利用できるか

ここで注目したいのは、ディープラーニングの処理と画像の持つ情報についてである。画像データはRGBカラーモデルによって豊かな色表現を行う。ディープラーニングでは、CNN(畳み込みニューラルネットワーク)が利用されているが、これは「畳み込み、サンプリング、全結合」という処理過程をもつ。このあたりの詳細は専門書に委ねたいが、これを画像データの色表現に当てはめてみると、RGBで取得されるカラー画像の場合、R,G,Bそれぞれのチャンネルにフィルターを畳み込まれ、単色の画像データに抽出されるようになる。また、画像そのものにも正規化を行い、データがある確率範囲で収まる処理を行うこともある。つまり組み合わせによって生み出される色表現を分解していくプロセスをとっているのである。

ところで色はそれぞれに階調があり、人間の目はそれを識別することができるが、画像センシングという点からはスペック制約を大いに受ける。日本人は古来より豊かな色表現を言葉として残してきた。「真紅」、「臙脂(えんじ)色」、「赤橙」などは赤系統を表す言葉で今でも使われるが、いずれも非常に繊細なバランスの上に成り立つ色である。ディープラーニングを始めとする画像利用の研究で、「この微妙な色合いの違いを情報として利用できているのだろうか」というのが今回の私の着目点である。

そもそもカメラとは光学的な処理によって色を表現する手段として作られた機械であるが、自動走行における画像認識技術という中では「色の識別」はまだ十分に研究・利用が進んでいない印象を持っている。信号を例にとって考えると、人間は「赤・黄・青」という色によって「進むor止まる」の判断をする。

しかし、法律によって信号はライトの順序・位置が決まっているので、ライトの光る位置が認識できればそれがどの色なのかを判断ができる。国ごとの違いはあるが、赤なのか青なのかは位置で判別できるわけである。その他車線の色の違い(白やオレンジ)についても、道路設計段階であらかじめ決まるためカーナビのようにプログラムしておくこともできる。人間のようにその場でいちいち色を見て判断しなくとも、代替的方法で対応が可能というわけである。このように色に依存しすぎず、代替的な方法でカメラが利用されているというのも自動走行技術の一つの側面と言えよう。

カメラと正確な色との特性

一方で矛盾したように聞こえるかもしれないが、そもそもカメラは正確な色を再現することが難しいデバイスである。一般的なカメラでは「18%グレー」という露出調整が行われ、反射率の低いものを明るく補正するような設定がされている。反対に反射率の高い被写体に対しては、明るさを抑えるような仕組みになっている。

またカメラは撮影環境によって誤って色を認識することもある。蛍光灯の下で撮影した写真が青っぽくなるような経験は誰にでもあるだろう。照明の持つ「色温度」が原因で、被写体の色の見え方を変えてしまう。カメラ撮影モードの「オート」設定は、撮影環境下で露出やホワイトバランスなどを自動で調整するものであるが、それでも適切に判断できないこともある。ちょっとカメラを傾けただけで、撮影画像の色が変わってしまうこともある。外を走る自動車は、朝、昼、夕という色温度が変化する太陽光の下を走行する。あるいはビルの陰の中を走行することもある。夜には、繁華街のネオンの色が被ってくることもあるだろう。車載カメラが撮影する周辺環境はこのように変化の激しい中にあり、同じ被写体の色を同じ色としてとらえることは大変難しい技術と言えよう。

冒頭で、テスラ車が強い日差しのため白い車体を見分けられなかったニュースを紹介した。テスラ車に搭載されているカメラの仕様は分からないが、今回の事故に際しては、露出補正が上手くいかず露出オーバーとなり、画像データとしてセンシングできなかったことも考えられよう。

このようにカメラはちょっとした環境変化で簡単に正確な色を見分けられなくなってしまうという特性をもつデバイスなのである。

色の活用をビジネスに取り入れる可能性

これまで話してきたように、まだ世のビジネスではセンシングした色を取り込み活用しているものは多くない。自動車の世界は法律によって規格が決められており、直接色を判別しないための工夫がみられた。見方を変えれば、代替的な方法ができない業界にこそ、色を活用したビジネス創出の可能性があると感じている。

私が色活用ビジネスの筆頭として期待しているのはファッション業界である。ファッションでは、色が重要な購買決定要因である。微妙な色の違いで顧客のニーズにフィットしなくなってしまうため、バイヤーや店舗は色の取り扱いには非常に気を遣う。近年、ファッション通販サイトが非常に増えてきているが、商品の掲載にはどこも苦労しているように感じられる。

個人取引やweb店舗をレンタルしているような「ユーザーが自由に商品写真を投稿できるようなサイト」の場合、撮影環境の違いから色の違いがはっきり分からないところも少なくない。特に同じ色の商品を複数店舗で比較し購入しようとする場合には、どの店の色が正しいのか分からないこともある。また異なる店の上着と靴、アクセサリーの色などでコーディネートを合わせたいようなニーズに応えることもなかなか難しい。結果、同じ商品をサイトに掲載しているにもかかわらず同じ色に見えないことがよくあり、ユーザーが購買する際の心理的ハードルとなっているのではないかと感じている。

それに比べ、一括して商品撮影してサイト掲載をしているところは比較的色が安定している。一例として東急電鉄・東急百貨店がIROYAと始めた「色からモノを選ぶ」サービスは面白い試みと言えよう。商品の色が安定するようなるべく近い撮影条件で商品撮影を行っている努力が感じられる。靴や洋服、雑貨の色が合うかどうかサイトからも分かるように工夫されている。一元管理のメリットということができよう。

今後ファッション業界にもシェアリングエコノミーが拡大していくと予想されている。アメリカでは既に定額で洋服借り放題のRent the Runwayのようなサービスが生まれている。このサイトは自社で商品撮影を行っていると思われるが、メルカリのように不特定ユーザーが自分の洋服を、プラットフォームを通じてシェアする方向へ発展していくことも十分に考えられる。そして別々のユーザーにより撮影された商品の色が同じく見えるようになることはサービス上大きな利点になると感じている。

またファッション以外の分野でも、農業では作物の色づきや花の色の判別に利用することも可能になると考えられる。このように色が特定産業で重要な意思決定の意味を持つ分野では、色の自動判別というイノベーションへの需要があると考えられる。とは言え、実際にこれを実現するには、数々の課題を克服しなければならない。画像センサーはカメラによって種類も異なるうえ、画像規格の標準化がなされていない状況もある。また多くの画像はJPEGのような非可逆圧縮フォーマットで流通している環境等々を考えると、容易に克服できるテーマとは言えない。しかし扱いづらい技術課題は山積するものの、日進月歩の技術革新、特にAIの目を見張る発展に、これを克服するソリューションが提供されるのではないかという期待を抱かざるを得ない。

今回「ビジネスは、その先に」で、筆者がテスラ事故を通じてイノベーションの波及を想起したのは、「色を自動的に正確に扱う」新たなビジネスである。

アスキーエキスパート筆者紹介─坪井聡一郎(つぼいそういちろう)

一橋大学大学院商学研究科修了。2004年株式会社ニコン入社。ブランディング、コミュニケーション、消費者調査、デジタルカメラのプロダクト・マネジャー等を歴任。2012年より新事業開発本部。2014年、国立研究開発法人農業・食品産業技術総合研究機構より「センシングによる農作物高付加価値化」の研究委託を受け、コンソーシアムの代表研究員を務めた。経産省主催の「始動Next Innovator2015」のシリコンバレー派遣メンバーであり、最終報告会の発表者5名にも選抜された。