Google が発表する様々な新機能やサービスは、その背景や意図・意義まできちんと把握しておくことが大切です。表面的な情報だけを拾っていると、「自分のサイトの場合」はどう対処すればいいのかがわからなくなったり、見当違いの対処をしてしまうことになりえます。

まず重くなるという事。ページの表示速度はSEOに関連してくるので、軽い方が良いのですが、はてなスター程度だと普段はそれほど高速回線なら影響はほとんど無いとは思いますが、0とは言えないですね。それと、google botをブロックしている事で悪影響が出る可能性は否定出来ません。[はてなスターはスパムになっているのか?SEOのために「はてなスター」は外すべき?]

はてなスターに対する議論は、ブログ「太陽がまぶしかったから」に掲載されている記事『はてなスターはGoogle botをブロックしてるからSEOスパム判定されないよ』をご覧頂ければ明快です。

# 事の発端となっている記事でいう『スパムとして認識してきている』とは、どのサイト(誰)に対するスパム認定なのかがよくわかりません。仮にこのケースでスパム判定されるとするならば、対象は「はてな」であってはてなスターを設置したWebサイトではないのですから、そもそも設置者が心配する事柄ではないのではないでしょうか。

Webサイトの構成上”SEO以外の理由で”利用したい機能だけれども、SEO的なリンク観点で心配事がある時は、(1) nofollow の有無、(2) robots.txtの記述 (3) 故意の順位操作要素・意図 という3点をチェックして頂くとよいでしょう。最近は特に「SEOがわかっている」担当者がいるWebサービスであれば、最初の (1) または (2) で対応していることが多いと思います。

cf. Googleがウェブマスター向けガイドライン更新、CSSやJavaScriptのクロールをブロックしないよう求める

さて本題ですが、CSS や JavaScript、画像ファイルのクロール許可について、先の鈴木ですさんが抱かれているのと同じ疑問・不安を持つ方が多いようです。これは Google の情報発信の方法にも私は問題があると思うのですが…Google の真意は、『コンテンツまたはページレイアウトに直接的に関係する CSS/JavaScript/画像はクロールできることが望ましい』(=これらがクロールできないと、正しくページレイアウトが判断できない恐れがある/コンテンツを正しく評価できなくなる恐れがある)ということです。

決して Google は、「1つでもファイル/ディレクトリへのクロール拒否をしていると、検索結果にネガティブな影響がある」とは一言も発言していません。

A lot of sites disallow crawling of JavaScript & CSS for historical reasons that are generally no longer relevant. If your JavaScript or CSS files significantly affect the content or layout of the page, we recommend allowing us to crawl them, so that we can use that additional information to show your site for queries that match content which isn't directly in your HTML responses. While unrobotting that content would make things easier for our algorithms to pick up, it would be incorrect to say that not allowing crawling would automatically trigger our quality algorithms to view your site negatively. [John Mueller, Google, Google is Blocking their js in Robots.txt But Tell Us Not To., June 2014]

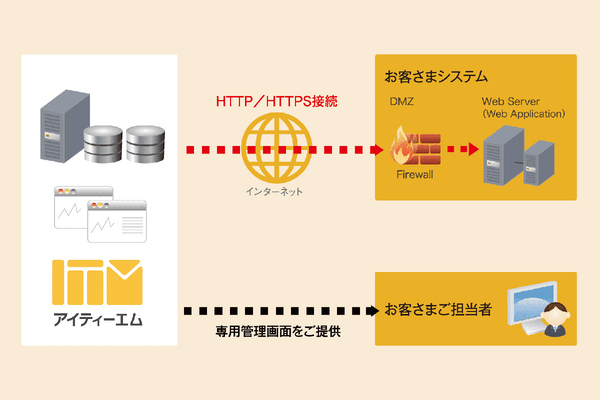

Google はウェブマスターの皆さんの活動を著しく制限する意図はないのです。だから、例えばサードパーティーが提供する JavaScript を使ったツールを利用していて、でもその提供元が JS への googlebot アクセスを拒否しているからといって、皆さんが気にする必要はないのです。それは仕方がないですし、無視していいのです。

Google のエンジニアたちもバカではありませんから、「インターネットには様々な例外が存在する」ことを前提にしてアルゴリズムを開発・調整しているのです。歴史的に、様々な理由・事情で CSS や JavaScript、画像ファイルへのクローラのアクセスを拒否してきた Webサイトは山のようにあるわけで、Google が正式に発表したからといって実際にそれが浸透するまで何年もかかることも Google はわかっているでしょう。それくらいは想定されているでしょうし、そういう前提に経てば、細かいこといちいち気にする必要はないのです。SEO は「おおざっぱな」な解釈、適当感は結構重要です。

みんな表面的な説明に踊らされて適当な解釈しすぎ。Googleだって「様々な例外」が存在することを前提にしてアルゴリズム考えているんだからさ。だから、些細なこと気にする必要ないよね

— Takahiro Watanabe (@takahwata) 2014, 11月 7