未来に火をつける: TensorRT-LLM が AI 推論のパフォーマンスを加速し、RTX を搭載した Windows 11 PC 上で動作する新しいモデルのサポートを追加

NVIDIA

Microsoft Ignite で発表された新しいツールとリソースには、OpenAI Chat API 用 のTensorRT-LLM ラッパー、Llama 2 向けの DirectML に対する RTX を利用したパフォーマンス向上、その他の一般的な LLM が含まれます

Windows 11 PC の人工知能は、ゲーマー、クリエイター、ライブ配信者、オフィス ワーカー、学生、そしてカジュアルな PC ユーザーの体験に革命をもたらし、技術史における極めて重要な瞬間を示しています。

RTX GPU を搭載した 1 億台以上の Windows PC やワークステーションのユーザーに、生産性を向上させる前例のない機会を提供します。そして、NVIDIA RTX テクノロジは、開発者が人々のコンピュータの使用方法を変える AI アプリケーションを作成することをさらに容易にします。

Microsoft Ignite で発表された新しい最適化、モデル、リソースは、開発者が新しいエンドユーザー体験をより早く提供するのに役立ちます。

AI 推論のパフォーマンスを向上させるオープンソース ソフトウェアである TensorRT-LLM(https://developer.nvidia.com/tensorrt) の今後のアップデートでは、新しい大規模言語モデル(https://www.nvidia.com/ja-jp/glossary/data-science/large-language-models/)のサポートが追加され、8GB 以上の VRAM の RTX GPU を搭載したデスクトップやノート PC で、要求の厳しい AI ワークロードをより利用しやすくなります。

TensorRT-LLM for Windows は、新しいラッパーを通して、OpenAI の人気のある Chat API とまもなく互換性を持つようになります。これにより、何百もの開発者プロジェクトやアプリケーションが、クラウド上ではなく、RTX を搭載した PC 上でローカルに実行できるようになり、ユーザーは Windows 11 PC 上にプライベートで独自のデータを保持したままにできます。

カスタムの生成 AI は、プロジェクトの維持に時間とエネルギーを必要とします。特に、複数の環境やプラットフォーム間で共同作業や展開を行おうとする場合に、このプロセスは信じられないほど複雑で時間のかかる可能性があります。

AI Workbench(https://www.nvidia.com/ja-jp/deep-learning-ai/solutions/data-science/workbench/) は統一された使いやすいツールキットで、開発者は PC やワークステーション上で事前トレーニングされた生成 AI モデルや LLM を素早く作成、テスト、カスタマイズすることができます。開発者は、AI プロジェクトを整理し、特定のユースケースに合わせてモデルをチューニングするための単一のプラットフォームを利用できます。

これにより、開発者はシームレスな共同作業と展開が可能になり、費用対効果が高くスケーラブルな生成 AI モデルを迅速に作成できます。早期アクセス リストに参加(https://developer.nvidia.com/ai-workbench-early-access)すると、この拡大中のイニシアチブにいち早くアクセスし、今後のアップデートを受け取ることができます。

AI 開発者を支援するため、NVIDIA と Microsoft は、最も人気のある AI 基盤モデルの 1 つである Llama 2 を高速化するための DirectML の機能強化をリリースします。開発者は、パフォーマンスの新たな基準(https://blogs.nvidia.co.jp/2023/10/23/tensorrt-llm-windows-stable-diffusion-rtx/)を設定するだけでなく、ベンダーを超えた展開のためのより多くの選択肢を手に入れることができます。

ポータブル AI

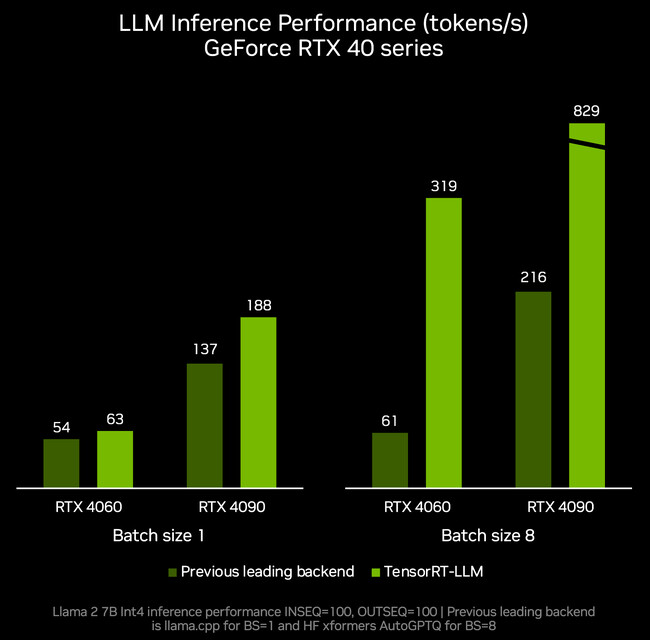

先月、NVIDIA は LLM 推論を高速化するライブラリである TensorRT-LLM for Windows を発表しました。

今月後半に公開される TensorRT-LLM の次期リリースである v0.6.0 では、推論パフォーマンスが最大 5 倍高速化され、新しい Mistral 7B や Nemotron-3 8B など、一般的な LLM のサポートが可能になります。これらの LLM のバージョンは、8GB 以上の RAM を搭載した GeForce RTX 30 シリーズおよび 40 シリーズ GPU で動作し、高速で正確なローカル LLM 機能を、最もポータブルな Windows デバイスでも利用できるようにします。

TensorRT-LLM の新しいリリースは、/NVIDIA/TensorRT-LLM(https://developer.nvidia.com/blog/optimizing-inference-on-llms-with-tensorrt-llm-now-publicly-available/) GitHub リポジトリでインストールできるようになります。新しく最適化されたモデルは、ngc.nvidia.com(http://ngc.nvidia.com/) で利用可能になります。

安心して対話

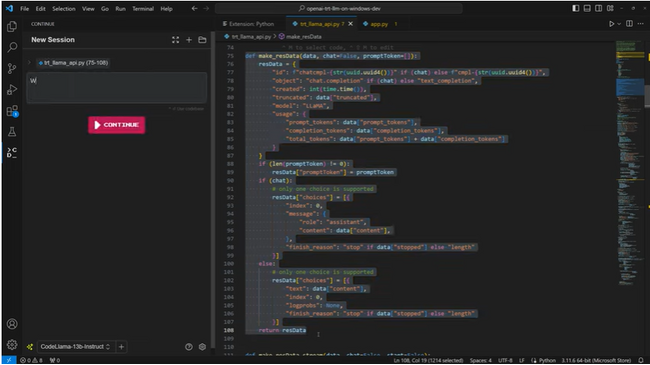

世界中の開発者やエンスージアストが、OpenAI の Chat API を使用して、ウェブ コンテンツの要約、文書や電子メールの下書きから、データの分析や可視化、プレゼンテーションの作成まで、幅広いアプリケーションに使用しています。

このようなクラウドベースの AI の1つの課題は、ユーザーが入力データをアップロードする必要があり、個人や独自で所有するデータや大規模なデータセットを扱うには実用的ではないことです。

この課題に対処するために、NVIDIA は、TensorRT-LLM for Windows が、新しいラッパーを通じて OpenAI の広く普及している ChatAPI と同様の API インターフェースを提供できるようにし、RTX を搭載した PC 上でローカルに実行するモデルやアプリケーションを設計する場合でも、クラウド上で実行する場合でも、開発者に同様のワークフローを提供します。わずか 1、2 行のコードを変更するだけで、何百もの AI を搭載した開発者プロジェクトやアプリケーションが、高速なローカル AI の恩恵を受けられるようになります。ユーザーは自分のデータを PC に保持でき、データセットがクラウドにアップロードされる心配はありません。

動画:TensorRT-LLM OpenAI Chat API Integration(https://www.youtube.com/watch?v=-P17YXulhDc&t=10s)

おそらく最も優れている点は、これらのプロジェクトやアプリケーションの多くがオープンソースであるため、開発者が RTX を搭載した Windows 上で生成 AI の普及を促進するために、それらの機能を活用し、拡張することが容易であることです。

このラッパーは、TensorRT-LLM 用に最適化されたあらゆる LLM (Llama 2、Mistral、NV LLM など) で動作し、RTX 上で LLM を扱うための他の開発者リソースとともに、GitHub でリファレンス プロジェクトとして公開されています。

モデルの高速化

開発者は、最先端の AI モデルを活用し、クロス ベンダー API で展開できるようになりました。開発者を支援する継続的なコミットメントの一環として、NVIDIA と Microsoft は、DirectML API を介して RTX 上で Llama を加速するために協力してきました。

先月発表された、これらのモデルに対する最速の推論パフォーマンスに関する発表に基づき、クロス ベンダー展開のためのこの新しい選択肢は、AI 機能を PC に導入することをこれまで以上に容易にします。

開発者やエンスージアストは、最新の ONNX ランタイムをダウンロードし、Microsoft からのインストール手順に従い、11 月 21 日に利用可能になる NVIDIA の最新ドライバ(https://www.nvidia.co.jp/Download/index.aspx?lang=jp)をインストールすることで、最新の最適化を体験できます。

これらの新しい最適化、モデル、リソースは、世界中で 1 億台の RTX PC への AI 機能とアプリケーションの開発と展開を加速し、すでに RTX GPU で高速化されている AI 搭載アプリやゲームを提供している 400 以上のパートナーに加わります。

モデルがさらに身近になり、開発者が RTX 搭載の Windows PC に生成 AI を搭載した機能を提供するようになれば、RTX GPU は、ユーザーがこの強力なテクノロジを活用できるようにするために不可欠なものとなるでしょう。